Las herramientas de inteligencia artificial (IA) se usan y usarán masivamente para la redacción de cualquier texto, incluidos artículos científicos de investigación. Cuanto antes seamos conscientes en el mundo académico, mayor será nuestra capacidad de adaptación y aprovechamiento de la IA. Los investigadores tienen acceso directo y prácticamente gratuito a decenas de herramientas de IA que les permiten escribir en un idioma que no dominan, estructurar ideas borrosas en párrafos claros y concisos, revisar cientos de artículos en pocas horas, incluso analizar datos cuantitativos sin saber usar un software estadístico. La irrupción de la IA generativa, con ChatGPT a la cabeza, está haciendo tambalear muchas instituciones y competencias del mundo académico, como el valor de la tesis, la posición jerárquica del profesorado, el trabajo minucioso de una revisión de literatura, la revisión por pares, o la importancia de saber escribir.

Sin embargo, hay algo que ni ChatGPT ni Bing ni Bard ni Claude tienen. La IA generativa no tiene una experiencia sensorial del mundo exterior basada en relaciones sociales y carece de la contextualización humana que proviene de las emociones, cultura, historias personales y otras experiencias humanas intangibles como la intuición y la empatía. Por ello, la IA no sustituye el trabajo esencial de investigación sociológica, que es preguntar a las personas qué opinan, qué hacen, qué les gusta, e interpretar qué piensan, que sienten, o cómo se organizan. La investigación social llega donde la IA no puede, que es “a la esquina del barrio”, es decir, a captar y comprender la interacción entre seres humanos y su contexto. La IA es capaz de potenciar las capacidades de investigadores y académicos, pero genera incertidumbre ante un avance tecnológico que trastoca la dinámica laboral, capacidades cognitivas y el acceso a conocimiento.

El objetivo de este editorial es reflexionar sobre el impacto de la IA en la investigación y el mundo académico. Para ello, se define y caracteriza qué es la inteligencia artificial generativa, se presentan herramientas de IA que asisten en el proceso de investigación, se realiza un análisis de escenarios futuros posibles basado en el acceso y aceptación de la IA, y se discuten posibles estrategias. Mediante este artículo se abren diversos debates sobre el futuro de la investigación, las publicaciones y la gestión de las revistas científicas.

Qué es inteligencia artificial generativa

El concepto inteligencia artificial (IA) es usado en ocasiones como un eslogan para parecer más tecnológico o simplemente para vender un producto digital. Los heurísticos que teníamos asociados a la IA eran coches que conducen solos, robots humanoides de compañía, o terminators que vienen del futuro. Curiosamente, ninguna de esas IA que visualizaban las películas ha tenido éxito aún - ni los coches autónomos, ni robots multifuncionales, ni máquinas que viajan en el tiempo. La IA que sí ha tenido un impacto mediático, comercial y laboral es la que genera textos, imágenes, audios y vídeos, la conocida como inteligencia artificial (IA) generativa.

La IA hace referencia a un conjunto de sistemas informáticos de aprendizaje y predicción. Una IA toma decisiones en base a predicciones basadas en datos con lo que ha sido entrenada y otros que adquiere al momento de ser usada. Por ejemplo, un coche autónomo decide por dónde y cómo conducir basándose en grandes datos almacenados y datos que provienen de sus cámaras. Youtube decide qué vídeo te gustaría ver en base a datos de otros usuarios, datos de los vídeos que tiene almacenados, datos de las visualizaciones del usuario, y obviamente, a sus propias instrucciones, como preferencia por vídeos largos para que el consumidor esté más tiempo en la web, o vídeos de mayor calidad, con más comentarios y más likes. Pero estas IA son más “obedecedoras” de órdenes que “creadoras”.

La IA generativa es un tipo de inteligencia artificial conocida popularmente por crear contenido nuevo y original en formato texto, imagen, audio o vídeo. Uno de los primeros precursores de la IA generativa fue Eliza, un programa informático de procesamiento de lenguaje natural creado en la década de 1960 que podía simular una conversación con un terapeuta. En los años 1980 se impulsó la investigación de redes neuronales artificiales, que son la base de la mayoría de las herramientas de IA. Una red neuronal es un modelo de computación que funciona como un conjunto de nodos, cada uno con sus habilidades. Cada nodo representa una neurona, y sus habilidades son las funciones matemáticas que realiza, por ejemplo, analizar el tipo de palabras, el sentimiento asociado a la palabra, o el uso de signos. Cuando se enfrentan a una tarea (prompt), los nodos trabajan juntos, pasándose información y combinando sus habilidades para resolver la tarea. En una red neuronal, las neuronas se organizan en capas, equipos de nodos agrupados según sus habilidades. La primera capa recibe la información inicial (prompt). Después, pasan la información a la siguiente capa, otro equipo de nodos con habilidades diferentes. Este proceso continúa hasta que la última capa de neuronas, o el último equipo de nodos, produce la respuesta final o resultado de la tarea.

Al igual que las neuronas humanas pueden aprender y mejorar sus habilidades con la experiencia, las redes neuronales también aprenden y mejoran su rendimiento a medida que se usan y se les proporcionan más datos. A través del entrenamiento y uso, las redes neuronales ajustan sus conexiones y funciones matemáticas para mejorar su capacidad para resolver tareas. Las redes neuronales con muchas capas realizan lo que se denomina deep learning o aprendizaje profundo. El machine learning (o aprendizaje autónomo) es un conjunto de algoritmos basados en procesar grandes datos para aprender de ellos y generar un resultado, que puede ser una predicción. El deep learning (o aprendizaje profundo) es un subtipo de machine learning basado en redes neuronales de muchas capas, lo que permite realizar tareas de alto grado de complejidad y sofisticación.

En 2017, un grupo de investigadores de Google, introdujo una nueva arquitectura de red neuronal llamada transformer (Vaswani et al., 2017). El transformer es una forma de procesar datos, especialmente texto, de manera más eficiente y precisa que las arquitecturas anteriores ya que utiliza un mecanismo llamado “atención”, que permite a la red neuronal centrarse en partes específicas de los datos que son más relevantes para completar una tarea. Las arquitecturas anteriores para el procesamiento del lenguaje tenían limitaciones como lentitud y dificultad para manejar secuencias largas de datos, por ejemplo, procesar varias frases. El transformer supera estas limitaciones al introducir la atención, que permite a la red neuronal procesar datos de manera paralela y más rápida. Además, la atención permite a la red neuronal capturar relaciones a largo plazo en los datos, por ejemplo varios párrafos, lo que es necesario para tareas como la traducción automática y la generación de texto coherente. Los modelos GPT (Generative Pretrained Transformer), como ChatGPT, utilizan una versión modificada de la arquitectura transformer con una gran cantidad de capas y se entrenan con grandes conjuntos de datos de texto para descubrir relaciones intrínsecas entre las palabras. Estos GPT son útiles para tareas de procesamiento del lenguaje natural, como generación de texto, traducción, respuesta a preguntas y clasificación de texto, entre otras. ChatGPT decide qué escribir y cómo hacerlo en base a los grandes datos con lo que fue entrenado y la instrucción (prompt) que recibe. Para tomar esas decisiones realiza predicciones sobre qué es lo más probable que se añada al texto de entrada.

Pero ¿por qué cuando se escribe la misma instrucción (prompt) ChatGPT crea un texto diferente y nuevo? ChatGPT, al igual que otros modelos de lenguaje basados en la arquitectura transformer, es estocástico, es decir, tiene un elemento de aleatoriedad en su comportamiento. Cuando el modelo decide qué palabra generar a continuación, no siempre elige la palabra con la probabilidad más alta. Selecciona palabras basándose en una distribución de probabilidad, lo que puede llevar a variaciones intencionadas en las respuestas. Además, los modelos de lenguaje, incluyendo ChatGPT, suelen tener un parámetro llamado “temperatura” que controla el grado de aleatoriedad en la generación de texto. Una temperatura más alta resulta en respuestas más diversas y menos predecibles, como redacción más creativa, mientras que una temperatura más baja produce respuestas más deterministas y coherentes, como redacción más formal.

La IA generativa es indetectable. Si bien es cierto que han surgido aplicaciones que intentan discernir qué porcentaje del texto ha sido escrito por humanos y cuál por una IA, la adaptabilidad de las herramientas de IA les permite superar rápidamente los desafíos de detección. Intentar parar el uso de ChatGPT con la amenaza de los detectores es una batalla perdida desde el inicio ya que han emergido aplicaciones que parafrasean texto o crean contenido de manera tan sofisticada que resulta indetectable. En lugar de tratar de frenar el tsunami de IA en la academia con detectores, resulta más útil conocer en profundidad sus potencialidades y limitaciones.

Herramientas de IA para la investigación

Los investigadores enfrentan el desafío de dominar múltiples competencias: diseño de la investigación, concepción teórica, análisis cuantitativo, cualitativo, interpretación, innovación y grandes dotes de comunicación escrita, incluida la proficiencia en el inglés. Es un estándar elevado que no todos pueden alcanzar en cada dimensión. Tradicionalmente, la solución ha sido externalizar ciertas habilidades, ya sea mediante la contratación de servicios especializados o la incorporación de coautores adicionales. Aunque las herramientas de IA no solucionan todo, sí posibilitan que determinadas tareas puedan hacerse de forma más rápida, por ejemplo, escribir mejor en otro idioma o entender teorías sofisticadas y tablas de resultados complejas. El uso de IA en la investigación puede hacer que los investigadores se centren más en la interpretación, reflexión y creatividad, y menos en encontrar frases grandilocuentes, identificar artículos relacionados, o limpiar bases de datos. Por otro lado, el uso excesivo de la IA puede llevar a debilitar capacidades cognitivas, como leer menos o aumentar la dependencia tecnológica. El debate sobre las ventajas y desventajas de la IA ha resurgido en la academia, pero aún hay falta de consenso sobre cómo abordar esta tecnología (Akinwalere e Ivanov, 2022; Lainjo y Tsmouche, 2023). Mientras algunos investigadores ven la IA como una herramienta valiosa para mejorar la eficiencia en la investigación, otros expresan preocupaciones sobre calidad de la investigación asistida por IA (Zheng y Zhan, 2023). Para saber de qué es capaz la IA generativa actual en la investigación, revisamos herramientas de IA que tienen el potencial de transformar la forma en que se realiza la investigación, se enseña y se gestiona la academia.

Las herramientas de IA con impacto en la investigación pueden agruparse en cinco grupos: las IA generadoras de texto, las IA que realizan una revisión de literatura, las IA que leen y sintetizan, las que analizan y visualizan datos, y las que proveen feedback del artículo.

Las herramientas de IA generadoras de texto más famosas y usadas son chatbots conversacionales como ChatGPT, Bing Chat de Microsoft, Google Bard, y Claude. Escriben en el estilo, tono e idioma que queramos, pero crean alucinaciones. La alucinación (hallucination) en IA se refiere a la generación de resultados que pueden sonar plausibles pero que son incorrectos en cuanto a los hechos o no están relacionados con el contexto dado. Si pedimos a ChatGPT que nos ayude a escribir un artículo científico es posible que cite autores y artículos que no existen, o puede inventarse los nombres de instituciones. Sin embargo, existen otras herramientas más especializadas en la redacción científica, como Scite y Elicit. Scite es una herramienta de IA generativa de texto que responde preguntas insertando citas y referencias a investigaciones reales. A diferencia de ChatGPT, Scite no se inventa libros ni artículos, sino que busca citas de artículos científicos que soporten o contrasten el argumento. No es capaz de escribir un texto largo, solo tres o cuatro párrafos cortos, por lo que permite complementar las evidencias plasmadas en un artículo.

Hay diversas herramientas de IA especializadas en realizar una revisión de literatura. La más potente es Elicit, un asistente de investigación completo: encuentra artículos de investigación a partir de queries, resume las principales conclusiones, redacta párrafos, operacionaliza conceptos, sugiere cadenas causales, hasta discute posibles preguntas de investigación. Mientras que desconocemos cómo fue entrenado ChatGPT, Elicit ha sido “alimentado” con artículos científicos. Elicit es como tener un colaborador, coautor y ayudante, todo en uno, y de momento gratis.

Otra herramienta útil para realizar una revisión bibliográfica es Incetiful. A diferencia de los buscadores clásicos como Scopus o Scholar Google, Inciteful no depende de palabras claves, sino de quién cita a quién. A partir de un conjunto de artículos seleccionados por el usuario, Inciteful realiza un análisis de los artículos y libros que son citados por este grupo de papers. Es decir, identifica otros artículos similares por tener citas en común. Automáticamente crea una red de artículos conectados entre sí por tener referencias en común. Inciteful es una herramienta que realiza un análisis de redes bibliométricas basado en citas en común. A partir de este análisis, Inciteful identifica: artículos similares, artículos “viejos” en esa área de estudio que pueden ser considerados clásicos, review papers, artículos más importantes por ser altamente citados, artículos más recientes, autores muy citados, y revistas que publican sobre el tema. Su creador, M. Weishuhn, es un desarrollador informático que quiso ayudar a su mujer a realizar una revisión de literatura y vio las dificultades que afrontan los académicos para identificar artículos o estar al tanto de las novedades.

Otro conjunto de herramientas son las que asisten en el proceso de lectura y síntesis de artículos científicos. SciScape es una herramienta que contesta preguntas a partir de acceder a un artículo científico. Como dice en su eslogan “La manera más rápida de leer y entender la literatura científica”. Esta herramienta de IA resume, responde preguntas, y es capaz de explicar tablas de resultados o fórmulas matemáticas incluidas en un paper. Si para saber si un artículo es interesante normalmente se lee el abstract, la introducción, la metodología y los resultados, y en todo ello se invierte más de una hora, con esta herramienta de IA se puede “escanear” todo el artículo en un par de minutos.

Otro grupo de herramientas de IA son las que analizan datos, como Advanced Data Analysis, un plugin de ChatGPT que es capaz de realizar análisis estadísticos o análisis de redes a partir de una base de datos. ChatGPT ha llegado acompañado de un conjunto creciente de plugins, que son módulos complementarios que permiten ejecutar muchas otras tareas, como acceder a cálculos matemáticos, buscar referencias bibliográficas, o interactuar con vídeos. Metafóricamente, los plugins son como las aplicaciones que se instalan en un móvil. Los desarrolladores de plugins se benefician de que ChatGPT es un modelo de lenguaje avanzado, y ChatGPT ve incrementada su capacidad de hacer tareas y responder a las demandas de los usuarios, sobre todo ante el surgimiento de competencia con otras herramientas de IA similares como Bing, Bard, o Claude.

Advanced Data Analysis es uno de estos plugins de ChatGPT y sirve para interactuar con una base de datos. ¿Qué significa esto de interactuar con una base de datos? Advanced Data Analysis permite pedir mediante texto (sin escribir ningún código) qué quieres analizar, cómo quieres analizarlo, e incluso qué visualización hacer de los datos. Por ejemplo, “haz un análisis de regresión lineal múltiple con esta variable dependiente y estas variables explicativas”, y ChatGPT responde presentando la tabla de coeficientes de regresión y hasta comentando los resultados (Figura 1). Y lo mismo si se solicita realizar análisis factorial, ANOVA, o incluso un análisis de redes con su correspondiente gráfico y sus indicadores de centralidad (Cárdenas, 2023). Advanced Data Analysis supone un punto de inflexión en el análisis de datos y la enseñanza de técnicas cuantitativas ya que reduce el tiempo dedicado a aprender un software. Esto podría potenciar que las asignaturas basadas en enseñar análisis de datos se enfoquen más en la interpretación con los resultados y qué hacer con los hallazgos, y menos en programas informáticos.

Fuente: elaboración propia.

Figura 1 Análisis de regresión lineal múltiple realizado con el plugin Advanced Data Analysis de ChatGPT y la base de datos World Values Survey de USA

¿Peer-review mediante IA?

Si los autores usan la IA -y la usarán-, ¿pueden las revistas científicas basar sus revisiones también en herramientas de inteligencia artificial? ¿Aceptarían los autores que sus papers sean evaluados con la asistencia de una IA? Varias herramientas, algunas basadas en redes neuronales, son usadas por las revistas científicas para controlar el plagio, identificar revisores, detectar errores estadísticos, revisar la estructura, o informar sobre las contribuciones, véase Kousha y Thelwall (2023) para una valoración de estas herramientas. Estudios previos como Checco et al. (2021) evidenciaron que una herramienta de IA usada para asistir en el proceso de peer review es óptima para evaluar el formato y plagio, medianamente útil para valorar la relevancia del artículo, pero no tan buena para detectar el rigor, originalidad y contribución. Yuan et al. (2022) desarrollaron un modelo de procesamiento de lenguaje natural y encontraron que las revisiones de artículos eran más detalladas, pero poco constructivas ya que no argumentaban los aspectos negativos. En 2023 se lanzó AcademicGPT, una herramienta de IA que provee feedback sobre la fortaleza del argumento, coherencia, y originalidad del artículo. Al estar basado en un modelo GPT, puede resultar útil para evaluar la redacción científica y la aclaración de conceptos.

Los contrarios al uso de la IA en la evaluación del conocimiento científico arguyen que los modelos de lenguaje de gran tamaño (LLM) son opacos -se desconoce con qué datos han sido entrenados-, y sesgados al estar basados en datos pasados. Los que defienden el uso de la IA en la revisión de artículos científicos tienen dos argumentos principales. Primero, el tiempo de evaluación se reduciría drásticamente con el uso de la IA ya que una “máquina” puede proveer una valoración mucho más rápida que un humano. Segundo, el conocimiento que un revisor humano tiene sobre un tema puede ser parcial u obsoleto, mientras que herramientas de IA especializadas pueden valorar de forma más global al tener acceso a grandes bases de datos científicas.

El proceso de revisión de un paper científico es complejo, time-consuming y se lleva criticando desde hace años porque vive del altruismo de profesores e investigadores, por el tiempo que el manuscrito está en evaluación, y por la valoración sui generis que los revisores hacen del artículo. El número de artículos que recibe una revista ha aumentado considerablemente y con ello el número necesario de revisores. La Revista Española de Sociología (RES) ha pasado de evaluar algo menos de 100 artículos en 2017 a casi 300 en 2023. Los editores son los encargados de leerlos y realizar un primer filtro sobre la calidad del artículo. Si el artículo es potencialmente publicable pasa a peer review. Hasta que se toma una decisión pueden haber pasado dos meses y la aceptación final desde que se envió el artículo oscila entre los 3 y 5 meses. Mucho tiempo cuando los puestos de trabajo o las retribuciones salariales dependen de las métricas de publicación. Solo un porcentaje pequeño de los artículos enviados son finalmente aceptados, entre un 10% y un 17% en revistas como la RES, REIS, y RIS. La alta competencia, sumado a los tiempos de espera y criterios de calidad pueden generar frustración en los investigadores.

De ahí el auge de revistas del grupo Frontiers o MDPI, como International Journal of Environmental Research and Public Health (IJERPH) o Sustainability, en las que el proceso de revisión y decisión tarda 10-15 días, el porcentaje de aceptación es mayor, y en 20-30 días el artículo puede estar ya publicado en línea tras el pago de un fee (APC) de unos 2.500 euros. IJERPH es la revista en la que más publicaron autores españoles entre 2020 y 2022, y se estima que la empresa editora MDPI recibió unos 10 millones de euros solo por la publicación de los artículos de autores españoles, la mayor cantidad de fondos de proyectos de investigación en España (Repiso y Delgado-Vázquez, 2023). En 2023, Web of Science expulsó a esta revista (IJERPH) de sus listados por no cumplir criterios de selección de calidad. En esta línea, Repiso et al. (2021) mostraron que la mayoría de artículos publicados en Sustainability por autores afiliados a centros españoles poco tenían que ver con sostenibilidad o áreas afines.

El éxito de journals como Sustainability es un indicador de los problemas que afrontan las revistas y la comunicación de los resultados científicos en forma de artículo: la selección y remuneración de los investigadores está basada en publicaciones científicas y las citas de las revistas, el proceso de revisión por pares está basado en el altruismo de profesores e investigadores, el trabajo de revisión de artículos es poco reconocido, ha habido un aumento significativo de envío de manuscritos con la consecuente carga de trabajo, dificultad de compaginar el trabajo de evaluación de manuscritos con otras múltiples tareas docentes y de gestión, y un tema poco discutido pero interesante: el poco uso que se hace de los artículos científicos. Hay artículos que nunca son citados ni leídos. El 32% de los artículos publicados en revistas de ciencias sociales indexadas en Web of Science no recibieron ninguna cita después de 5 años de su publicación (Larivière et al., 2009). Aunque las citas no son el único indicador importante, un estudio sobre la presencia de la sociología en medios de comunicación muestra que la mención de estudios sociológicos en periódicos en muy baja (Navarro Ardoy et al., 2021). La transferencia de conocimiento entre la academia y la sociedad es un tema pendiente de mejorar. La excesiva concentración de esfuerzos en el artículo puede estar debilitando otras formas de dar a conocer y usar el conocimiento generado con la investigación como la aplicación práctica o la divulgación en medios para alcanzar a audiencias más amplias.

¿Son las herramientas de IA generativa la solución a los problemas de las revistas científicas y el mundo de las publicaciones? ¿Es la irrupción de la IA generativa el cometa que estábamos esperando para transformar y mejorar los procesos de comunicación científica? La decisión de usar la IA en la evaluación es controvertida y algunas instituciones políticas buscan regularla ante el temor que genera. La propuesta de ley de la Unión Europea sobre la inteligencia artificial no aborda específicamente el uso de la IA en la investigación o la revisión de artículos científicos. Sin embargo, sí clasifica la evaluación del rendimiento académico, como la calificación de proyectos mediante IA, como un sistema de IA de alto riesgo. Por ello, el uso de la IA en la evaluación debería cumplir, según la propuesta de la Unión Europea, con requisitos rigurosos de calidad, transparencia y supervisión humana (Eur-Lex, 2021).

Análisis de escenarios futuros posibles

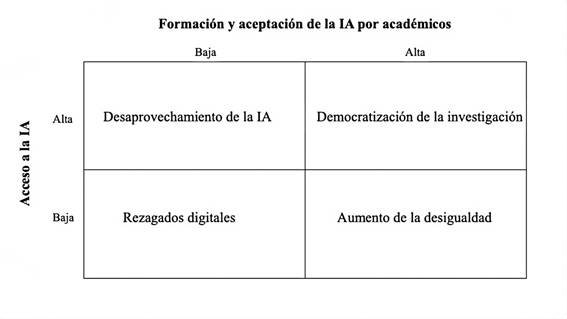

En los últimos tiempos, han proliferado seminarios y talleres sobre cómo afrontar los desafíos que genera la IA en la academia. Como los avances tecnológicos son tan rápidos resulta útil visualizar cómo será el futuro de la IA en la academia. Una forma de diagnosticar qué sucederá en el futuro es a través de la descripción de escenarios posibles (Rodríguez Díaz, 2020). Una manera de crear escenarios es mediante el cruce de dos variables. Se crean así cuatro combinaciones tipo según las opciones de las variables. Para pensar en el futuro, usamos dos variables que condicionarían el impacto de la IA en la investigación: el acceso a herramientas de IA, y la aceptación de la IA por los académicos.

Acceso a herramientas de IA

La variable acceso a herramientas de IA se refiere a la facilidad con la que los investigadores y académicos pueden disponer y utilizar herramientas de IA en sus actividades de investigación. Esta variable se puede dividir en dos posibles opciones: acceso alto y acceso bajo.

Hay alto acceso cuando las herramientas de IA están ampliamente disponibles para los investigadores y académicos. El coste de uso de estas herramientas es bajo, lo que significa que los investigadores pueden acceder a ellas sin incurrir en gastos significativos. Además, no hay regulaciones restrictivas que limiten el uso de la IA en la investigación ni barreras legales o burocráticas que impidan o limiten la IA en el ámbito académico.

Hay bajo acceso a herramientas de IA cuando existen regulaciones estrictas que restringen el uso de la IA en la investigación, ya sea por preocupaciones éticas, de privacidad, o de seguridad. Las regulaciones del uso de la IA pueden ser a nivel macro (leyes que restrinjan el uso de la IA), a nivel meso (normas en las universidades o asociaciones científicas), o a nivel micro (revistas que restrinjan el uso de la IA). Además, el acceso es bajo cuando los costes económicos asociados al uso de la IA son altos, lo que hace que su adopción sea prohibitiva para muchos investigadores, especialmente aquellos que trabajan en instituciones con recursos limitados. ChatGPT tiene una versión sin coste, pero el acceso a su versión más avanzada con los plugins tiene un coste de 20 euros al mes. Midjourney, la herramienta de IA generadora de imágenes, empezó siendo gratis pero ya tiene un coste mensual de 10 euros. ¿Y si la estrategia de las empresas de IA es hacernos dependientes al uso de la IA para después elevar significativamente los costes? Esta estrategia de mercado ya fue implementada por Amazon o Aliexpress que iniciaron sus ventas asumiendo pérdidas para crear dependencia del comercio online, cambiar costumbres y posteriormente elevar el precio de sus productos. En resumen, el acceso alto a la IA implica costes bajos y regulaciones mínimas, mientras que el acceso bajo implica costes altos y regulaciones estrictas.

Formación y aceptación de la IA por académicos

La variable formación y aceptación de la IA hace referencia al grado en que los académicos e investigadores están familiarizados con las tecnologías de inteligencia artificial y están dispuestos a incorporarlas en sus actividades de investigación. Esta variable es importante porque la adopción de la IA en la academia no solo depende de la disponibilidad de herramientas de IA, sino también de la disposición de los académicos para utilizar estas herramientas.

Hay alta formación y aceptación de la IA cuando los investigadores están bien formados en el uso de tecnologías de IA y están dispuestos a incorporarlas en sus actividades de investigación. Esto puede deberse a la existencia de programas de formación en IA, a la percepción que la IA puede mejorar la eficacia y eficiencia de la investigación, o a una cultura académica favorable a la introducción de IA en las universidades y enseñanza.

Hay baja formación y aceptación de la IA cuando los académicos e investigadores tienen poco conocimiento en el uso de tecnologías de inteligencia artificial y pueden ser reacios a incorporarlas en sus actividades de investigación. Esto puede deberse a la falta de programas de formación en IA, a la percepción que la IA es compleja o difícil de usar, o a una cultura académica que es cautelosa o resistente al cambio. Si así fuera, es probable que la adopción de la IA en la academia sea lenta y las herramientas de IA se utilicen de manera menos efectiva.

La combinación de estas cuatro categorías crea cuatro escenarios futuros posibles (Figura 2).

Fuente: elaboración propia

Figura 2 Escenarios futuros posibles sobre el impacto de la IA en la investigación

Democratización de la investigación: alto acceso a herramientas de IA y alta formación-aceptación de la IA

En este escenario posible, las herramientas de IA están ampliamente disponibles y los académicos están bien formados y dispuestos a utilizarlas. La investigación se acelera, multiplica y democratiza. Se acelera porque el tiempo invertido en publicar se puede reducir, lo que lleva a generar más manuscritos en menos tiempo. Se multiplica porque cada vez hay más personas tratando de publicar en diferentes idiomas. El conocimiento de un idioma ya no es un impedimento para publicar en revistas de cualquier lugar del mundo. Se democratiza porque la diversidad en la comunidad de investigación aumenta: las barreras de entrada se reducen y más personas pueden participar en la generación de conocimiento, lo que puede llevar a una mayor variedad de temas y aproximaciones. Es probable que aumenten las colaboraciones entre investigadores debido a la posibilidad de trabajar en línea con autores que hablen otro idioma.

Las revistas científicas reciben más artículos y requieren más personal y recursos para gestionar la avalancha de manuscritos, lo que potenciaría el uso de la IA en el peer review y la emergencia de nuevas revistas que garanticen una rápida evaluación y publicación. Cabe recordar que el coste de maquetación de los artículos también se puede reducir con la mayor disponibilidad de herramientas tecnológicas. Debido al aumento de artículos rechazados y a un aumento de la cultura investigadora, se revalorizan formatos de difusión alternativos como preprints. Es posible que disminuya el valor de los artículos de investigación o publicaciones en revistas científicas. El valor del paper científico podría reducirse en los procesos de selección de personal, remuneración salarial, y asignación de fondos debido a que es por todos conocida la automatización del proceso de investigación y publicación. Esto impulsaría nuevos criterios de valorar la investigación como métricas de impacto social, transferencia de conocimiento, contribuciones de la investigación a la educación, políticas, consultorías o acciones sociales.

Desaprovechamiento de la IA: alto acceso a herramientas de IA y baja formación-aceptación de la IA

En este escenario, las herramientas de IA están ampliamente disponibles y son asequibles para los académicos, pero estos tienen poca formación en el uso y pueden ser reacios a adoptarlas. Como resultado, la adopción de la IA en la academia es lenta y se concentra en un pequeño grupo de investigadores. La mayoría de los académicos no aprovechan las ventajas de la IA. Mientras que otros sectores como empresas y estudiantes sí usan la IA para realizar sus tareas, la academia se resiste al cambio. Esta divergencia entre estudiantes y empresas que adoptan IA, y académicos que no la utilizan, puede alimentar la percepción de que la universidad es una institución obsoleta, de escaso valor, y utilidad limitada.

Además, es probable que se cree una brecha significativa entre unos pocos académicos que sí usan la IA para realizar sus trabajos y la mayoría que no la usan. En esta línea, las revistas científicas podrían recibir un mayor número de artículos provenientes del reducido grupo de académicos que emplean la IA para hacer su investigación. Este grupo de académicos tendría mayores oportunidades de publicar en revistas de alto impacto, exacerbando aún más la desigualdad interna en el ámbito académico. Si las revistas científicas tampoco usan las herramientas de IA para la gestión es probable que continúen los problemas actuales: lenta revisión por pares, y altos costes en la edición y maquetación de artículos. Asimismo, las revistas y los investigadores estarían desaprovechando las ventajas que las herramientas de IA generativas ofrecen para la difusión de los hallazgos: resúmenes para audiencias más amplias, vídeos divulgativos, o podcasts.

Aumento de la desigualdad: bajo acceso a herramientas de IA y alta formación-aceptación de la IA

En este escenario, aunque los académicos están bien formados y dispuestos a utilizar herramientas de IA, el acceso a estas herramientas es limitado debido a costes elevados y regulaciones restrictivas. Como resultado, la adopción de la IA en la academia es lenta y se concentra en instituciones con elevados recursos. Los académicos de países con menos recursos o donde las regulaciones son más estrictas pueden tener dificultades para mantenerse al día con los avances en la investigación impulsada por la IA. La diversidad en la comunidad de investigación disminuye, ya que las barreras de entrada son altas y solo aquellos con acceso a herramientas de IA pueden participar en la generación de conocimiento. En este escenario, la academia se vuelve más desigual y menos inclusiva.

La alta demanda e interés en la IA, combinado con las restricciones de acceso, podrían generar protestas en la comunidad académica y demandas para revisar y adaptar las regulaciones. Doctorandos, jóvenes investigadores y profesores de instituciones con bajos recursos pueden tener dificultades para aprovechar las ventajas que ofrece la IA en la investigación y, por tanto, publicar menos. La falta de acceso podría resultar en que solo un pequeño grupo, principalmente de instituciones afluentes, domine las publicaciones en revistas de alto impacto. Aunque al mismo tiempo, dado que la aceptación de la IA es alta, pero el acceso es limitado, es probable que surjan colaboraciones estratégicas entre académicos e instituciones. Estas colaboraciones podrían ser una forma de compartir recursos y acceso a herramientas de IA. En respuesta a la demanda de la comunidad académica, podría emerger un mercado negro para acceder a suscripciones a herramientas de IA con la consecuente posibilidad de proliferación de malware y problemas de seguridad. También habría desigualdad entre las revistas que sí pueden costear la IA y las que no, con la consecuente disparidad en tiempos de revisión y edición.

Rezagados digitales: bajo acceso a herramientas de IA y baja formación-aceptación de la IA

En este escenario, tanto el acceso a herramientas de IA como la formación y aceptación de la IA por parte de los académicos son bajas. Las barreras de acceso, combinadas con la falta de formación y aceptación, resultan en una adopción extremadamente lenta y limitada de la IA en la academia. La falta de acceso y adopción de la IA podría limitar la innovación. Solo aquellos pocos académicos con recursos y disposición para innovar en el proceso de investigación usarían las herramientas de IA. Ante la falta de formación y aceptación de la IA, esta tecnología generaría desconfianza y toda discusión sobre su uso sería sobre la ética y privacidad, lo que perpetuaría aún más la resistencia al uso de la IA. Las instituciones académicas continuarían enfocándose en ofrecer formación tradicional, ya que la mayoría de los profesores no tendrían acceso a herramientas de IA ni estarían dispuestos a utilizarlas. La falta de adopción de la IA en la academia podría afectar la reputación de las universidades, que podrían ser vistas como rezagadas en comparación con otros sectores que adoptan rápidamente la IA. La mayoría de las revistas científicas continuarían realizando la revisión por pares de forma tradicional.