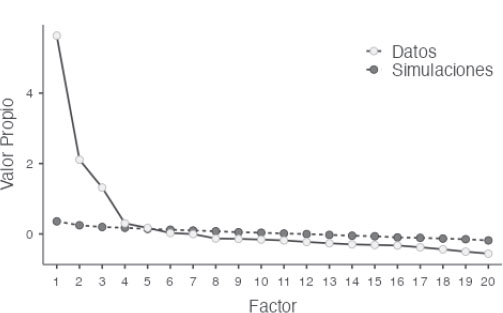

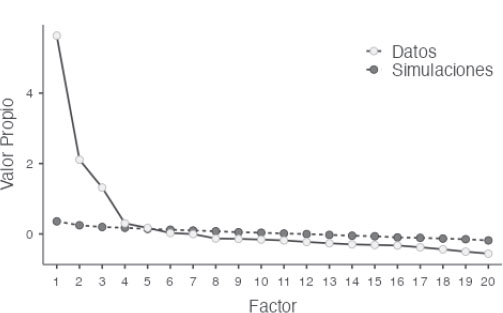

GRÁFICO I. Gráfico de sedimentación con resultados del análisis paralelo

https://doi.org/10.4438/1988-592X-RE-2023-402-595

Marta Tourón

https://orcid.org/0000-0001-5430-4198

Universidad Internacional de la Rioja

Enrique Navarro-Asencio

https://orcid.org/0000-0002-3052-146X

Universidad Complutense de Madrid

Javier Tourón

https://orcid.org/0000-0001-8217-1556

Universidad Internacional de la Rioja

Resumen

El desarrollo de instrumentos de medida en el ámbito de las altas capacidades en España es escaso. El déficit en la identificación de estos alumnos se debe, en parte, a esta carencia. Los sistemas actuales de evaluación se centran en un enfoque global que recomienda utilizar fuentes de información e instrumentos diversos, como las escalas de detección, que vayan más allá de las puntuaciones de los tests de inteligencia o aptitudes, entre otros. La importancia de las variables co-cognitivas, de ordinario maleables, ha sido puesta de manifiesto por muchos autores, de modo que la triangulación de fuentes de información complementarias se considera esencial. Aquí se aborda por primera vez el estudio de la validez de constructo de la Escala de Padres de las GRS 2 (Gifted Rating Scales) en España, con una muestra de 1334 padres y madres. Se llevó a cabo un estudio factorial exploratorio y confirmatorio, AFE y AFC, y se ha tenido en cuenta la métrica de las variables y su normalidad multivariada adecuando los análisis. Se emplearon métodos de estimación de mínimos cuadrados ponderados. Se han estudiado 8 modelos y, finalmente, se propone una estructura de cuatro factores de primer orden y dos factores de segundo orden que explica el 58% de la varianza. Los índices de ajuste del modelo son satisfactorios (CFI, .98; TLI, .97; GFI, .98), la validez convergente (AVE, por encima de .54) y la Fiabilidad Compuesta, con valores entre .78 y .92 muestra un resultado aceptable. La estructura propuesta mejora la original de tres factores. Esta escala es la primera validada en España y aporta una medida para la identificación de los alumnos de alta capacidad relevante. Este estudio se completará con la validación de las otras dos escalas para profesores que componen el GRS 2, y que se está llevando a cabo por los autores.

Palabras clave: escala de detección, altas capacidades, identificación, validez de constructo, análisis factorial confirmatorio.

Abstract

The development of measurement instruments in the field of high abilities in Spain is scarce. The deficit in the identification of these students is due, in part, to this lack. Current identification procedures focus on a global approach that recommends using various information sources and instruments, such as detection scales, that go beyond intelligence or aptitude test scores, among others. The importance of co-cognitive variables, usually malleable, has been highlighted by many authors, so that the triangulation of complementary information sources is considered essential. Here, for the first time, the study of the construct validity of the GRS 2 Parents Scale in Spain is addressed, with a sample of 1334 fathers and mothers. An exploratory and confirmatory factorial study, AFE and AFC, was carried out, and the metrics of the variables and their multivariate normality have been taken into account, adapting the analysis 637 87 11 47 is accordingly. Weighted least squares estimation methods were used. Eight models have been studied and, finally, a structure of four first-order factors and two second-order factors is proposed, which explains 58% of the variance of the scores. The fit indices of the model are satisfactory (CFI, .98; TLI, .97; GFI, .98), the convergent validity (AVE, above .54 and Composite Reliability, between .78 and .92) show an acceptable result. The proposed structure improves the original three-factor one. This scale is validated in Spain for the first time and provides a measure for the identification of students with high ability. This study will be completed with the validation of the other two scales for teachers that make up the GRS 2, which is being carried out by the authors.

Keywords: gifted rating scales, high ability, gifted identification, construct validity, confirmatory factor analysis.

La concepción de la inteligencia entendida como capacidad o aptitud y el talento como aplicación de la misma a diversos dominios, han experimentado una evolución de forma continua, desde autores como Galton (1869) o Terman (1925) que describían la inteligencia como un rasgo único, innato e inmutable, y ponían el énfasis en su cuantificación y medida a través de pruebas de cociente intelectual, a la explicación de la capacidad como desarrollable, surgiendo nuevos modelos como los de Gagné (2015, 2018, 2021), Renzulli y Delcourt (2017), Renzulli y Gaesser (2015), Renzulli (2016), Renzulli y Reis (2018, 2021), Pfeiffer (2015a, 2017a) u Olszewski-Kubilius et al. (2019), Worrell et al. (2019) entre otros, que destacan también la importancia tanto del contexto como de factores y variables co-cognitivas (Renzulli, 2021) necesarias para el desarrollo del talento.

Por otra parte, la conveniencia de identificar las necesidades psicoeducativas que faciliten la planificación de la atención educativa de cada escolar, en particular de los alumnos con alta capacidad, y la concepción evolutiva del potencial, hacen necesario recurrir a fuentes de información más allá de las pruebas asociadas a la medición de la inteligencia o las aptitudes específicas. Precisamente, la importancia del contexto y las variables no cognitivas o psicosociales, maleables, que proponen los modelos más actuales (Pfeiffer, 2018), pone en primer plano la necesidad de contar con instrumentos de diversa naturaleza que permitan valorar otras dimensiones más allá de las puramente intelectuales, o algunas dimensiones de éstas, a partir solo de los tests estandarizados. Así, el recurso a fuentes de información diferentes, provenientes del contexto escolar o familiar se convierten en una necesidad (Pfeiffer y Blei, 2008). Sin embargo, son muy escasos los instrumentos disponibles para este cometido, particularmente en España.

En este contexto, parece especialmente importante ofrecer herramientas para poder detectar el potencial de los alumnos y contribuir a que el número de estos, identificados en razón de sus capacidades, sea progresivamente mayor. Aunque en los últimos años en España se han aportado a la comunidad educativa algunas escalas de valoración para padres, profesores y alumnos como las desarrolladas por Rogers (2002) y adaptadas al castellano por Tourón (2012), disponibles en su modalidad online desde 2019, o las Escalas Renzulli (Renzulli et al., 2001) para la valoración de las características de comportamiento de alumnos con altas capacidades, los instrumentos disponibles en español son escasos o carecen de estudios de validación adecuados.

Por ello, este estudio pretende llevar a cabo la primera validación de las Escalas de Detección de alumnos con altas capacidades en su versión para padres (Gifted Rating Scales. Parent Form, GRS 2) en español. Esta escala, de nuevo desarrollo, pertenece a la versión dos de las GRS, que incluye otras dos para profesores, actualmente también en fase de validación en nuestro país por los autores de este trabajo. Las GRS 2, particularmente las escalas de profesores son las de mayor cobertura, bondad psicométrica y con una gran cantidad de investigación en inglés llevada a cabo.

Las Gifted Rating Scales fueron originalmente diseñadas en 2003 y creadas inicialmente para determinar si un alumno podría beneficiarse de participar en algún programa para alumnos con alta capacidad, utilizadas en conjunto con otras pruebas diagnósticas, como parte de una evaluación integral del alumno (Pfeiffer y Jarosewich, 2003). Sin embargo, la revisión de la literatura previa al desarrollo de las escalas originales puso de manifiesto ciertas carencias y limitaciones en la adecuación técnica y utilidad de las existentes (Jarosewich et al., 2002), lo que reforzó la necesidad de disponer de una herramienta de detección que pudiera ser completada por los profesores, que les ayudara a valorar los comportamientos observables de sus alumnos que podrían tener alto potencial y que fuera fácil de usar, válida y fiable.

Así, las GRS originales incluían dos formas para profesores (GRS-P para alumnos en la Etapa Infantil; y la GRS-S para alumnos de Primaria hasta Secundaria). Esto permitía a los profesores valorar comportamientos que podrían indicar alta capacidad con estudiantes entre 4 y 13 años.

En 2019 se decide revisar las escalas empleadas hasta entonces y añadir una nueva: la Escala de Detección de comportamientos dotados, en su forma para padres (GRS 2 Parent Form) (Shaughnessy, 2022).

La escala para padres GRS 2, objeto de este trabajo, se basa en un modelo multidimensional de las altas capacidades y consta de elementos que se encuentran dentro de tres amplias dimensiones: capacidades cognitivas, capacidades creativas y artísticas y habilidades socioemocionales. Los ítems que componen esta última dimensión son nuevos. Los ítems de las dimensiones de capacidades cognitivas (8 ítems) y capacidades creativas y artísticas (8 ítems) se adaptaron de un subconjunto de los ítems en las escalas originales de profesores, GRS (Pfeiffer y Jarosewich, 2003). Solo se seleccionaron aquellos ítems que reflejaban comportamientos o características indicativas de alta capacidad y observables por un padre fuera de un entorno educativo.

El desarrollo de la dimensión de competencia socioemocional, se llevó a cabo con el objetivo de ampliar la evaluación de la alta capacidad, más allá de una lente tradicional que se enfoca principalmente en las “fortalezas de la cabeza” -que incluyen resolución de problemas, memoria, razonamiento y creatividad-, a una visión más holística y completa del estudiante que incluye las “fortalezas del corazón”, como las fortalezas personales e interpersonales (Pfeiffer, 2001, 2017b). Esencialmente, el propósito era incorporar una perspectiva de psicología positiva a la escala para padres GRS 2.

Hasta el momento no se ha estudiado la estructura de esta escala en español. Precisamente, el objetivo central de este trabajo de validación es analizar la estructura de esta nueva escala para padres y aportar evidencias sobre la validez de constructo de la misma.

Se buscó la colaboración de los participantes a través de las asociaciones de padres y madres con niños y jóvenes con altas capacidades (58), otras instituciones y centros educativos, quienes recibieron una carta en la que se les explicaban los detalles de la escala y las características de su colaboración. También se solicitó la participación a través de diversas redes sociales. En todos los casos la colaboración fue voluntaria y anónima. La escala estuvo disponible para que pudiera ser respondida en línea entre abril y octubre de 2022.

La muestra obtenida estaba compuesta por un total de 1334 padres y madres. Una vez depurados los datos el total de respuestas válidas fue de 1109; las madres aportaron 977 (88.1%) y los padres 113 (10.2%). Los 19 casos restantes no registraron esta información. Un 61% de ellos indicaron que valoraban a hijos y el 39% a hijas.

La edad media de esos niños y niñas valorados por sus padres es de 10 años (DT= 3.5 años), con casos desde los 4 a los 18 años. El 55% de ellos estaban cursando los diferentes cursos de la etapa de Educación Primaria, el 25% en Educación Secundaria Obligatoria, el 14% en Educación Infantil y el 6% restante en Bachillerato. En la tabla I se incluye la distribución de casos en los diferentes cursos ordenados de mayor a menor participación.

TABLA I. Frecuencias y porcentajes de casos en los diversos cursos

Curso |

Frecuencias |

% |

6º Primaria |

111 |

10.0 % |

4º Primaria |

105 |

9.5 % |

5º Primaria |

103 |

9.3 % |

1º Primaria |

102 |

9.2 % |

2º Primaria |

95 |

8.6 % |

3º Primaria |

94 |

8.5 % |

1º ESO |

88 |

7.9 % |

2º ESO |

79 |

7.1 % |

2º Infantil |

65 |

5.9 % |

3º ESO |

62 |

5.6 % |

3º Infantil |

59 |

5.3 % |

4º ESO |

50 |

4.5 % |

1º Infantil |

33 |

3.0 % |

1º BACH. |

32 |

2.9 % |

2º BACH. |

31 |

2.8 % |

Naturalmente, esta muestra no es representativa del conjunto de los padres y madres de hijos con altas capacidades; no obstante, ha de tenerse en cuenta que, para el propósito del estudio, que es aportar evidencias iniciales de la validez y estructura de la escala, es suficiente que la muestra tenga adecuada amplitud y varianza.

Las Gifted Rating Scales Second Edition (GRS 2) son una revisión de las GRS originales (Pfeiffer y Jarosewich, 2003), e integra los mismos elementos clave que su predecesora, pero con algunas características nuevas, entre ellas una forma para padres, que es la que aquí se estudia. Esta versión para padres de la GRS 2, aporta información de los alumnos y permite obtener puntuaciones basadas en comportamientos observados en diferentes contextos, lo que facilita una visión más holística de las habilidades de estos.

La GRS 2 Parent Form, consiste en un cuestionario dirigido a padres de alumnos con edades comprendidas entre los 4 y los 18 años. El inventario consta de un total de 20 ítems agrupados en tres dimensiones que se describen a continuación.

Las dimensiones de la escala y los ítems que la componen se recogen en la tabla II. Cada ítem se valora con una escala tipo Likert de 6 puntos: (1) Nunca, (2) alguna vez, (3) con cierta frecuencia, (4) bastantes veces, (5) casi siempre y (6) siempre, con arreglo a la cual los padres valoran la frecuencia con la que observan la conducta señalada en cada ítem (p. e. “Tiene una imaginación activa”).

TABLA II. Dimensiones e ítems de la escala

Dimensión |

Ítems |

Capacidad Cognitiva |

I2, I3, I4, I13, I14, I17 |

Capacidad Creativa/Artística |

I7, I9, I10, I11, I12, I18, I20 |

Habilidades Socio-Emocionales |

I1, I5, I6, I8, I15, I16, I19 |

Las escalas, originalmente en inglés, fueron traducidas independientemente por el primer y tercer autor, expertos en el ámbito de las altas capacidades. Dichas traducciones fueron comparadas entre sí sin que se observasen discrepancias. Posteriormente, la traducción fue revisada por personal técnico de la editorial a la que pertenecen actualmente los derechos de las escalas (MHS). La propuesta de los autores fue aceptada sin cambios.

Una vez se tuvo la escala en castellano se alojó en un servicio en línea (Survey Monkey) para poder hacerla accesible a los respondientes. Los ítems de la escala se dispusieron aleatoriamente para evitar posibles sesgos debidos al orden original de las escalas cuando los ítems se presentan agrupados por dimensiones (Bishop, 2008; Tourón et al., 2018).

Junto con las instrucciones previas se incluyeron en el formulario de respuesta en línea, otras variables descriptivas como quién contesta la escala (padre/madre/tutor/otro); y respecto a la persona valorada: sexo, edad, curso, rendimiento, evaluación psicopedagógica y test de los que disponen de información sobre el hijo/a.

Para probar la estructura de la escala se ha llevado a cabo un análisis factorial exploratorio y otro confirmatorio que aporten evidencias sobre la validez de la misma.

Para tomar la decisión sobre el tipo de correlaciones a emplear, se probó la normalidad de la distribución de las respuestas a cada ítem mediante el estadístico W de Shapiro Wilk y la normalidad multivariada del conjunto de ítems con los estadísticos de simetría y curtosis de Mardia.

Por otra parte, una muestra de más de 1000 casos, como la empleada en este estudio, puede considerarse suficiente. Gaskin y Happell (2014) recomiendan que, con aproximadamente 6 ítems por factor, si se obtienen pesos factoriales alrededor de .5, un tamaño de aproximadamente 300 casos puede ser suficiente. Con una menor representación de ítems el tamaño debe ser más alto; los mismos autores recomiendan unos 1000 casos con modelos que incluyen cuatro ítems por factor.

Las correlaciones entre ítems es la información fundamental que utiliza el análisis factorial. La recomendación actual con ítems ordinales, como es el caso, es utilizar las correlaciones policóricas (Izquierdo et al., 2014; Lloret-Segura et al., 2014). Aunque con escalas Likert de más de 5 puntos y distribuciones simétricas podría utilizarse la correlación de Pearson (Viladrich et al., 2017). También el método de estimación de los parámetros debe ajustarse a esta condición.

En primer lugar, con un 40% de la muestra, se estudió la estructura de las correlaciones mediante el análisis factorial exploratorio (AFE), para obtener información sobre el número de factores óptimo. Se utilizó la técnica del análisis paralelo, que estima los autovalores que obtendrían los factores simulando resultados unidimensionales y los compara con los datos reales en un gráfico de sedimentación. Y, en segundo lugar, con el resto de la muestra, se realizó el estudio factorial confirmatorio (AFC). La adecuación de la matriz de correlaciones entre ítems se probó mediante el estadístico KMO y la prueba Barlett. En el primer caso, los valores de .8 o más se consideran buenos y, en el segundo, un resultado significativo (p<.05). Estos estadísticos determinan si el tamaño de las correlaciones entre ítems es suficiente para llevar a cabo el análisis factorial.

Se emplearon métodos de estimación de mínimos cuadrados ponderados. Y, en el caso de AFC, su versión robusta (WLSM), una de las opciones más recomendadas con variables ordinales (Li, 2014 y Xia, 2016).

En la fase de evaluación del modelo, se utilizaron los índices estandarizados: χ2 robusto normalizado (χ2 /gl), para valorar el ajuste global, donde valores entre 3 y 5 se consideran aceptables; RMSEA, para valorar la matriz residual, que es aceptable con valores inferiores a .08; y el TLI (Tucker-Lewis Index), de ajuste comparativo, que resultan aceptables a partir de .90. Siguiendo a Hu y Bentler (1999), como evidencia de validez es suficiente un ajuste aceptable en la combinación de estos índices. Además, en el AFC se añade el GFI (Goodness of Fit Index) y el error cuadrático medio (SRMR) para el ajuste global, así como el CFI (Comparative Fit Index) para el ajuste comparativo. También se calcularon en este caso los índices de modificación.

La dimensionalidad del constructo se refuerza con la interpretación de la relación entre factores latentes, también se proporcionan evidencias de la validez convergente a través del análisis de los pesos factoriales, utilizando el promedio de la varianza explicada (Average Variance Extracted, AVE), resultado de sumar las cargas factoriales estandarizadas (Pi) al cuadrado (equivalente a R2) y dividiendo por el total ítems de la dimensión como se indica en la fórmula (1).

Además, se estima la consistencia interna de las dimensiones mediante el cálculo de la Fiabilidad Compuesta (FC), a partir de las cargas factoriales y de la varianza de error (ei) con la fórmula (2),

donde la varianza de error de un ítem es el resultado de restar a 1 su carga factorial al cuadrado, según se indica en la fórmula (3).

Valores de .5 o más de AVE señalan que el factor consigue explicar el 50% o más de variabilidad de las respuestas a los ítems que lo componen. Combinando este estadístico con datos de fiabilidad compuesta superiores a .7 puede asumirse la validez convergente. También se incluye información sobre la capacidad explicativa del modelo a partir de la varianza total explicada por el conjunto de factores y, en este caso, valores superiores al 50% son suficientes. El modelo de medida original, como se ha señalado, incluye tres dimensiones o factores (Capacidad Cognitiva, Capacidad Creativa/Artística y Habilidades Socio-Emocionales). No obstante, se han probado modelos confirmatorios de 1 y 4 dimensiones y algunas variaciones que se incluyen en la Tabla III, sometiendo a prueba un total de ocho modelos. De estos, el modelo 4 correlaciona los errores de los ítems I5 con el I15 y el I16 con el I19; el modelo 5 además de correlacionar estos errores cambia de factor el ítem 17 (de la capacidad cognitiva a la creativa); el modelo 6 plantea una estructura de cuatro factores cambiando el ítem 17 de dimensión; el modelo 7 es similar al 5 pero con un factor de segundo orden y, finalmente el modelo 8 plantea cuatro factores de primer orden y dos de segundo orden.

TABLA III. Modelos confirmatorios estimados

Modelo |

Estructura |

Especificación |

1 |

3 Factores |

Modelo original |

2 |

4 Factores |

El factor Habilidades Socio-Emocionales se subdivide en dos dimensiones: Control emocional y Habilidades sociales |

3 |

1 Factor |

Una única dimensión |

4 |

3 Factores modificado A |

Modelo original permitiendo correlaciones entre errores de acuerdo con los índices de modificación |

5 |

3 Factores modificado B |

Modelo original con correlación entre errores y cambio del ítem 17 a la dimensión Creativa |

6 |

4 Factores modificado A |

Como el Modelo 2 y cambio del ítem 17 a la dimensión Creativa |

7 |

3 Factores modificado B |

Como el Modelo 5 + 1 Factor de 2º Orden |

8 |

4 Factores modificado A |

Como el Modelo 6 + 2 Factores de 2º Orden |

Los análisis de datos se han llevado a cabo con jamovi y diversos módulos desarrollados para el mismo (Jamovi Project, 2022; R Core Team, 2021; Friesen et al., 2019; Gallucci y Jentschke, 2021; Rosseel, 2019; Jorgensen et al, 2019 y Epskamp et al. 2019).

La media total de la escala (Likert de 6 puntos) es de 4.5 puntos (DT=1.22 puntos) y la mediana, en promedio, se sitúa en 4.7 puntos. Los ítems con menor valoración son el 5, 8 y 15 (“Maneja bien el estrés”; “Sigue trabajando incluso cuando no tiene éxito al principio” y “Controla su ira”, respectivamente), los tres con medianas de 3 puntos. En el lado opuesto, con medianas de 6 puntos, se sitúan el ítem 2, 4 y 13 (“Aprende cosas rápidamente”; “Tiene una gran memoria” y “Es rápido para entender las cosas”, respectivamente), que también son las que tienen menor variabilidad, con desviaciones típicas inferiores a 1.

Además, la correlación de cada ítem con el resto es positiva y con valores que varían entre .4 y .7, con un promedio de .54. Resultado que señala la homogeneidad del conjunto de ítems. En la tabla IV se incluyen los estadísticos descriptivos de los mismos.

TABLA IV. Estadísticos descriptivos de los ítems

Ítem |

Media |

Mediana |

D. T. |

Mín. |

Máx. |

R Poliserial |

I1 |

4.47 |

5 |

1.36 |

1 |

6 |

.491 |

I2 |

5.35 |

6 |

0.85 |

2 |

6 |

.561 |

I3 |

4.92 |

5 |

1.05 |

2 |

6 |

.546 |

I4 |

5.36 |

6 |

0.92 |

1 |

6 |

.480 |

I5 |

2.97 |

3 |

1.33 |

1 |

6 |

.439 |

I6 |

4.53 |

5 |

1.32 |

1 |

6 |

.554 |

I7 |

4.80 |

5 |

1.24 |

1 |

6 |

.590 |

I8 |

3.56 |

3 |

1.49 |

1 |

6 |

.553 |

I9 |

4.67 |

5 |

1.31 |

1 |

6 |

.655 |

I10 |

4.62 |

5 |

1.24 |

1 |

6 |

.690 |

I11 |

4.75 |

5 |

1.16 |

1 |

6 |

.659 |

I12 |

4.13 |

4 |

1.56 |

1 |

6 |

.562 |

I13 |

5.37 |

6 |

0.87 |

2 |

6 |

.536 |

I14 |

5.04 |

5 |

1.24 |

1 |

6 |

.431 |

I15 |

3.41 |

3 |

1.42 |

1 |

6 |

.447 |

I16 |

4.01 |

4 |

1.32 |

1 |

6 |

.568 |

I17 |

4.86 |

5 |

1.30 |

1 |

6 |

.489 |

I18 |

4.24 |

4 |

1.24 |

1 |

6 |

.633 |

I19 |

4.75 |

5 |

1.10 |

1 |

6 |

.419 |

I20 |

5.12 |

5 |

1.10 |

1 |

6 |

.615 |

Los resultados del estudio de la normalidad de las variables (ítems) con la prueba W de Shapiro-Wilk, han arrojado valores del estadístico con p<.001, en todos los casos, lo que nos lleva a rechazar la hipótesis nula. Por otra parte, los resultados de la normalidad multivariada de los supuestos de simetría que se distribuye como χ2 (5754.06, p< .001) y curtosis que se distribuye normalmente (42.47, p<.001), nos lleva a rechazar ambos supuestos.

Ante la falta de normalidad de la distribución de las respuestas, se optó por utilizar la matriz de correlaciones policóricas para llevar a cabo el estudio factorial, que se realizó en dos etapas.

En primer lugar, las medidas de adecuación muestral (KMO), con un valor promedio de .87 (valores por encima de .80 se consideran óptimos) y un resultado significativo de la prueba de esfericidad de Bartlett, son indicadores de que los valores de correlación entre ítems son adecuados para el estudio factorial.

En segundo lugar, los resultados de dimensionalidad del AFE indican una estructura de 5 dimensiones. No obstante, como puede observarse en el gráfico de sedimentación del análisis paralelo que se muestra en el gráfico I, el valor propio del quinto factor se sitúa muy próximo al valor del modelo unidimensional resultado de las simulaciones.

GRÁFICO I. Gráfico de sedimentación con resultados del análisis paralelo

Además, los pesos factoriales del quinto factor son de dos ítems (7: “Es creativo” y 17: “Da muchos detalles al explicar las cosas”), que también tienen una carga de mayor tamaño en otro factor. Por otra parte, los resultados de los pesos factoriales y los índices AVE y de fiabilidad compuesta calculados muestran un ajuste óptimo de 4 factores (ver Tabla V). La dimensión número cinco logra una AVE de 0,45 y una fiabilidad próxima a 0,4.

TABLA V. Índices AVE y Fiabilidad Compuesta del modelo de cuatro factores

Factores |

AVE |

FC |

F1 |

0,705 |

0,836 |

F2 |

0,703 |

0,895 |

F3 |

0,652 |

0,750 |

F4 |

0,667 |

0,719 |

Otra evidencia más a favor del modelo de 4 factores es su capacidad explicativa. Aproximadamente el 60% de la variabilidad de los datos es reproducida por el mismo, mientras que en el de 3 factores se explica el 54.6%. El quinto factor aporta menos del 3% de varianza explicada. En consecuencia, el modelo de 4 factores mejora la explicación de los ítems que se sitúan en el cuarto factor.

Los índices de ajuste de los modelos estimados en el estudio exploratorio se muestran en la tabla VI.

TABLA VI. Índices de ajuste del Análisis Factorial Exploratorio (AFE)

Índices |

5 factores |

4 factores |

3 factores |

χ2 |

964.885 |

1347.888 |

1894.254 |

gl |

100 |

116 |

133 |

p |

<.001 |

<.001 |

<.001 |

χ2/gl |

9.649 |

11.620 |

14.243 |

RMSEA |

.088 |

.098 |

.109 |

RMSEA (LI) |

.083 |

.105 |

.105 |

RMSEA (LS) |

.093 |

.114 |

.114 |

TLI |

.877 |

.849 |

.812 |

Aunque los resultados de estos índices no muestran valores aceptables, parecen mejorar a medida que aumenta el número de factores. Considerando las evidencias de la variabilidad explicada por los factores, los pesos factoriales de los ítems que los componen y los estadísticos AVE y fiabilidad compuesta, una estructura de 4 dimensiones sería la recomendada por el AFE.

Los ítems que componen los factores, como resultado del AFE, mantienen la estructura original, con la única variación del ítem 17 (“Da muchos detalles al explicar las cosas”), que cambia de la dimensión de Capacidad Cognitiva a la de Capacidad Creativa/Artística. En el modelo de tres factores es la única diferencia con el original.

El modelo de cuatro factores separa las Habilidades Socio-Emocionales en dos subdimensiones, para situar en una de ellas los ítems 5, 8 y 15 que, recordemos, son los ítems con puntuaciones más bajas de la escala y hacen referencia al control del estrés, la ira y la perseverancia en el trabajo. Hemos denominado a esta subdimensión, “Control Emocional”. En la otra subdimensión se agrupan los ítems 1, 6, 16 y 19, que, por su contenido, hemos denominado “Habilidades Sociales”. Estas dos dimensiones, en el diseño original de la escala se agrupan en el factor que los autores denominan Habilidades Socio-Emocionales (ver tabla VII).

TABLA VII. Estructura del modelo AFE de cuatro factores

Factores |

Ítems |

Capacidad Cognitiva |

I2, I3, I4, I13, I14 |

Capacidad Creativa/Artística |

I7, I9, I10, I11, I12, I17, I18, I20 |

Habilidades Sociales |

I1, I6, I16, I19 |

Control Emocional |

I5, I8, I15 |

Las correlaciones entre los factores, que se pueden ver en la tabla VIII, muestran una correlación media mayor entre las Capacidades Cognitivas y las Creativo/Artísticas, por una parte, y las Habilidades Sociales y Emocionales, por otro. Los valores no tienen un tamaño suficiente para considerarlas una única dimensión, aunque podrían ser explicadas por factores comunes de segundo orden. Hipótesis que se prueba en la etapa confirmatoria del modelo.

TABLA VIII. Correlaciones entre los factores a partir del AFE

|

Capacidad Cognitiva |

Capacidad Creativa/Artística |

Habilidades Sociales |

Control Emocional |

Capacidad Cognitiva |

1 |

|

|

|

Capacidad Creativa/Artística |

0,472 |

1 |

|

|

Habilidades Sociales |

0,392 |

0,385 |

1 |

|

Control Emocional |

0,268 |

0,136 |

0,552 |

1 |

Teniendo en cuenta los resultados del AFE, en la segunda etapa se probaron ocho modelos confirmatorios (ver tabla III), dos de ellos con factores de segundo orden. Los valores de ajuste de cada uno de los modelos probados se presentan en la tabla IX.

TABLA IX. Índices de ajuste de los modelos probados en el AFC

Índices |

M1 |

M2 |

M3 |

M4 |

M5 |

M6 |

M7 |

M8 |

χ2 |

2048 |

1740 |

6833 |

1726 |

1457 |

1596 |

1457 |

1601 |

gl |

167 |

164 |

170 |

165 |

167 |

164 |

165 |

165 |

p |

<.001 |

<.001 |

<.001 |

<.001 |

<.001 |

<.001 |

<.001 |

<.001 |

χ2/gl |

12.263 |

10.610 |

40.194 |

10.461 |

8.725 |

9.732 |

8.830 |

9.703 |

SRMR |

.086 |

.078 |

.154 |

.075 |

.071 |

.074 |

.075 |

.074 |

RMSEA |

.101 |

.093 |

.189 |

.089 |

.084 |

.089 |

.084 |

.089 |

RMSEA (LI) |

.097 |

.089 |

.202 |

.085 |

.080 |

.085 |

.080 |

.085 |

RMSEA (LS) |

.105 |

.097 |

.209 |

.093 |

.088 |

.093 |

.088 |

.090 |

CFI |

.968 |

.974 |

.867 |

.976 |

.978 |

.976 |

.978 |

.976 |

TLI |

.964 |

.969 |

.851 |

.972 |

.975 |

.972 |

.975 |

.972 |

GFI |

.978 |

.981 |

.910 |

.983 |

.984 |

.983 |

.984 |

.983 |

El M1 es el modelo de tres factores (original de la escala), donde el primer factor es la Capacidad Cognitiva, el segundo la Creativa/Artística y el tercero las Habilidades Socio-Emocionales. Los índices de ajuste comparado (CFI y TLI) logran unos valores buenos (>.95). También el índice de ajuste global (GFI) apunta en esta dirección. En cambio, los índices basados en los residuos (SRMR y RMSEA) superan ligeramente los valores aceptables, superando .08. Los índices de modificación sugirieron una mejora en el ajuste si se incluyen las correlaciones entre los residuos de los dos grupos de ítems del factor de Habilidades Socio-Emocionales (por un lado, el 5, 8 y 15, y, por otro, el 1, 6, 16 y 19). Este resultado es otra evidencia, como ya señaló el AFE, de la existencia de dos factores que explican las respuestas a los ítems de Habilidades Socio-Emocionales.

El M2 probó la agrupación de los ítems en cuatro factores, separando las habilidades socio-emocionales. Como se observa en la Tabla IX, los valores de los índices de ajuste mejoran. Los índices de los residuos disminuyen y también hay una reducción de los valores de χ2. Y aumentan los valores de los índices CFI, TLI y GFI.

A continuación, el M3 probó una estructura unidimensional del constructo y, como puede observarse, los índices de ajuste empeoran considerablemente.

El M4 y el M5, son modelos con ligeras variaciones respecto al M1. El primero incluye correlaciones entre los residuos de los ítems 5 y 15 y entre el 16 y 19 y, el segundo, además, cambia el ítem 17 del factor cognitivo al creativo. Al correlacionar los residuos se asume la existencia de otro factor que determina parte de la variabilidad de las respuestas a esos ítems y, como muestran los índices de ajuste, los resultados son similares al M2. Además, cambiar el ítem 17 de factor también produce una ligera mejora en los valores de ajuste.

El M6 es equivalente al M2, pero cambiando el ítem 17 de dimensión y, como ocurre con los modelos de tres factores (M5), el ajuste mejora ligeramente.

Finalmente, los modelos M7 y M8 incluyen factores de segundo orden considerando tres y cuatro factores, respectivamente. El M7 une los factores de Capacidad Cognitiva y Creativa/Artística y el M8 une esos dos y también los dos factores de Habilidades Socio-Emocionales. Y, como muestra la Tabla IX, los ajustes son prácticamente equivalentes.

La Validez Convergente (Average Variance Explained, AVE) y Fiabilidad Compuesta presentados en la Tabla X muestran mejor resultado en los modelos de cuatro factores (M2, M6 y M8) con un AVE de los factores Habilidades Socio-Emocionales (Factor 3 y Factor 4) con valores por encima de .5. En cambio, en los modelos de tres factores (M1, M4, M5 y M7), el de Habilidades Socio-Emocionales (Factor 3), explica solo el 40% de la variabilidad.

TABLA X. Evidencias de Validez Convergente y Fiabilidad Compuesta

Promedio de la varianza explicada (AVE) |

||||||||

|

M1 |

M2 |

M3 |

M4 |

M5 |

M6 |

M7 |

M8 |

Factor 1 |

.531 |

.531 |

.376 |

.531 |

.595 |

.595 |

.595 |

.595 |

Factor 2 |

.650 |

.649 |

|

.650 |

.598 |

.598 |

.598 |

.598 |

Factor 3 |

.403 |

.536 |

|

.403 |

.403 |

.536 |

.403 |

.536 |

Factor 4 |

|

.544 |

|

|

|

.545 |

|

.545 |

Total |

.528 |

.565 |

|

.528 |

.532 |

.568 |

.532 |

.568 |

Fiabilidad Compuesta |

||||||||

Factor 1 |

.868 |

.868 |

.918 |

.868 |

.878 |

.877 |

.878 |

.877 |

Factor 2 |

.927 |

.927 |

|

.927 |

.920 |

.920 |

.920 |

.920 |

Factor 3 |

.823 |

.821 |

|

.823 |

.823 |

.820 |

.815 |

.821 |

Factor 4 |

|

.781 |

|

|

|

.782 |

|

.782 |

Los valores de Fiabilidad Compuesta pueden considerarse aceptables en todos los casos (>.7). La mejor consistencia interna de los ítems se produce en el Factor 2 (Capacidad Creativa/Artística), que logra valores de fiabilidad superiores a .9.

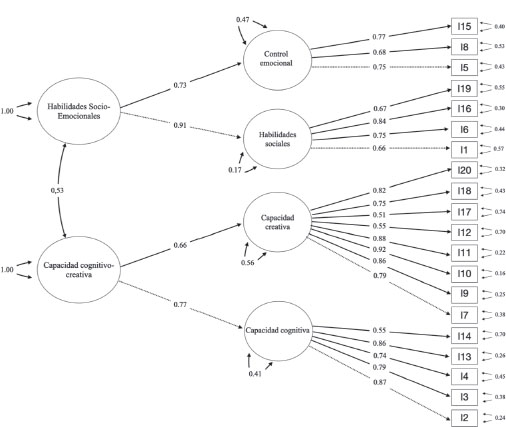

Los resultados del AFC señalan que los mejores modelos, considerando los valores de ajuste, son el M6 y el M8. Se optó por el M8, como modelo que mejor representa la estructura de relaciones que se producen entre los ítems del constructo, y permite utilizar las puntuaciones de los cuatro factores primarios y las dos dimensiones de segundo orden. En la tabla XI se incluyen los pesos factoriales logrados con este modelo y la proporción de varianza explicada (R2).

TABLA XI. Pesos factoriales (b), R2 y residuos de los ítems y factores de 2º orden del Modelo 8

Dimensiones |

Ítems |

b |

R2 |

Error |

Capacidad Cognitiva |

I2 |

.873 |

.762 |

.238 |

I3 |

.787 |

.619 |

.381 |

|

I4 |

.744 |

.554 |

.446 |

|

I13 |

.861 |

.741 |

.259 |

|

I14 |

.545 |

.297 |

.703 |

|

Capacidad Creativa/Artística |

I7 |

.786 |

.618 |

.382 |

I9 |

.865 |

.748 |

.252 |

|

I10 |

.919 |

.845 |

.155 |

|

I11 |

.883 |

.780 |

.220 |

|

I12 |

.546 |

.298 |

.702 |

|

I17 |

.505 |

.255 |

.745 |

|

I18 |

.752 |

.566 |

.434 |

|

I20 |

.822 |

.676 |

.324 |

|

Habilidades Sociales |

I1 |

.657 |

.432 |

.568 |

I6 |

.751 |

.564 |

.436 |

|

I16 |

.838 |

.702 |

.298 |

|

I19 |

.668 |

.446 |

.554 |

|

Control Emocional |

I5 |

.752 |

.566 |

.434 |

I8 |

.684 |

.468 |

.532 |

|

I15 |

.775 |

.601 |

.399 |

|

Fact. 2º orden |

Dimensiones |

b |

R2 |

Error |

Capacidad Cognitivo-Creativa |

Cognitiva |

.767 |

.588 |

.412 |

Creativa |

.662 |

.438 |

.562 |

|

Habilidades Socio-Emocionales |

Habilidades Sociales |

.913 |

.834 |

.166 |

Control Emocional |

.727 |

.529 |

.471 |

Los pesos factoriales de los ítems en el M8, para los factores de primer orden, son todos superiores a .5. Los más representativos son el ítem 2 (b=.873; R2=.762) en el factor de Capacidad Cognitiva, el ítem 10 en Capacidad Creativa/Artística (b=.919; R2=.845), el 16 en Habilidades Sociales (b=.838; R2=.702), y el 15 en Control Emocional (b=.775; R2=.601). De hecho, el 70% de los pesos factoriales (b) están por encima de .70 y el 30% de los mismos está entre .50 y .69.

Los factores de segundo orden explican también más del 50% de la variabilidad de las puntuaciones; concretamente, el 51.3% en el caso del factor Cognitivo-Creativo y del 68.1% en el de Habilidades Socio-Emocionales, lo que apoya la superioridad de este modelo respecto a los demás.

Para finalizar, el diagrama de los efectos entre factores e ítems del M8 se muestra en el gráfico II.

GRÁFICO II. Diagrama de variables observadas, latentes y efectos en el M8

Este es el primer estudio que se lleva a cabo sobre la estructura factorial de este instrumento en castellano. La única referencia para valorar los resultados obtenidos es la estructura original de la escala, organizada en tres dimensiones como se ha explicado.

Los diversos modelos probados nos han llevado a decantarnos, de acuerdo con la consideración global de los índices de ajuste y errores expuestos anteriormente, por una estructura de cuatro factores de primer orden, en la que la dimensión original de Habilidades Socio-Emocionales se divide en dos que, por el contenido de los ítems que las forman, hemos denominado: Habilidades Sociales y Control Emocional. Así, tendríamos una estructura de cuatro factores y no tres. Un ulterior análisis nos ha llevado a comprobar que el ajuste a los datos de la muestra mejora cuando se consideran, además, dos factores de segundo orden que agrupan a las capacidades cognitivas y creativo artísticas, por una parte, y el otro factor que agrupa las dimensiones sociales y de control emocional, que denominamos Habilidades Socio-Emocionales (Modelo 8).

Desde el punto de vista práctico, esta división de la dimensión de Habilidades Socio-Emocionales en dos componentes (Habilidades Sociales y Control Emocional) puede refinar la valoración del perfil de los candidatos al distinguir estas dos subdimensiones (factores), si bien el modelo de medida propuesto también permitiría integrar las dos dimensiones en caso de que se obtuviesen puntuaciones homogéneas en ambas y una no enmascarase la otra.

La necesidad y conveniencia de incluir a los padres como fuente de información, en el proceso de identificación y evaluación del alumnado con altas capacidades, que se pueda triangular con otras fuentes de datos, ha sido puesta de manifiesto por diversos autores (Nicpon y Pfeiffer, 2011; Pfeiffer, 2015b), y la carencia de instrumentos ha sido vista como una laguna en este campo. Por otra parte, los padres pueden aportar datos relevantes de otros contextos distintos al escolar, en particular del ámbito socio-emocional.

Esta dimensión viene a reflejar lo que Pfeiffer (2001, 2017b) ha denominado las “fortalezas del corazón”, que van más allá de las variables cognitivas. De hecho, otros autores han puesto de relieve la importancia de la determinación, el coraje, el trabajo duro, etc. como dimensiones esenciales en el desarrollo del talento (Duckworth, 2016; Pfeiffer, 2013; Subotnik et al., 2021; Olszewski-Kubilius et al., 2015, 2019).

Pfeiffer (2015b) señala que algunos autores argumentan que las valoraciones de los padres pueden estar sesgadas en sus percepciones de las habilidades y destrezas de sus hijos; sin embargo, la investigación señala que los sistemas de identificación que incluyen nominaciones de los padres mejoran y evitan que un buen número de alumnos con alta capacidad queden sin identificar (McBee et al., 2016). De hecho, existen estudios en los que se pone de manifiesto la validez de las valoraciones de los padres y su correlación con medidas de aptitud y rendimiento (Lee y Olszewski-Kubilius, 2006), y son numerosos los autores que recomiendan incluir estas valoraciones en un proceso de screening global que, junto con las procedentes de los profesores, permitan conocer aspectos de los estudiantes no cubiertos por los test de inteligencia y aptitudes (Pfeiffer, 2017a).

Por todo ello, es de la máxima importancia disponer de instrumentos adecuadamente validados, como el que aquí se presenta, para que puedan ser utilizados en la práctica educativa.

Ciertamente este trabajo es una validación preliminar que precisará de ulteriores estudios de confirmación, tanto con muestras españolas como de estudios comparativos con otras investigaciones similares que se lleven a cabo en contextos culturales diversos.

Dadas las cifras oficiales de alumnos identificados con alta capacidad intelectual en España, que son bien preocupantes, dado que se puede afirmar que casi un 98% de los alumnos está sin detectar (Tourón, 2020), el disponer de instrumentos adecuadamente validados es especialmente relevante.

Este trabajo se completará con la validación de las otras dos escalas para profesores que componen el GRS 2, y que se está llevando a cabo por los autores. Ello vendrá a suponer un avance significativo en el uso de herramientas útiles para la identificación del potencial de los alumnos.

Esta investigación ha recibido apoyo financiero del Vice-rectorado de Investigación de la Universidad Internacional de La Rioja.

Agradecemos el apoyo del profesor Steven Pfeiffer, que nos proporcionó los ítems de la versión en desarrollo de GRS-2 para esta investigación.

Abdulla, A. M., & Cramond, B. (2017). After Six Decades of Systematic Study of Creativity: What do Teachers Need to Know About What it is and How it is Measured? Roeper Review, 39(1), 9–23.

Beghetto, R. A., & Plucker, J. A. (2016). Revisiting the Relationship Among Schooling, Learning, and Creativity. In J. C. Kaufman & J. Baer (Eds.), Creativity and Reason in Cognitive Development (pp. 72–91). Cambridge University Press. https://doi.org/10.1017/CBO9781139941969.005

Bishop, G. F. (2008). Item Order Randomization. In P. J. Lavrakas, Encyclopedia of Survey Research Methods (p. 397). SAGE.

Cropley, A. J. (2000). Defining and Measuring Creativity: Are Creativity Tests Worth Using? Roeper Review, 23(2), 72–79.

Cropley, A. J., & Urban, K. K. (2000). Programs and Strategies for Nurturing Creativity. In K. A. Heller, F. J. Mönks, R. Subotnik, Robert Sternberg (Eds.), International Handbook of Giftedness and Talent (2nd ed., pp. 485–498). Pergamon Press.

Csikszentmihalyi, M., & Wolfe, R. (2000). New Conceptions and Research Approaches to Creativity: Implications of a Systems Perspective for Creativity in Education. In K. A. Heller, F. J. Mönks, R. Subotnik, Robert Sternberg (Eds.), International Handbook of Giftedness and Talent (2nd ed., pp. 81–93). Pergamon Press.

Dai, D. Y. (2018). A History of Giftedness: Paradigms and Paradoxes. In S. I. Pfeiffer (Ed.), Handbook of Giftedness in Children (2nd. ed., pp. 1–14). Springer. https://doi.org/10.1007/978-3-319-77004-8_1

Duckworth, A. (2016). Grit: The Power of Passion and Perseverance. Scribner/Simon & Schuster.

Durlak, J. A., Weissberg, R. P., Dymnicki, A. B., Taylor, R. D., & Schellinger, K. B. (2011). The Impact of Enhancing Students' Social and Emotional Learning: A Meta-Analysis of School-Based Universal Interventions. Child Development, 82(1), 405–432.

Epskamp S., Stuber S., Nak J., Veenman M., & Jorgensen T. D. (2019). semPlot: Path Diagrams and Visual Analysis of Various SEM Packages' Output. [R Package]. Retrieved from https://CRAN.R-project.org/package=semPlot

Friesen, L., Kroc, E., & Zumbo, B. D. (2019). Psychometrics & Post-Data Analysis: Non-Parametric Item Response Theory. [jamovi module]. Retrieved from https://github.com/lucasjfriesen/jamoviPsychoPDA

Gagné, F. (1993). Constructs and Models Pertaining to Exceptional Human Abilities. In K. A. Heller, F. J. Mönks, & A. H. Passow (Eds.), International Handbook of Research and Development of Giftedness and Talent (pp. 69–87). Pergamon Press.

Gagné, F. (2015). From Genes to Talent: The DMGT/CMTD Perspective. Revista de Educación, 368, 66–91. https://doi.org/10.4438/1988-592X-RE-2015-368-289

Gagné, F. (2018). Academic Talent Development: Theory and Best Practices. In S. I. Pfeiffer, E. Shaunessy-Dedrick, & M. Foley-Nicpon (Eds.), APA Handbook of Giftedness and Talent (pp. 163–183). American Psychological Association. https://doi.org/10.1037/0000038-011

Gagné, F. (2021). The Differentiating Model of Giftedness and Talent. In T. L. Cross & J. R. Cross (Eds.), Handbook for Counselors Serving Students with Gifts and Talents: Development, Relationships, School Issues, and Counseling Needs/Interventions (2nd ed., pp. 9–28). Routledge. https://doi.org/10.4324/9781003235415-3

Gallucci, M., & Jentschke, S. (2021). SEMLj: jamovi SEM Analysis. [jamovi module]. https://semlj.github.io/.

Galton, F. (1869). Hereditary Genius: An Inquiry Into its Laws and Consequences. Macmillan and Co.

Gaskin, C. J., & Happell, B. (2014). On Exploratory Factor Analysis: A Review of Recent Evidence and Assessment of Current Practice, and Recommendations for Future Use. International Journal of Nursing Studies, 51(3), 511–521.

Getzels, J. W., & Jackson, P. W. (1962). Creativity and Intelligence: Explorations with Gifted Students. Wiley.

Hargreaves, A. (1996). Revisiting Voice. Educational Researcher, 25(1), 12–19.

Haroutounian, J. (1995). Talent Identification and Development in the Arts: An Artistic/Educational Dialogue. Roeper Review, 18(2), 112–117.

Haroutounian, J. (2002). Kindling the Spark: Recognizing and Developing Musical Talent. Oxford University Press on Demand.

Hu, L. T., & Bentler, P. M. (1999). Cutoff Criteria for Fit Indexes in Covariance Structure Analysis: Conventional Criteria versus New Alternatives. Structural Equation Modeling, 6(1), 1–55. https://doi.org/10.1080/10705519909540118

Isaksen, S. G., Puccio, G. J., & Treffinger, D. J. (1993). An Ecological Approach to Creativity Research: Profiling for Creative Problem Solving. The Journal of Creative Behavior, 27(3), 149–170. https://doi.org/10.1002/j.2162-6057.1993.tb00704.x

Izquierdo, I., Olea, J., & Abad, F. J. (2014). El análisis factorial exploratorio en estudios de validación: Usos y recomendaciones [Exploratory Factor Analysis in Validation Studies: Uses and Recommendations]. Psicothema, 26(3), 395–400.

Jamovi Project, The (2022). jamovi. (Version 2.3) [Computer Software]. Retrieved from https://www.jamovi.org

Jarosewich, T., Pfeiffer, S. I., & Morris, J. (2002). Identifying Gifted Students Using Teacher Rating Scales: A Review of Existing Instruments. Journal of Psychoeducational Assessment, 20(4), 322–336.

Jorgensen, T. D., Pornprasertmanit, S., Schoemann, A. M., Rosseel, Y., Miller, P., Quick, C., Garnier-Villarreal, M., Selig, J., Boulton, A., Preacher, K., Coffman, D., Rhemtulla, M., Robitzsch, A., Enders, C., Arslan, R., Clinton, B., Panko, P., Merkle, E., Chesnut, S., Byrnes, J., Rights, J. D., Longo, Y., Mansolf, M., Ben-Shachar, M. S., & Rönkkö, M. (2019). semTools: Useful Tools for Structural Equation Modeling. [R Package]. Retrieved from https://CRAN.R-project.org/package=semTools

Lee, S. Y. & Olszewski-Kubilius, P. (2006). Comparison Between Talent Search Students Qualifying via Scores on Standardized Tests and via Parent Nomination. Roeper Review, 28, 157–166.

Li, Ch.-H. (2014). The Performance of MLR, USLMV, AND WLSMV Estimation in Structural Regression Models with Ordinal Variables. Doctoral Dissertation. Michigan State University.

Lloret-Segura, S., Ferreres-Traver, A., Hernández-Baeza, A., & Tomás-Marco, I. (2014). El análisis factorial exploratorio de los ítems: una guía práctica, revisada y actualizada. [Exploratory Item Factor Analysis: a practical guide revised and updated], Anales de Psicología/Annals of Psychology, 30(3), 1151–1169.

McBee, M. T., Peters, S. J., & Miller, E. M. (2016). The Impact of the Nomination Stage on Gifted Program Identification: A Comprehensive Psychometric Analysis. Gifted Child Quarterly, 60(4), 258–278. https://doi.org/10.1177/0016986216656256

Neihart, M., Pfeiffer, S., & Cross, T. (2016). The Social and Emotional Development of Gifted Children: What Do We Know? (2nd ed.). Prufrock.

Nicpon, M. F., & Pfeiffer, S. I. (2011). High-Ability Students: New Ways to Conceptualize Giftedness and Provide Psychological Services in the Schools. Journal of Applied School Psychology, 27(4), 293–305.

Olszewski-Kubilius, P., Subotnik, R., & Worrell, F. C. (2015). Re- pensando las altas capacidades: una aproximación evolutiva. [Re-Thinking Giftedness: A Developmental Approach]. Revista de Educación, 368, 40–65. https://doi.org/10.4438/1988-592X-RE-2015-368-297

Olszewski-Kubilius, P., Worrell, F. C., Subotnik, R. F., & Foley-Nicpon, M. (2019). Reflections on Talent Development in Academics. In R. F. Subotnik, P. Olszewski-Kubilius, & F. C. Worrell (Eds.), The Psychology of High Performance: Developing Human Potential into Domain-Specific Talent (pp. 225–236). American Psychological Association. https://doi.org/10.1037/0000120-011

Pfeiffer, S. I. (2001). Professional Psychology and the Gifted: Emerging Practice Opportunities. Professional Psychology: Research and Practice, 32(2), 175.

Pfeiffer, S. I. (2013). Lessons Learned from Working with High-Ability Students. Gifted Education International, 29(1), 86–97.

Pfeiffer, S. I. (2015a). Tripartite Model of Giftedness and Best Practices in Gifted Assessment. Revista de Educación, 368, 66–95. DOI: 10.4438/1988-592X-RE-2015-368-293

Pfeiffer, S. I. (2015b). Essentials of Gifted Assessment. John Wiley & Sons.

Pfeiffer, S. I. (2017a). Identificación y evaluación del alumnado con altas capacidades: Una guía práctica. [Identification and Evaluation of High Ability Students: A Practical Guide]. UNIR Editorial.

Pfeiffer, S. I. (2017b). Success in the Classroom and in Life: Focusing on Strengths of the Head and Strengths of the Heart. Gifted Education International, 33(2), 95–101.

Pfeiffer, S. I. (2018). Giftedness and Talent Development in Children and Youth. In P. Ward, J. M. Schraagen, J. Gore, & E. M. Roth (Eds.), The Oxford Handbook of Expertise (pp. 103–127). https://doi.org/10.1093/oxfordhb/9780198795872.013.5

Pfeiffer, S. I., & Blei, S. (2008). Gifted Identification Beyond the IQ test: Rating Scales and Other Assessment procedures. In S. I. Pfeiffer (Ed.), Handbook of Giftedness in Children: Psychoeducational Theory, Research, and Best Practices (pp. 177–198). Springer Science. https://doi.org/10.1007/978-0-387-74401-8_10

Pfeiffer, S. I., & Jarosewich, T. (2003). GRS: Gifted Rating Scales. Psychological Corporation.

Plucker, J.A., Guo, J., & Makel, M. C. (2018). Creativity. In S. I. Pfeiffer (Ed.), Handbook of Giftedness in Children (pp. 81–99). Springer. https://doi.org/10.1007/978-3-319-77004-8_6

Plucker, J. A., & Runco, M. A. (1998). The Death of Creativity Measurement Has Been Greatly Exaggerated: Current Issues, Recent Advances, and Future Directions in Creativity Assessment. Roeper Review, 21(1), 36–39.

Porath, M. (1993). Gifted Young Artists: Developmental and Individual Differences. Roeper Review, 16(1), 29–33.

Presbury, J. H., Benson, A. J., & Torrance, E. P. (1997). Creativity. In G. G. Bear, K. M. Minke, & A. Thomas (Eds.), Children’s needs II: Development, Problems and Alternatives (pp. 449–456). National Association of School Psychologists.

R Core Team (2021). R: A Language and environment for statistical computing. (Version 4.1) [Computer software]. https://cran.r-project.org. (R packages retrieved from MRAN snapshot 2022-01-01).

Renzulli, J. S. (2016). The Three-Ring Conception of Giftedness. In J. Renzulli, S. M. Reis, Reflections on Gifted Education: Critical Works by Joseph S. Renzulli and Colleagues (pp. 55–90). Prufrock. https://doi.org/10.4324/9781003237693-5

Renzulli, J. S. (2021). Intelligences Outside the Normal Curve: Co-Cognitive Factors That Contribute to the Creation of Social Capital and Leadership Skills in Young People. In J. Renzulli, S. M. Reis, Reflections on Gifted Education: Critical Works by Joseph S. Renzulli and Colleagues (pp. 129–150). https://doi.org/10.4324/9781003237693-5

Renzulli, J. S., & Delcourt, M. A. B. (2017). Gifted Behaviors versus Gifted Individuals. In C. M. Callahan, H. L. Hertberg-Davis, Fundamentals of Gifted Education (pp. 42–54). Routledge. https://doi.org/10.4324/9781315639987-5

Renzulli, J. S., & Gaesser, A. H. (2015). A Multi Criteria System for the Identification of High Achieving and Creative/Productive Giftedness. Revista de Educación, 368, 96–131. https://doi.org/10.4438/1988-592X-RE-2015-368-290

Renzulli, J. S., Hartment, R., & Callahan, C. (2001). Escalas de Renzulli (SCRBSS): Escalas para la valoración de las características de comportamiento de los estudiantes superiores [Scales for Rating the Behavioral Characteristics of Superior Students]. Amarú Ediciones.

Renzulli, J. S., & Reis, S. M. (2018). The Three-Ring Conception of Giftedness: A Developmental Approach for Promoting Creative Productivity in Young People. In S. I. Pfeiffer, E. Shaunessy-Dedrick, & M. Foley-Nicpon (Eds.), APA Handbook of Giftedness and Talent (pp. 185–199). American Psychological Association. https://doi.org/10.1037/0000038-012

Renzulli, J. S., & Reis, S. M. (2021). The Three Ring Conception of Giftedness: A Change in Direction from Being Gifted to the Development of Gifted Behaviors. In R. J. Sternberg & Ambrose, D. (Eds.), Conceptions of Giftedness and Talent (pp. 335–355). Palgrave Macmillan. https://doi.org/10.1007/978-3-030-56869-6_19

Rogers, K. B. (2002). Re-forming Gifted Education: Matching the Program to the Child. Great Potential Press, Inc.

Rosseel, Y. (2019). lavaan: An R Package for Structural Equation Modeling. Journal of Statistical Software, 48(2), 1–36. DOI: https://doi.org/10.18637/jss.v048.i02

Runco, M. A. (2014). “Big C, Little c” Creativity as a False Dichotomy: Reality is not Categorical. Creativity Research Journal, 26(1), 131–132.

Shaughnessy, M. F. (2022). An Interview with Steven I. Pfeiffer: Gifted Rating Scales-(GRS [TM] 2). North American Journal of Psychology, 24(1), 1–1.

Sternberg, R. J. (1985). Implicit Theories of Intelligence, Creativity, and Wisdom. Journal of Personality and Social Psychology, 49(3), 607.

Subotnik, R. F., Olszewski-Kubilius, P., & Worrell, F. C. (2021). Unlocking Creative Productivity: A Talent Development Approach. Journal of Modern Foreign Psychology, 10(4). https://doi.org/10.17759/jmfp.2021100402

Terman, L. M. (1925). Mental and Physical Traits of a Thousand Gifted Children. Genetic Studies of Genius. Volume 1. Stanford University Press.

Tourón, J. (2012). Los cuestionarios de Rogers para la nominación de los más capaces. Padres y Profesores [Rogers Questionnaires for Parent and Teacher Gifted Nominations]. https://www.javiertouron.es/los-cuestionarios-de-rogers-para-la

Tourón, J. (2020). Las altas capacidades en el sistema educativo español: reflexiones sobre el concepto y la identificación [Gifted Students in the Spanish Education System: Reflections on Conceptualization and Identification Issues]. Revista de Investigación Educativa, 38(1), 15–32.

Tourón, J., Martín, D., Navarro Asensio, E., Pradas, S. e Íñigo, V. (2018). Validación de constructo de un instrumento para medir la competencia digital docente de los profesores (CDD) [Construct validation of a questionnaire to measure teachers’ digital competence (TDC)]. Revista Española de Pedagogía, 76(269), 2554. https://doi.org/10.22550/REP761201802

Viladrich, C., Angulo-Brunet, A., & Doval, E. (2017). A Journey Around Alpha and Omega to Estimate Internal Consistency Reliability. Annals of Psychology, 33(3), 755–782. https://doi.org/10.6018/analesps.33.3.268401

Worrell, F. C., Subotnik, R. F., Olszewski-Kubilius, P., & Dixson, D. D. (2019). Gifted Students. Annual Review of Psychology, 70, 551–576.

Xia, Y. (2016). Investigating the Chi-square Based Model-fit Indexes for WLSMV and ULSMV Estimators (Dissertation). Florida State University. http://purl.flvc.org/fsu/fd/FSU_2016SU_Xia_fsu_0071E_13379

Información de contacto: Marta Tourón. Universidad Internacional de La Rioja – UNIR, Avd. de La Paz, 137. 26006 Logroño La Rioja, España. E-mail: marta.tporto@unir.net