Posicionamiento del alumnado de Educación Primaria y Secundaria ante la personalización del aprendizaje: construcción y validación de una escala1

Primary and secondary students’ views of learning personalization: construction and validation of a scale

DOI: 10.4438/1988-592X-RE-2022-395-514

César Coll

Jaime Fauré

Universidad de Barcelona

Rubén Arriazu

Universidad de Extremadura

Resumen

Este trabajo presenta el proceso de construcción y validación psicométrica de una escala para explorar los posicionamientos del alumnado de educación primaria y secundaria ante las estrategias de personalización del aprendizaje escolar (EPAE-A). El instrumento forma parte de una investigación más amplia dirigida al análisis de prácticas de innovación educativa basadas en la personalización. El punto de partida del proceso de construcción fue una tipología de actuaciones y estrategias pedagógicas que, de acuerdo con la literatura científica, promueven el logro de aprendizajes escolares con sentido y valor personal para el alumnado. Para construir la EPAE-A se realizaron dos pruebas piloto preliminares, con 507 y 1411 estudiantes respectivamente, que permitieron reducir el número inicial de ítems a 34. Los ítems se agruparon en dos sub-escalas, una de frecuencia (10 ítems) y otra de acuerdo (24 ítems). Un análisis factorial permitió identificar una estructura de cuatro factores en la sub-escala de acuerdo que se relacionan con las siguientes dimensiones de la personalización del aprendizaje: 1) decisión y control del aprendiz sobre el proceso de aprendizaje; 2) base experiencial y vivencial; 3) conexión entre experiencias de aprendizaje; y 4) reflexión sobre uno mismo como aprendiz y sobre el propio proceso de aprendizaje. En la sub-escala de frecuencia, por su parte, se identificó una estructura unidimensional que agrupa ítems sobre acciones específicas de profesores y alumnos vinculadas a las estrategias de personalización del aprendizaje. Con el fin de obtener evidencias de la validez y fiabilidad de la escala construida se llevó a cabo una aplicación de la versión definitiva a una muestra de 4909 estudiantes con edades comprendidas entre los 10 y los 18 años de 12 centros educativos españoles situados en Catalunya, Extremadura y Madrid. Los resultados obtenidos muestran que la escala cuenta con evidencias sólidas de validez de estructura interna y fiabilidad.

Palabras clave: educación primaria; educación secundaria; escala de percepción del alumnado; estrategias de personalización; personalización del aprendizaje; validación de una escala.

Abstract

In this work we present the formulation and psychometric validation of a scale for the exploration of primary and secondary students’ views of school learning personalisation strategies (EPAE-A from the Spanish Escala de Personalisación del Aprendizaje Escolar – Alumnado, School Learning Personalisation Scale – Students). The instrument was developed as part of a broader research project which analyses educational innovation involving personalisation of learning. The starting point for the formulation of the scale was to establish a typology of teaching practices and strategies which, according to a review of the relevant literature, promote school learning that has personal meaning and significance for the students. In order to validate the EPAE-A, two preliminary pilot studies were conducted, the first involving 507 students and the second 1,411 students. The process enabled us to reduce the initial set of items to a total of 34. These were grouped into two sub-scales: one of frequency (10 items) and the other of agreement (24 items). Factor analysis revealed a four-factor structure of the agreement sub-scale corresponding to four dimensions of learning personalisation: 1) learner’s control and decision-making regarding the learning process; 2) experiential and emotional basis; 3) connections between learning experiences; and 4) reflection upon oneself as a learner and upon the learning process itself. A unidimensional structure was identified for the frequency sub-scale, grouping items according to specific teacher and student actions related to learning personalisation strategies. In order to obtain evidence of the validity and reliability of the scale, the final version was applied to a sample of 4,909 students aged between 10 and 18 years from educational institutions located in Catalonia, Extremadura and Madrid, Spain. The results provide strong evidence of the internal structural validity and reliability of the scale.

Keywords: primary education, secondary education, student views scale, personalisation strategies, learning personalisation, validation of a scale.

Introducción

En este trabajo se presenta el proceso de construcción, desarrollo y valoración de las propiedades psicométricas de una escala orientada a explorar los posicionamientos del alumnado de educación primaria y secundaria ante un conjunto de actuaciones y estrategias de personalización del aprendizaje escolar (EPAE-A en adelante, por Escala de Personalización del Aprendizaje Escolar – Alumnado). En el proceso han participado estudiantes de doce centros educativos españoles situados en Catalunya, Extremadura y Madrid. Conocer su punto de vista sobre las actuaciones y estrategias de personalización del aprendizaje escolar es esencial para que éstas puedan implementarse con éxito.

Las propuestas orientadas a promover la personalización del aprendizaje escolar se han multiplicado en el transcurso de las dos últimas décadas. La iniciativa ha sido de las autoridades educativas nacionales o estatales (ACARA, 2013; DfES, 2006; NETP, 2010), de fundaciones, entidades y corporaciones privadas (e.g., Christensen Institute, Digital Promise, Education Elements, KnowledgeWorks, LEAP Innovations, Students at the Center) y de instancias supranacionales (OECD, 2006, 2017; UNESCO-IBE, 2017). En la base de estas iniciativas encontramos el argumento de que, para hacer frente a los desafíos que plantea el nuevo escenario económico, laboral, social, tecnológico y cultural de la Sociedad de la Información, es necesario introducir cambios en profundidad en la organización y el funcionamiento de los sistemas educativos (Marope, 2017a). Entre estos cambios ocupa un lugar destacado la propuesta de que el aprendizaje esté centrado en el alumno y la personalización del aprendizaje.

Ahora bien, existen maneras sensiblemente diferentes de entender qué significa y cómo se concreta la personalización del aprendizaje. Aunque revisar en profundidad las diferentes maneras de caracterizar, definir e implementar el aprendizaje personalizado está fuera del alcance de este trabajo, conviene que señalemos y comentemos brevemente las que hemos utilizado como referencia para acotar y situar la perspectiva en la que se ubica la EPAE-A.

El aprendizaje personalizado se ha identificado en ocasiones con la educación basada en competencias (Hammonds & Moyer, 2018; Levine & Patrick, 2019). Esta identificación es, a nuestro entender, inadecuada, ya que restringe las actuaciones y estrategias de personalización a uno de sus componentes, dejando de lado otros que son igualmente esenciales y que no forman parte, en sentido estricto, de la educación basada en competencias como, por ejemplo, la identificación y la toma en consideración de los intereses y objetivos del alumnado, o la puesta en relación y el establecimiento de conexiones entre experiencias de aprendizaje escolares y no escolares (ver el apartado siguiente). En otras palabras, las actuaciones y estrategias de personalización del aprendizaje son respetuosas, por lo general, con los principios de la educación basada en competencias, pero en ningún caso se limitan a ellos (Jonnaert, 2019; Marope, 2017b; Perrenoud, 2000).

Igualmente frecuente es la identificación del aprendizaje personalizado con el uso en educación de las tecnologías digitales de la información y la comunicación (TIC, en adelante) en sus múltiples variantes: en línea, mixto o como apoyo a los procesos de enseñanza y aprendizaje presenciales (Grant & Basye, 2014; Johnson et al., 2014). Especial atención merece, a nuestro entender, la identificación que se produce en ocasiones entre el aprendizaje personalizado y el uso de las analíticas de aprendizaje para ajustar la acción educativa al proceso de aprendizaje del alumnado a partir de los resultados del análisis de grandes cantidades de datos sobre su actividad en las plataformas tecnológicas (Chrysafiadi et al., 2020; Kabassi & Alepis, 2020).

También en este caso la identificación nos parece inadecuada. Las TIC ofrecen al profesorado y al alumnado posibilidades inéditas para avanzar en la dirección de un aprendizaje personalizado. La implementación de algunas actuaciones y estrategias de personalización es muy difícil, por no decir prácticamente imposible, sin contar con una infraestructura y un equipamiento de TIC adecuados. Prácticamente todas ellas, además, pueden ser más fácilmente implementadas e incrementar su eficacia mediante un uso adecuado de las TIC. Sin embargo, el uso de las TIC por sí solo no es suficiente para personalizar el aprendizaje, ni siquiera en la versión de las Learning Analytics. De hecho, son numerosas las propuestas, iniciativas y experiencias de personalización del aprendizaje que hacen un uso muy limitado de las TIC, o que incluso no recurren a ellas, sin que ello suponga un obstáculo insalvable.

En un intento por captar la especificidad de las propuestas de personalización del aprendizaje, Bray & McClaskey (2013, 2015) han propuesto distinguirlas de las propuestas de diferenciación e individualización atendiendo a los roles que desempeñan en ellas el alumnado y el profesorado. Así, aunque las tres comparten la opción de un aprendizaje centrado en el alumno, en la diferenciación y la individualización el proceso de aprendizaje está pilotado y dirigido por el profesorado, que ajusta la acción educativa a su valoración de las necesidades del alumnado y selecciona los recursos que considera más apropiados en cada momento para satisfacerlas. Solo en las propuestas de personalización se reconoce y respeta la capacidad de los alumnos para conducir su propio aprendizaje, promoviendo la expresión de sus opciones e intereses e incorporándolos progresivamente como auténticos co-diseñadores y co-decisores en el diseño y desarrollo de las actividades de aprendizaje.

Aprendizaje con valor personal y personalización del aprendizaje

Conviene tener presente tanto el fin que se persigue con la personalización del aprendizaje como los medios utilizados para alcanzarlo. El fin es que los aprendizajes escolares sean relevantes, tengan un sentido y un valor personal para el alumnado. Los medios son un conjunto de actuaciones y estrategias que ponen en marcha los profesores cuando planifican e implementan junto con sus alumnos unas actividades con el propósito de alcanzar el fin mencionado. Ambos aspectos deben ser tenidos en cuenta y reflejarse en las dimensiones e ítems de la escala y constituyen, por lo tanto, el punto de referencia para su construcción.

En lo que concierne al fin de la personalización –que los aprendizajes sean relevantes y tengan sentido y valor personal para el alumnado–, los resultados de la investigación desarrollada en el marco de las Ciencias del Aprendizaje (Learning Sciences) proporcionan algunas claves sobre las características de las situaciones que lo promueven. La lectura de las revisiones y síntesis de estos resultados (e.g., American Psychological Association, 2015; National Academies of Sciences, Engineering, and Medicine, 2018; OECD, 2017; Sawyer, 2014) pone de manifiesto un elevado grado de acuerdo en torno a algunos principios presentes en las situaciones y actividades que suelen dar lugar a aprendizajes relevantes, profundos y con sentido y valor personal para los aprendices. Así, los resultados indican que la probabilidad de que esto suceda es mayor cuando: (i) lo que se aprende y cómo se aprende responde a los intereses, objetivos y opciones de los aprendices; (ii) se respeta la capacidad de decisión y control de los aprendices sobre su proceso de aprendizaje; (iii) los contenidos y las actividades de aprendizaje se vinculan con las actividades habituales de los aprendices y la cultura de la que forman parte; (iv) las situaciones de aprendizaje tienen un componente vivencial y emocional; (v) las tareas y actividades responden al principio de “aprender haciendo” y están orientadas a la obtención de un resultado o la elaboración de un producto; (vi) se establece una conexión entre experiencias de aprendizaje que han tenido lugar en momentos y contextos distintos; y (vii) se favorece la reflexión de los aprendices sobre su propio proceso de aprendizaje y sobre su manera de afrontar y abordar las situaciones y actividades de aprendizaje. Ninguno de estos principios es capaz de asegurar, por sí solo, que las situaciones o actividades de aprendizaje darán lugar a aprendizajes con sentido y valor personal para los aprendices. Sin embargo, su toma en consideración simultánea en el diseño de situaciones y actividades de aprendizaje incrementa sustancialmente la probabilidad de que ello suceda.

En general, los trabajos relacionados con la personalización del aprendizaje suelen reflejar estos principios en forma de actuaciones y estrategias para el diseño y desarrollo de actividades escolares de enseñanza y aprendizaje. Algunos principios son retomados en la mayoría de las propuestas dando lugar, de este modo, a una visión relativamente compartida de la personalización del aprendizaje. Es el caso de la toma en consideración de los intereses, objetivos y opciones de los aprendices, que suele adoptar la forma de estrategias dirigidas a incorporar tanto las decisiones como la voz (“the choice and the voice”) del alumnado al diseño y desarrollo de las actividades de aprendizaje (e.g., Bray & McClaskey, 2015; Schmid & Petko, 2019; Underwood et al., 2009; Waldrip et al., 2014, 2016). O también, del reconocimiento y la aceptación de la capacidad del alumnado para tomar decisiones sobre alguno, algunos o todos los componentes de las actividades de aprendizaje, presentado a menudo en términos del control del alumnado (“pupil’s control”) sobre su proceso de aprendizaje (e.g., DeMink-Carthew & Netcoh, 2019; FitzGerald et al., 2018; Netcoh, 2017; Prain et al., 2013).

Otros principios, en cambio, no tienen el mismo grado de presencia y aparecen solo en algunos trabajos. Es lo que sucede con el establecimiento de conexiones entre experiencias de aprendizaje con independencia del lugar y el momento en que han tenido lugar, que suele tomar la forma de estrategias dirigidas a identificar las experiencias de aprendizaje del alumnado en los diferentes contextos de actividad en los que participan y establecer relaciones entre ellas (Holmes et al., 2018; Jones & McLean, 2018). O también, con la reflexión de los aprendices sobre su propio proceso de aprendizaje y su manera de abordar y afrontar las actividades de aprendizaje (Olofson & Downes, 2018; Watson & Watson, 2017).

Por último, los principios relativos al “aprender haciendo” y a los componentes vivenciales y emocionales suelen tener un reflejo indirecto en las propuestas de personalización a través de las llamadas metodologías de indagación –aprendizaje basado en proyectos, en problemas, en casos, en el diseño, en fenómenos, etc.– o las propuestas de aprendizaje cooperativo con las que se vinculan a menudo desde un punto de vista didáctico (Jones et al., 2013; Lee, 2014; Schmid & Petko, 2019).

Esta heterogeneidad aparece también en los trabajos, por lo demás más bien escasos, de validación y utilización de cuestionarios para identificar las percepciones de los estudiantes ante la personalización del aprendizaje. Así, Underwood y Banyard (2008) utilizan sendos cuestionarios para identificar y comparar las percepciones de los directivos, el profesorado y el alumnado ante la personalización del aprendizaje en Inglaterra. El cuestionario del alumnado está formado por 11 sub-escalas dirigidas a explorar sus percepciones sobre una amplia variedad de aspectos que van desde las actitudes ante los ordenadores y su uso hasta determinadas actuaciones del profesorado.

Igualmente amplio y diverso es el abanico de aspectos que cubre el Personalised Learning Questionnaire (PLQ), integrado por 19 sub-escalas y desarrollado por Waldrip et al. (2014). La idea que preside la construcción del PLQ es que el aprendizaje personalizado tiene lugar cuando se produce “a productive interplay between (a) teacher expertise in identifying and addressing students´ongoing individual curricular needs and (b) student capacity to develop, over an extended time-frame, increasing independence as learners”2 (op. cit., p. 358).

La perspectiva adoptada en la construcción y validación de la EPAE-A es significativamente más acotada que la de los dos cuestionarios anteriores. En primer lugar, hemos limitado su alcance a las percepciones que tienen los estudiantes de las actuaciones y estrategias del profesorado explícitamente orientadas a promover y reforzar el sentido y valor personal de los aprendizajes escolares. En segundo lugar, las actuaciones y estrategias seleccionadas están presentes, con mayor o menor frecuencia según los casos, en las propuestas y enfoques de personalización del aprendizaje identificados en la revisión realizada de los trabajos publicados sobre el tema en los últimos quince años. En tercer lugar, todas ellas pueden ponerse en relación con alguno o algunos de los principios presentes en las situaciones y actividades que suelen dar lugar a aprendizajes relevantes, profundos y con sentido y valor personal para los aprendices a los que antes nos hemos referido. Y en cuarto y último lugar, son actuaciones y estrategias que tienen un reflejo directo en el diseño y desarrollo de las actividades de enseñanza y aprendizaje en las aulas y son, en consecuencia, fáciles de detectar y percibir por el alumnado.

Hemos optado, en consecuencia, por no incluir en la EPAE-A cuestiones que, siendo sin duda relevantes desde una perspectiva de conjunto de la personalización del aprendizaje –por ejemplo, las relacionadas con aspectos de organización y funcionamiento de los centros educativos, la pericia del profesorado para detectar las necesidades e intereses de aprendizaje del alumnado o las competencias para autogestionar y autodirigir el aprendizaje–, son sin embargo a menudo de difícil detección y percepción para el alumnado. Así mismo, hemos renunciado a explorar las percepciones que tienen los alumnos de metodologías, propuestas didácticas y herramientas que, si bien suelen estar presentes en las propuestas e iniciativas de personalización del aprendizaje escolar –como, por ejemplo, las metodologías de indagación, el trabajo cooperativo, la evaluación competencial o el uso de las tecnologías digitales–, pueden concretarse de manera muy diversa en términos de las actuaciones del profesorado sin llegar a ser, como hemos comentado más arriba, específicas de los enfoques de personalización.

El proceso de construcción de la EPAE-A

El objetivo de este trabajo es presentar el proceso de construcción y desarrollo de una escala tipo Likert dedicada a explorar los posicionamientos del alumnado de educación primaria y secundaria ante un conjunto de actuaciones y estrategias de personalización del aprendizaje escolar, así como aportar evidencias psicométricas de su calidad. Este trabajo forma parte de un proyecto de investigación más amplio dedicado al análisis de prácticas de innovación educativa basadas en la personalización del aprendizaje desarrolladas en centros de educación primaria y secundaria de las comunidades de Catalunya, Extremadura y Madrid (España).

Diseño inicial de la escala

El punto de partida de la construcción de la escala fue una tipología de actuaciones y estrategias pedagógicas que, de acuerdo con la revisión realizada, promueven la realización de aprendizajes escolares con sentido y valor personal para el alumnado. Las categorías que conforman esta tipología definen las dimensiones iniciales de la escala. El equipo de investigación concretó cada categoría mediante una serie de afirmaciones relativas a la visión del alumnado sobre: (a) la frecuencia con que se produce una determinada actuación o estrategia de personalización en su escuela o instituto; (b) la importancia que le atribuyen; (c) su preferencia por participar en ella; y (d) el impacto que tiene sobre el propio proceso de aprendizaje. El anexo I muestra la tipología de actuaciones y estrategias, así como ejemplos de los aspectos explorados.

El listado completo de afirmaciones fue sometido a un proceso iterativo de revisión, discusión y reformulación con el fin de descartar repeticiones, mejorar la redacción y asegurar que en conjunto cubrían las categorías de la tipología presentada en el anexo I, así como los cuatro aspectos de frecuencia, importancia, preferencia e impacto. Como parte de este proceso, las afirmaciones fueron presentadas a alumnos de edades comprendidas entre los 10 y los 18 años en dos momentos diferentes con el fin de comprobar que eran comprendidas sin dificultad.

Con las 77 afirmaciones fruto del consenso alcanzado se construyó la primera versión de la escala, formada por 22 ítems de frecuencia y 55 de opinión. Construimos un alto número de ítems con la perspectiva de ir seleccionando los que tuvieran cargas factoriales y comunalidades más elevadas en cada dimensión durante el proceso de desarrollo, reforzando de este modo las evidencias de validez y fiabilidad de la escala y consiguiendo, al mismo tiempo, una extensión razonable que facilitase su aplicación. Graduamos las afirmaciones con cinco categorías de respuesta. En el caso de los ítems de frecuencia, estas categorías fueron: 1 = “Nunca”; 2 = “A veces”; 3 = “De vez en cuando”; 4 = “Frecuentemente”; y 5 = “Siempre”. Y en el caso de los ítems de opinión: 1 = “Totalmente en desacuerdo”; 2 = “En desacuerdo”; 3 = “Ni de acuerdo ni en desacuerdo”; 4 = “De acuerdo; y 5 = “Totalmente de acuerdo”.

Desarrollo de la escala

Una vez diseñada la primera versión de la escala, organizamos dos estudios piloto consecutivos con la intención de optimizarla. El primer estudio piloto nos permitió identificar una estructura conceptual de dimensiones de personalización del aprendizaje escolar que fuera compatible tanto con nuestra propuesta inicial -al menos, en parte- como con las respuestas que obtuvimos de los participantes. El segundo estudio piloto nos permitió poner a prueba esta estructura. Ambas pruebas piloto permitieron reducir considerablemente la cantidad de ítems de la escala.

Primera prueba piloto

En la primera prueba piloto participaron 507 alumnos de los centros implicados en el proyecto de investigación “Aprender con Sentido”. La escala fue aplicada en grupo, en contexto de aula, utilizando la plataforma en línea e-encuesta, y siempre con supervisión directa del profesor encargado. En todos los casos, un investigador explicó la finalidad de la escala y proporcionó las instrucciones para responderla. Además, el investigador estuvo presente durante todo el proceso respondiendo las preguntas y resolviendo las dudas planteadas por los alumnos.

Realizamos una serie de pruebas para valorar si los datos eran susceptibles de ser analizados mediante análisis factoriales (KMO = 0.87955; prueba de esfericidad de Bartlett, χ2 = 3053.0, df = 276, p = 0.01). Posteriormente, dividimos la muestra (N = 507) en tres sub-muestras independientes (N1 = 169; N2 = 169; N3 = 169). En un primer momento, utilizamos los datos de la primera sub-muestra (N1 = 169) para poner a prueba el grado de ajuste entre nuestra propuesta inicial de tipología de estrategias y actuaciones de personalización del aprendizaje escolar (ver anexo I) y las respuestas obtenidas de la aplicación de los cuestionarios. Con el fin de valorar dicho grado de ajuste, ejecutamos un análisis factorial confirmatorio (AFC) (Batista et al., 2004). En la ejecución de este análisis, utilizamos el método de estimación de mínimos cuadrados no ponderados (Manzano & Zamora, 2009). Posteriormente, valoramos los resultados obtenidos teniendo en cuenta los criterios de bondad de ajuste que aparecen en la Tabla I.

TABLA I. Criterios de bondad del ajuste3

|

Índice |

Hipótesis |

|

Chi-cuadrado (χ2) |

p > 0.05 |

|

Índice comparativo de bondad de ajuste (CFI) |

CFI ≥ 0.95 |

|

Índice de Tucker-Lewis (TLI) |

TLI ≥ 0.95 |

|

Raíz del residuo cuadrático medio estandarizado (SRMR) |

SRMR < 0.05 |

|

Root Mean Square Error of Approximation (RMSEA) |

RMSEA < 0.08 |

Los resultados del AFC mostraron un claro desajuste entre los datos obtenidos tras la aplicación a los participantes y el modelo propuesto inicialmente (χ2 = 3452.45, p < 0.01; CFI = 0.610; TLI = 565; SRMR = 0.112). Por este motivo, en un segundo momento iniciamos la búsqueda de un modelo teórico alternativo que sí se ajustara a las respuestas de los participantes.

Para buscar este modelo alternativo llevamos a cabo dos procedimientos diferentes sobre los datos de los participantes de la segunda sub-muestra (N2 = 169). En primer lugar, ejecutamos un análisis paralelo (Timmerman & Lorenzo-Seva, 2011), en el marco de un análisis factorial exploratorio (AFE) (Bandalos & Finney, 2018), que nos sugirió una estructura de factores anidados. De hecho, la distribución de las cargas factoriales y las comunalidades nos convencieron de que la escala en su conjunto estaba dividida de forma clara entre una sub-escala que englobaba todos los ítems con afirmaciones relativas a la importancia, preferencia e impacto, y que denominamos sub-escala de acuerdo, y otra sub-escala que englobaba todos los ítems de frecuencia.

En segundo lugar, ejecutamos una serie de AFE. Para ello, tomamos la decisión de calcular matrices de correlaciones policóricas, utilizar el método de mínimos cuadrados no ponderados y aplicar un método de rotación Promin (Howard, 2016). El cálculo de los AFE nos permitió ir eliminando de la escala aquellos ítems que cumplían con una de estas dos condiciones: (a) presentaban cargas factoriales y comunalidades por debajo de lo esperado; o (b) cargaban a una dimensión teóricamente incompatible (Izquierdo et al., 2014).

Como resultado de ambos procesos, obtuvimos una escala de 37 ítems organizada en dos sub-escalas. Más específicamente, obtuvimos una sub-escala de frecuencia de 10 ítems, organizados en una única dimensión, y una sub-escala de acuerdo de 27 ítems, organizados en cuatro dimensiones.

Para confirmar esta estructura factorial volvimos a ejecutar un AFC con los datos de la tercera sub-muestra de participantes (N3 = 169). En general, hallamos evidencias de la adecuación de un modelo teórico de una dimensión graduada en una sub-escala de frecuencia (χ2 = 495.828, p < 0.01; CFI = 0.960; TLI = 933; SRMR = 0.048) y cuatro dimensiones graduadas en una sub-escala de acuerdo (χ2 = 2479.93, p < 0.01; CFI = 0.968; TLI = 958; SRMR = 0.051).

Tras una valoración de los ítems agrupados en cada una de ellas, decidimos nombrar las cinco dimensiones de la escala desarrollada como sigue: (a) “frecuencia”; (b) “decisión y control sobre el proceso de aprendizaje”; (c) “base experiencial y vivencial”; (d) “conexiones entre experiencias de aprendizaje”; y (e) “reflexión sobre uno mismo como aprendiz y sobre el propio proceso de aprendizaje”.

Segunda prueba piloto

Habida cuenta del N relativamente bajo del primer estudio piloto, se decidió llevar a cabo un segundo estudio. El objetivo de este segundo estudio consistió en poner a prueba la estructura factorial formulada anteriormente con una muestra más amplia, concretamente con 1411 alumnos de centros de educación primaria y secundaria que participaron en el proyecto de investigación PERSONAE. Al igual que en el primer estudio piloto, la escala fue aplicada en grupo, en contexto de aula, utilizando la plataforma en línea Qualtrics, y siempre con supervisión directa del profesor encargado y la presencia de un investigador.

En este caso, se ejecutó el AFC para las dos sub-escalas. En un comienzo, el modelo teórico se adecuó menos a los datos que en la primera prueba piloto. Sin embargo, tras llevar a cabo algunas iteraciones en las que suprimimos algunos ítems, conseguimos mejorar sustancialmente los indicadores de ajuste, tanto en la sub-escala de frecuencia (χ2 = 1423.2, p < 0.01; CFI = 0.995; TLI = 0.990; SRMR = 0.017; RMSEA = 0.029) como en la de acuerdo (χ2 = 203.33, p > 0.01; CFI = 0.965; TLI = 0.831; SRMR = 0.032; RMSEA = 0.065). Más específicamente, eliminamos tres ítems de la sub-escala de acuerdo.

En síntesis, la segunda prueba piloto permitió conseguir evidencias de la estructura factorial de dos sub-escalas con cuatro y una dimensión, respectivamente. Además, pudimos reducir el tamaño de la sub-escala de acuerdo, por lo que ensamblamos una versión definitiva de la escala con 34 ítems en total. De este modo, dimos por finalizada la etapa de desarrollo de la escala EPAE-A. En la Tabla II se resumen los datos principales del proceso seguido desde la formulación inicial de los ítems hasta la versión de la escala resultante de la segunda prueba piloto.

TABLA II. Desarrollo de la escala

|

Construcción Inicial |

Primera prueba piloto |

Segunda prueba piloto |

|||

|

Escala de Personalización del aprendizaje Escolar -Alumnado (EPAE-A) |

Alumnos participantes (N) |

--- |

507 |

1411 |

|

|

Sub-escala de frecuencia |

Número de ítems |

22 |

10 |

10 |

|

|

Dimensiones Teóricas/Factores |

8 |

1 |

1 |

||

|

Alfa de Cronbach |

- |

0.906 |

0.895 |

||

|

Omega de McDonald |

- |

0.907 |

0.916 |

||

|

Sub-escala de acuerdo |

Número de ítems |

55 |

27 |

24 |

|

|

Dimensiones Teóricas/Factores |

8 |

4 |

4 |

||

|

Alfa de Cronbach |

- |

0.866 |

0.854 |

||

|

Omega de McDonald |

- |

0.852 |

0.897 |

||

Nota: En la construcción inicial de la escala no se llevaron a cabo pruebas estadísticas.

Propiedades psicométricas de la escala EPAE-A

Participantes

Con el fin de obtener evidencias de la validez y fiabilidad de la escala construida se llevó a cabo una aplicación de la versión definitiva a una nueva muestra de 4909 estudiantes matriculados en los centros de educación primaria y secundaria participantes en el proyecto de investigación PERSONAE. 2543 (51,8%) de ellos se reconocieron como parte del género masculino, 2327 (47,4%) como parte del género femenino y 39 (0,8%) no se reconocieron como pertenecientes a ninguno de los dos géneros. 1294 (26,4%) eran alumnos de educación primaria, 3001 (61,1%) de educación secundaria obligatoria y 654 (12,5%) de Bachillerato. El promedio de edad fue de 13.3 años (SD = 2.23). Ninguno de los modelos varió de manera sustancial al buscar diferencias entre grupos. La plataforma utilizada y las condiciones de aplicación fueron las mismas que en el segundo estudio piloto.

Análisis

En concreto, exploramos dos propiedades psicométricas que diferentes investigadores coinciden en señalar como especialmente relevantes para valorar la calidad de una escala (Aiken, 2003; Carmines & Zeller, 1988; Prieto & Delgado, 2010). En primer lugar, buscamos evidencias de validez. La validez es el grado en que diferentes evidencias acumuladas sobre el uso de una escala apoyan la interpretación deseada de sus resultados para un fin previsto (American Educational Research Association, American Psychological Association & National Council on Measurement in Education, 1999). En nuestro caso, decidimos conseguir evidencias de validez basadas en el constructo (Kane, 2012). Este tipo de evidencias nos permiten comprobar el grado de ajuste entre las puntuaciones obtenidas por los encuestados y la estructura factorial teórica prevista por los constructores (Kane, 2016). Con el propósito de valorar el grado de validez de constructo de nuestra escala, ejecutamos un AFC sobre los datos obtenidos (Batista et al., 2004). Igual que en las fases de construcción y desarrollo de la escala, usamos el método de estimación de mínimos cuadrados no ponderados (Manzano & Zamora, 2009). Asimismo, volvimos a contrastar los resultados obtenidos con los criterios de bondad de ajuste que aparecen en la tabla I.

En segundo lugar, exploramos la fiabilidad de la escala. La fiabilidad se entiende como la consistencia o estabilidad de los resultados obtenidos cuando un proceso de medición se repite varias veces en el tiempo (Cohen et al., 1996). Desde un punto de vista práctico, para conocer el grado de fiabilidad de una escala se calculan coeficientes de consistencia interna como el coeficiente alfa de Cronbach, que es uno de los más utilizados en la actualidad para valorar la fiabilidad de los cuestionarios (Zumbo & Rupp, 2004). Sin embargo, su aplicación plantea algunas dudas cuando las categorías de respuesta tienen una naturaleza ordinal, como ocurre en nuestro caso. Por este motivo, en este estudio también incluimos otro indicador que parece ser más apropiado en estas circunstancias: el coeficiente omega de McDonald (McDonald, 1999). En la Tabla III hemos sintetizado los criterios estadísticos que se recomiendan en la literatura especializada (e.g. Elosúa & Zumbo, 2008) y que utilizamos para valorar los indicadores de consistencia interna.

TABLA III. Criterios de valoración de los indicadores de consistencia interna.

|

Indicador |

Valores aceptables |

|

Alfa de Cronbach |

0.75 < α < 0.95 |

|

Omega de McDonald |

0.85 < ɷ |

Conviene mencionar que todos los análisis de datos se ejecutaron mediante el uso del software Stata v.16.

Resultados

Antes de ejecutar las pruebas psicométricas, hicimos una exploración preliminar de los datos. No encontramos datos atípicos o perdidos, pero sí encontramos distribuciones no lineales en varios ítems. Por este motivo, aplicamos la corrección para datos no normales de Satorra-Bentler a todos los análisis posteriores (Asparouhov & Muthén, 2010).

Posteriormente, evaluamos la pertinencia de usar el AFC sobre la matriz de datos. Tanto el cálculo del estadístico KMO (KMO = 0.886) como la prueba de esfericidad de Bartlett (χ2 = 3015.2, df = 190, p < 0.01) sugirieron la adecuación de los datos.

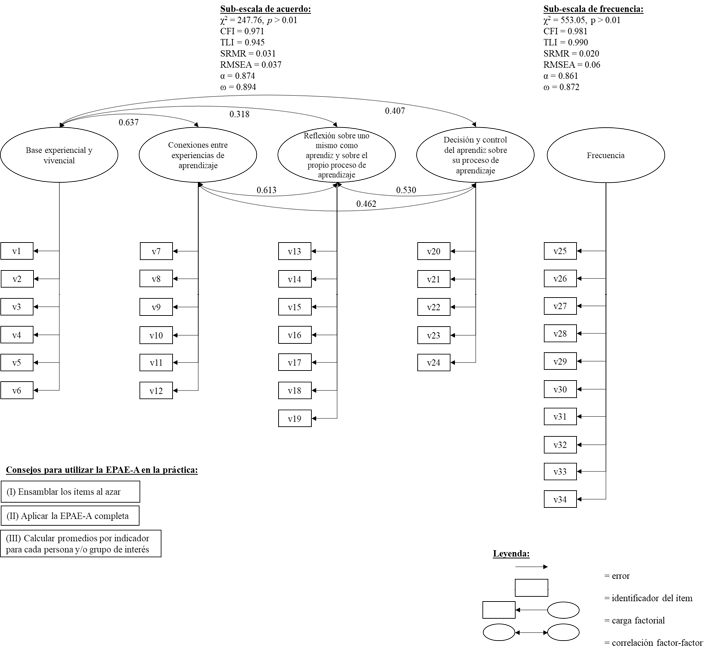

Los resultados obtenidos nos permiten concluir que, en términos generales, nuestra escala cuenta con evidencias sólidas de validez de estructura interna y fiabilidad. En el caso de las evidencias de validez de estructura interna, los análisis arrojaron resultados positivos en ambas sub-escalas (ver Tabla IV). En la sub-escala de acuerdo, las puntuaciones obtenidas por los participantes se articularon siguiendo la estructura teórica tetradimensional propuesta (χ2 = 247.76, p > 0.01; CFI = 0.971; TLI = 0.945; SRMR = 0.031; RMSEA = 0.037). En la sub-escala de frecuencia las puntuaciones obtenidas por los participantes se agruparon siguiendo la estructura unidimensional hipotetizada (χ2 = 553.05, p > 0.01; CFI = 0.981; TLI = 0.990; SRMR = 0.020; RMSEA = 0.06). Estos resultados son coherentes con los resultados preliminares obtenidos durante la fase de construcción y desarrollo de la escala.

TABLA IV. Índices de ajuste de la estructural factorial propuesta para cada sub-escala

|

Prueba |

Criterios |

Sub-escala frecuencia |

Sub-escala acuerdo |

|

Chi-cuadrado (χ2) |

p > 0.05 |

0.177 |

0.257 |

|

Índice comparativo de bondad de ajuste (CFI) |

CFI ≥ 0.95 |

0.981 |

0.971 |

|

Índice de Tucker-Lewis (TLI) |

TLI ≥ 0.95 |

0.990 |

0.945 |

|

Raíz del residuo cuadrático medio estandarizado (SRMR) |

SRMR < 0.05 |

0.02 |

0.031 |

|

Root Mean Square Error of Approximation (RMSEA) |

RMSEA < 0.08 |

0.06 |

0.037 |

Una vez calculados los índices de ajuste, nos propusimos calcular los índices de consistencia interna para ambas sub-escalas (ver Tabla V). Como se puede observar, estos índices arrojan valores aceptables. Conviene mencionar, no obstante, que en el caso de la sub-escala de acuerdo los valores son algo más bajos (α = 0.861; ω = 0.872) que en el caso de la sub-escala de frecuencia (α = 0.874; ω = 0.894).

TABLA V. Índices de consistencia interna para cada sub-escala

|

Prueba |

Criterios |

Sub-escala frecuencia |

Sub-escala acuerdo |

|

Alfa de Cronbach |

α ≥ 0.85 |

0.874 |

0.861 |

|

Omega de McDonald |

ω ≥ 0.85 |

0.894 |

0.872 |

En definitiva, la escala construida mostró evidencias sólidas de validez de estructura interna y fiabilidad. La Figura I sintetiza las evidencias de validez y fiabilidad de la versión definitiva de la escala de posicionamiento del alumnado de educación primaria y secundaria ante la personalización del aprendizaje.

FIGURA I. Evidencias de validez y fiabilidad de la EPAE-A.

Nota. Los ítems asociados (vn) se pueden consultar en el anexo II.

Para aplicar y analizar esta escala

La escala puede ser administrada por cualquier profesor o profesora que desee contar con información sobre el posicionamiento de su alumnado ante las estrategias de personalización del aprendizaje escolar. Para analizar la información obtenida, recomendamos utilizar los promedios obtenidos por cada persona o grupo en cada uno de los factores. Es decir, la EPAE-A no está diseñada para calcular un indicador global, sino más bien cinco indicadores diferentes que apuntan a los diferentes factores.

Discusión

El diseño de la EPAE-A cumple con los estándares de calidad y validación y está en línea con los procedimientos secuenciales de los análisis estadísticos orientados a la búsqueda de relaciones entre variables a través de factores (Boateng et al, 2018). El proceso seguido en el desarrollo de la escala ha permitido optimizarla mediante dos pruebas piloto sucesivas (N=507; N=1411). La validación de la escala con un número elevado de respuestas (N=4909) refleja la solidez del instrumento para medir la percepción que tiene el alumnado de las actuaciones y estrategias del profesorado orientadas a la personalización del aprendizaje escolar. Conviene señalar, al respecto, que el tamaño de la muestra utilizada para obtener evidencias de la validez y fiabilidad de la EPAE-A es sensiblemente mayor al de las muestras que se han utilizado habitualmente en la construcción y validación de este tipo de escalas (e.g., Underwood & Banyard, 2014; Waldrip et al., 2014).

Los ítems de las ocho categorías de actuaciones y estrategias del profesorado de las que hemos partido en la construcción de la escala se han agrupado finalmente en cuatro factores como resultado de los análisis psicométricos. La lectura de los ítems (ver anexos I y II) muestra que, pese a haber visto reducido su número, la escala final contempla las principales dimensiones de las propuestas e iniciativas de personalización del aprendizaje. Las agrupaciones de los ítems en factores se corresponden mayoritariamente con las categorías de actuaciones y estrategias de partida.

Hay, sin embargo, dos grupos de ítems que no se agrupan en factores diferenciados, sino que aparecen distribuidos entre los otros cuatro resultantes del análisis factorial. Son los correspondientes a las categorías iniciales de toma en consideración de los intereses y objetivos del alumnado, y de incorporación y aprovechamiento de los recursos y oportunidades para aprender presentes en el entorno comunitario y en los contextos no escolares de actividad. La importancia de este hecho reside en que, como se ha mencionado en la introducción, ambos tipos de actuaciones, sobre todo las relativas a la toma en consideración de los intereses y objetivos del alumnado, están presentes de forma generalizada en las propuestas e iniciativas orientadas a la personalización del aprendizaje. Lejos de cuestionar su importancia, este resultado refuerza, a nuestro juicio, la centralidad de la toma en consideración de los intereses y objetivos del alumnado en la personalización del aprendizaje y su interconexión con otras actuaciones y estrategias. Trabajar a partir de y con los intereses del alumnado está estrechamente relacionado con el reconocimiento y la aceptación de su capacidad para dirigir su propio proceso de aprendizaje, la identificación y puesta en relación de sus experiencias de aprendizaje escolares y no escolares o la reflexión individual y colectiva sobre el origen y alcance de esos intereses. Desde esta perspectiva, es razonable interpretar el hecho de que los ítems relacionados con los intereses aparezcan repartidos entre los cuatro factores como un reflejo de la centralidad de los intereses en los enfoques de personalización del aprendizaje.

Permítasenos aún llamar la atención sobre la estructura unidimensional de la sub-escala de “frecuencia”. Si bien este resultado se aleja de nuestras expectativas de encontrar en ella una estructura de factores similar o parecida a la de la sub-escala de acuerdo, es coincidente con una aportación del trabajo de Underwood & Banyard (2008) que, comparando las percepciones de la personalización del aprendizaje del profesorado y del alumnado, concluyen que los estudiantes “tienden fuertemente a ver la personalización como individualización” y a preguntarse sobre el grado de libertad y de iniciativa que tienen (p 245). Esta tendencia podría estar igualmente en la base de la estructura unidimensional de la sub-escala de frecuencia en la medida en que la mayoría de los ítems que la conforman incorporan, bajo una u otra forma y con mayor o menor claridad según los casos, una referencia al grado de iniciativa y de libertad del estudiante.

En suma, los resultados presentados nos permiten afirmar que la EPAE-A es una herramienta que cuenta con evidencias sólidas de validez y fiabilidad para su uso en centros educativos españoles. El trabajo realizado, sin embargo, deja algunas cuestiones abiertas entre las que queremos destacar dos. La primera concierne a la franja de edad del alumnado para el que ha sido elaborada, que abarca desde los 10 hasta los 18 años, así como la composición de la muestra de 4909 estudiantes utilizada en la validación final. Dos posibilidades se abren a este respecto. Por una parte, habida cuenta de la amplitud del intervalo de edades y de las diferencias existentes en el sistema educativo español entre los tres niveles educativos, tiene sentido, a nuestro entender, explorar una eventual diferenciación de la EPAE-A en tres versiones distintas para el alumnado de educación primaria, de educación secundaria obligatoria y de bachillerato. Por otra parte, pensamos que una réplica de la validación con una muestra de alumnado con un reparto más equilibrado entre las tres franjas de edad daría aún mayor solidez a las evidencias de validez y fiabilidad de la escala, especialmente si el N es de una magnitud similar a la utilizada en este trabajo.

La segunda cuestión abierta que queremos destacar concierne al contexto específico del sistema educativo español para el que ha sido elaborado la escala y en el que se ha llevado a cabo su validación. Las percepciones del alumnado –y, por supuesto, también del profesorado– ante las actuaciones y estrategias de personalización del aprendizaje están sin duda influidas por la tradición y la cultura pedagógica dominante en el sistema educativo español y en las instituciones educativas de las que forman parte y en las que se han socializado como alumnos. Sería interesante, en consecuencia, comprobar si la estructura factorial de la EPAE-A se mantiene con muestras de estudiantes pertenecientes a sistemas e instituciones educativas con tradiciones y culturas pedagógicas distintas.

Referencias bibliográficas

Aiken, L. R. (2003). Tests psicológicos y evaluación. Pearson Educación.

American Psychological Association (2015). Top 20 principles from psychology for preK-12 teaching and learning. http://www.apa.org/ed/schools/teaching-learning/top-twenty-principles.pdf]

American Educational Research Association [AERA], American Psychological Association [APA] & National Council on Measurement in Education [NCME]. (1999). Standards for Educational and Psychological Testing. American Psychological Association.

Asparouhov, T., & Muthén, B. (2010). Computing the strictly positive Satorra-Bentler chi-square test in Mplus. Mplus Web Notes, 1-12.

Australian Curriculum, Assessment and Reporting Authority (ACARA) (2013). Student Diversity and the Australian Curriculum. Advice for principals, schools and teachers. Sydney: ACARA. https://docplayer.net/5749166-Student-diversity-and-the-australian-curriculum.html.

Bandalos, D. L., & Finney, S. J. (2018). Factor analysis: Exploratory and confirmatory. En The reviewer’s guide to quantitative methods in the social sciences (pp. 98-122). Routledge.

Batista-Foguet, J. M., Coenders, G., & Alonso, J. (2004). Análisis factorial confirmatorio. Su utilidad en la validación de cuestionarios relacionados con la salud. Medicina clínica, 122(1), 21-27.

Boateng, G.O., Neilands, T.B., Frongillo, E.A., Melgar-Quiñonez, H.R. & Sera L. Young, S.L. (2018). Best Practices for Developing and Validating Scales for Health, Social, and Behavioral Research: A Primer. Frontiers in Public Health, 6:149, 1-18. https://doi.org/10.3389/fpubh.2018.00149

Bray, B., & McClaskey, K. (2013). A step-by-step guide to personalize learning. Learning & Leading with Technology, 40(7), 12–19.

Bray, B., & McClaskey, K. (2015). Make learning personal: The what, who, WOW, where, and why. Corwin Press.

Carmines, E.G. & Zeller, R.A. (1988). Reliability and Validity Assessment. Sage.

Cohen, R. J., Swerdlik, M. E., & Phillips, S. M. (1996). Psychological testing and assessment: An introduction to tests and measurement. Mayfield Publishing Co.

Chrysafiadi, K., Virvou, M. & Sakkopoulos, E. (2020). Optimizing Programming Language Learning Through Student Modeling in an Adaptive Web-Based Educational Environment. En M. Virvou, E. Alepis, G.A. Tsihrintzis & L.C. (Eds.), Machine Learning Paradigms. Advances in Learning Analytics (pp. 205-223). Springer.

DeMink-Carthew, J. & Netcoh, S. (2019) Mixed Feelings about Choice: Exploring Variation in Middle School Student Experiences with Making Choices in a Personalized Learning Project. RMLE Online, 42(10), 1-20. https://doi.org/10.1080/19404476.2019.1693480.

Department for Education and Skills (DfES). (2004) A national conversation about personalised learning. DfES. https://www.education.gov.uk/publications/eOrderingDownload/DfES%200919%20200MIG186.pdf.

Elosúa Oliden, P., & Zumbo, B. D. (2008). Coeficientes de fiabilidad para escalas de respuesta categórica ordenada. Psicothema, 20(4), 896-901.

FitzGerald, E., Jones, A.; Kucirkova, N. & Scanlon, E. (2018). A literature synthesis of personalised technology-enhanced learning: what works and why. Research in Learning Technology, 26: 2095, 1-16. http://dx.doi.org/10.25304/rlt.v26.2095

Grant, P. & Basye, D. (2014). Personalised Learning. A Guide for Engaging Students with Technology. International Society for Technology in Education -ISTE.

Hammonds, V. & Moyer, J. (2018). From Vision to Reality. Personalized, Competency-Based Education for All Kids. https://knowledgeworks.org/resources/vision-reality-personalized-cbe/.

Holmes, W., Anastopoulou, S., Schaumburg, H. and Mavrikis, M. (2018). Technology-enhanced Personalised Learning: Untangling the Evidence. Open Research Online. The Open University. http://www.studie-personalisiertes-lernen.de/en/.

Howard, M. C. (2016). A review of exploratory factor analysis decisions and overview of current practices: What we are doing and how can we improve?. International Journal of Human-Computer Interaction, 32(1), 51-62. https://doi.org/10.1080/10447318.2015.1087664

Izquierdo, I., Olea, J., & Abad, F. J. (2014). El análisis factorial exploratorio en estudios de validación: usos y recomendaciones. Psicothema, 26(3), 395-400. https://doi.org/10.7334/psicothema2013.349

Johnson, L., Adams Becker, S., Estrada V., Freeman, A., Kampylis, P., Vuorikari, R. & Punie, Y. (2014). NMC Horizon Report Europe - 2014 Schools Edition. The New Media Consortium. http://publications.europa.eu/resource/cellar/1eda751c-a440-4b5e-8b53-04243d3ff8b3.0001.02/DOC_1

Jonnaert, Ph. (2019). Action située – Agir compétent. BACSE International. Paper online: http://bacseinternational.com.

Jones, M. & McLean, K. (2018). Chapter 2. Personalising Learning: An Overview. En M. Jones & K, McLean, Personalising Learning in Teacher Education (pp. 9-23). Springer Nature Singapore Pte Ltd. https://doi.org/10.1007/978-981-10-7930-6

Jones, A., Scanlon, E., Gaved, M., Blake, C., Collins, T., Clough, G., Kerawalla, L., Littleton, K., Mulholland, P., Petrou, M. & Twiner, A. (2013). Challenges in personalisation: supporting mobile science inquiry learning across contexts. Research and Practice in Technology Enhanced Learning, 8(1), 21–42.

Kane, M. (2012). All validity is construct validity. Or is it?. Measurement: Interdisciplinary Research & Perspective, 10(1-2), 66-70. https://doi.org/10.1080/15366367.2012.681977.

Kane, M. T. (2016). Explicating validity. Assessment in Education: Principles, Policy & Practice, 23(2), 198-211.

Kabassi, K. & Alepis, E. (2020). Learning Analytics in Distance and Mobile Learning for Designing Personalised Software. En M. Virvou, E. Alepis, G.A. Tsihrintzis & L.C. (Eds.), Machine Learning Paradigms. Advances in Learning Analytics (pp. 185-203). Springer.

Kenny, D. A., Kaniskan, B., & McCoach, D. B. (2015). The performance of RMSEA in models with small degrees of freedom. Sociological Methods & Research, 44(3), 486-507. https://doi.org/10.1177/0049124114543236.

Lee, D. (2014). How to Personalize Learning in K-12 Schools: Five Essential Design Features. Educational Technology, 54(3),12-17.

Levine, E. & Patrick, S. (2019). What is Competency-Based Education. An updated definition. Aurora Institute. https://aurora-institute.org/resource/what-is-competency-based-education-an-updated-definition/

Manzano, P. A. & Zamora M., Salvador (2009). Sistema de Ecuaciones Estructurales: Una Herramienta de Investigación. Cuaderno Técnico 4. Centro Nacional de Evaluación para la Educación Superior, A.C. https://docplayer.es/42086072-Sistema-de-ecuaciones-estructurales-una-herramienta-de-investigacion.html

Marope, M. (2017a). Reconceptualizing and Repositioning Curriculum in the 21st Century. A Global Paradigm Shift. IBE-UNESCO. http://bit.ly/2wIkJm5

Marope, M. (2017b). Future Competences and the Future of Curriculum. A global reference for Curricula Transformation. IBE-UNESCO. http://www.ibe.unesco.org/es/news/document-future-competences-and-future-curriculum

McDonald, R. P. (1999). Test theory: A unified treatment. Lawrence Erlbaum Associates.

National Academies of Sciences, Engineering, and Medicine. (2018). How People Learn II: Learners, Contexts, and Cultures. The National Academies Press. https://doi.org/10.17226/24783

Netcoh, S. (2017). Students’ Experiences with Personalized Learning: An Examination Using Self-Determination Theory. University of Vermont. Graduate College Dissertations and Theses. https://scholarworks.uvm.edu/graddis/738

Organisation for Economic Co-operation and Development (OECD) (2006). Schooling for Tomorrow: Personalising Education. OECD Publishing.

Organisation for Economic Co-operation and Development (OECD) (2017). The principles of learning to design learning environments. En The OECD Handbook for Innovative Learning Environments (chapter 1, pp. 21-40). OECD Publishing.

Olofson, M.W. & Downes, J. (2018). An Instrument to Measure Teacher Practices to Support Personalized Learning in the Middle Grades. RMLE Online, 41(7), 1-21, https://doi.org/10.1080/19404476.2018.1493858

Perrenoud, Ph. (2000). L’école saisie par les compétences. En: Ch. Bosman, F.-M. Gerard & X. Roegiers (Eds.), Quel avenir pour les compétences? (pp. 21-41). De Boeck & Larcier.

Prain, V., Cox, P., Deed, C., Dorman, J., Edwards, D., Farrelly, C., Keeffe, M., Lovejoy, V., Mow, L., Sellings, P., Waldrip, B. & Yager, Z. (2013). Personalised learning: lessons to be learnt. British Educational Research Journal, 39(4), 654–676. http://dx.doi.org/10.1080/01411926.2012.669747

Prieto, G., & Delgado, A. R. (2010). Fiabilidad y validez. Papeles del psicólogo, 31(1), 67-74.

Sawyer, R.K. (2014). Introduction: The New Science of Learning. En R. K. Sawyer (Ed.), The Cambridge Handbook of Learning Sciences. Second Edition (pp. 1-18). Cambridge University Press.

Schmid, R. & Petko, D. (2019). Does the use of educational technology in personalized learning environments correlate with self-reported digital skills and beliefs of secondary-school students? Computers & Education, 136, 75–86. https://doi.org/10.1016/j.compedu.2019.03.006

Timmerman, M. E., & Lorenzo-Seva, U. (2011). Dimensionality Assessment of Ordered Polytomous Items with Parallel Analysis. Psychological Methods, 16, 209-220. https://doi.org/10.1037/a0023353

Underwood, J., Baguely, Th., Banyard, Ph., Dillon, G., Farrington-Flint, L., Hayes, M., Hick, P., LeGeyt, G., Murphy, J., Selwood, I. & Wright, M. (2009). Personalising Learning. BECTA. https://webarchive.nationalarchives.gov.uk/20110107182133/http://research.becta.org.uk/index.php?section=rh&&catcode=_re_rp_02&rid=14546

Underwood , J.& Banyard , Ph. (2008). Managers’, teachers’ and learners’ perceptions of personalised learning: evidence from Impact 2007. Technology, Pedagogy and Education, 17(3), 233-246. https://doi.org/10.1080/14759390802383850

UNESCO-IBE (2017). Training Tools for Curriculum Development: Personalized Learning. IBE-UNESCO.

US Department of Education (2010). Transforming American Education. Learning Powered by Technology. National Education Technology Plan 2010. Department of Education. Education Publications Center. https://bit.ly/3arpHCO

Waldrip, B., Cox, P., Deed, C., Dorman, J., Edwards, D., Farrelly, C., et al. (2014). Student perceptions of personalised learning: Validation and development of questionnaire with regional secondary students. Learning Environments Research, 17(3), 355–370. https://doi.org/10.1007/s10984-014-9163-0

Waldrip, B., Yu, J.J. & Prain, V. (2016). Validation of a model of personalized learning. Learning Environments Research, 19, 169-180. https://doi.org/10.1007/s10984-016-9204-y

Watson, W., & Watson, S. L. (2017). Principles for personalized instruction. En C. Reigeluth, B. J. Beatty, & R. D. Myers (Eds.). Instructional-design theories and models, volume IV: The learner-centered paradigm of education (pp. 87–108). Routledge.

Zumbo, B. D., & Rupp, A. A. (2004). Responsible modeling of measurement data for appropriate inferences. SAGE.

Información de contacto: César Coll. Universidad de Barcelona, Facultad de Psicología, Departamento de Cognición, Desarrollo y Psicología de la Educación. Pg. de la Vall d’Hebron, 171, 08035 Barcelona. E-mail: ccoll@ub.edu

1 Este trabajo ha sido realizado como parte de un proyecto de investigación financiado por el Ministerio de Economía, Industria y Competitividad del gobierno de España (PERSONAE –El desafío de la personalización del aprendizaje escolar: principios, posicionamientos e implementación en los centros educativos. Referencia: EDU2013-40965-R). Se puede obtener más información sobre este proyecto y el grupo de investigación en https://ble.psyed.edu.es/proyectos-actuales/proyecto-personae/

2 “Un intercambio productivo entre (a) la capacidad del profesorado en la identificación de, y el trabajo con, las necesidades curriculares individuales del estudiantado, y (b) la capacidad del estudiantado para desarrollar, a lo largo del tiempo, una autonomía progresiva como aprendices” (traducción al español de los autores).

3 Nota. Reportamos la raíz del error cuadrático medio de aproximación (RMSEA) en todos los casos, excepto en aquellos en los que contamos con un bajo tamaño muestral, tal como sugieren Kenny, Kaniskan y McCoach (2015).