VALIDACIÓN DE LA ESCALA TPACK-DGG Y SU IMPLEMENTACIÓN PARA MEDIR LA AUTOPERCEPCIÓN DE LAS COMPETENCIAS DIGITALES DOCENTES Y LA BRECHA DIGITAL DE GÉNERO EN LA FORMACIÓN DEL PROFESORADO

Validation of the TPACK-DGG scale and its implementation to measure self-perception of teacher digital competencies and the digital gender gap in teacher training

ISABEL MARÍA GÓMEZ-TRIGUEROS

Universidad de Alicante (España)

DOI: 10.13042/Bordon.2023.100758

Fecha de recepción: 04/07/2023 • Fecha de aceptación: 14/11/2023

Autora de contacto / Corresponding autor: Isabel María Gómez-Trigueros. E-mail: isabel.gomez@ua.es

Cómo citar este artículo: Gómez-Trigueros, I. M.ª (2023). Validación de la escala TPACK-DGG y su implementación para medir la autopercepción de las competencias digitales docentes y la brecha digital de género en la formación del profesorado. Bordón, Revista de Pedagogía, 75(4), 151-176. https://doi.org/10.13042/Bordon.2023.100758

INTRODUCCIÓN. Entre las competencias que debe poseer un docente se encuentra la competencia digital. Se trata de una habilidad clave para poder participar en la actual sociedad hiperconectada del siglo XXI. Una de las tareas principales del profesorado es formar a la ciudadanía para su plena integración social. Así, se torna imprescindible que el profesorado disponga de competencias digitales para una educación de calidad, evitando brechas digitales también de género. MÉTODO. Los objetivos planteados son dos: el primero, validar la escala TPACK-DGG para medir la autopercepción en competencias digitales docentes y la brecha digital de género; el segundo, analizar las percepciones en la autoeficacia del modelo TPACK-DGG en los futuros docentes en formación. Para la consecución del primer objetivo, se utilizó el panel de expertos y un aprueba piloto; para el segundo objetivo, se aplicó el instrumento en una muestra de 1.059 estudiantes universitarios de Grado y de Máster. Se utilizó el programa estadístico SPSS v.26 para medir las propiedades psicométricas del instrumento. RESULTADOS. Los resultados obtenidos confirman que el modelo TPACK-DGG confeccionado ad hoc y adaptado al contexto español cuenta con consistencia interna, rigor y estabilidad estructural para servir como instrumento de medición de competencias digitales docentes. De igual forma, se confirma la persistencia de la brecha digital de género entre el profesorado en formación identificado en diferencias significativas entre mujeres y hombres, en dos dimensiones del modelo TPACK-DGG. DISCUSIÓN. El instrumento cumple con estabilidad estructural y consistencia interna. Se confirma la idoneidad del instrumento TPACK-DGG para medir las dimensiones de autopercepción en competencias digital docente y brecha digital de género del futuro profesorado. Estos resultados inciden en la importancia de continuar investigando sobre la persistencia de las brechas digitales en la formación inicial del profesorado en las facultades españolas.

Palabras clave: TPACK-DGG, Instrumento, Validación, Brecha digital, Formación de docentes.

Introducción

Los avances tecnológicos producidos desde los años setenta del siglo pasado han dado lugar a una auténtica revolución digital. Las tecnologías han traído consigo un entorno en el que es posible acceder, compartir y elaborar un gran volumen de información a escala mundial y en un tiempo impensable hace unos años. Este nuevo entorno, conocido como sociedad de la información y del conocimiento (SIC), está introduciendo cambios en todos los ámbitos de la vida. Tales transformaciones, producidas por el uso generalizado de las tecnologías, hacen imprescindible asegurar que toda la ciudadanía asuma una formación en este campo. Esto implica, de manera especial, cambios en los sistemas educativos, en lo que se refiere a metodologías de enseñanza y de aprendizaje y a la formación del profesorado.

De manera concreta, se precisa el desarrollo de la competencia digital del profesorado desde un proceso de alfabetización digital, que considere el desarrollo de habilidades y conocimientos tecnológicos, comunicativos, mediáticos e informacionales y que incluya el desarrollo y la creación de conocimiento (UNESCO, 2019UNESCO (2019). Marco de competencias de los docentes en materia de TIC UNESCO. https://unesdoc.unesco.org/ark:/48223/pf0000371024 ). En esta línea, son las facultades de educación las que deben habilitar un proceso formativo inicial y continuo para que el profesorado adquiera conocimiento sobre información, comunicación, creación de contenido, seguridad y resolución de problemas con tecnología.

TPACK para la competencia digital docente del profesorado en formación

Aunque desde la implantación del Espacio Europeo de Educación Superior (EEES), los planes de estudio de los títulos contemplan materias orientadas a la implementación de las tecnologías en los procesos educativos, todavía a fecha de hoy sigue siendo una tarea pendiente.

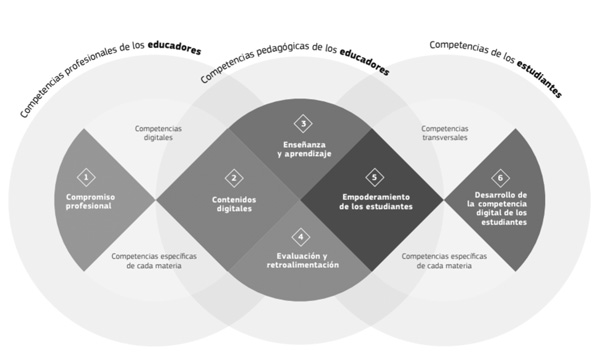

El Marco Europeo de Competencia Digital del Profesorado (DigCompEdu), publicado en 2017, diseñado por el Centro Común de Investigación de la Unión Europea o JRC (Redecker y Punie, 2017Redecker, C. y Punie, Y. (2017). Digital Competence of Educators DigCompEdu. Publica-tions Office of the European Union.) se presenta como un modelo para el desarrollo de las competencias digitales docentes. Se considera un referente para adecuar la capacitación de los futuros docentes en el uso y apropiación de las tecnologías para la educación en torno a seis áreas competenciales:

- Compromiso profesional en relación con el uso de las tecnologías en los centros educativos.

- Recursos digitales desde la labor docente para utilizarlos como fuentes de información, para crear nuevos contenidos y para su correcta distribución a través de las herramientas digitales.

- Pedagogía digital docente relacionada con la capacidad de implementar los recursos digitales a lo largo del proceso educativo.

- Evaluación con tecnologías en tanto que su correcta apropiación para medir el desarrollo de los aprendizajes de los estudiantes.

- Formar al alumnado en el correcto uso de los recursos digitales, mostrando su capacidad como herramientas de aprendizaje y de acceso al conocimiento.

- Promover y desarrollar la competencia digital del alumnado.

A partir de estas seis áreas, el DigComEdu señala seis niveles que hacen mención a las cualificaciones de las y los docentes en el uso de estos recursos tecnológicos. Se concretan en (Redecker, 2020Redecker, C. (2020). Marco Europeo para la Competencia Digital de los Educadores: DigCompEdu (trad. Fundación Universia y Ministerio de Educación y Formación Profesional de España). Secretaría General Técnica del Ministerio de Educación y Formación Profesional de España (original publicado en 2017).):

- Novel (A1): relacionado con el profesorado que lleva a cabo un escaso uso de las tecnologías digitales para interactuar con su alumnado.

- Explorador (A2): aquellas y aquellos docentes que utilizan estrategias digitales básicas para interactuar con su alumnado.

- Integrador (B1): relativo a aquel profesorado que hace uso de las tecnologías digitales para mejorar la interacción con su alumnado.

- Experto (B2): en relación con aquellas y aquellos docentes que hacen uso de las tecnologías digitales para mejorar el seguimiento y la orientación de su alumnado en el proceso de enseñanza y aprendizaje.

- Líder (C1): el profesorado que emplea las tecnologías digitales de forma estratégica y deliberada para proporcionar orientación y apoyo a su alumnado.

- Pionero (C2): relativo a aquellas y aquellos docentes que hacen uso de las tecnologías digitales para innovar la prestación de orientación.

Toda esta normativa e instrucciones, que emanan de los diferentes entes públicos, debe tener su reflejo en las aulas de las facultades de educación españolas, nicho de docentes en formación. Se antojan, por tanto, requerimientos clave, que se deben tener en cuenta, en la adecuada formación del profesorado de los centros de educación primaria y de educación secundaria de España.

Son muchas y diversas las propuestas diseñadas para lograr la correcta formación tecnológica del profesorado. Algunos de estos estudios van desde la dimensión solo manipulativa del software y del hardware, característico de investigaciones de principios del siglo XX (Albalat, 2000Albalat, J. Q. (2000). Competencias en tecnologías de la información del profesorado de educación infantil y primaria. Revista Interuniversitaria de Tecnología Educativa, 166-174.; Duart y Sangrà, 2000Duart, J. M. y Sangrà, A. (2000). Aprender en la Virtualidad. Gedisa Editorial.), hasta trabajos más profundos, implicados en la formación didáctico-tecnológica (Prendes y Gutiérrez, 2013Prendes, M. P. y Gutiérrez, I. (2013). Competencias tecnológicas del profesorado en las universidades españolas. Revista de Educación, 361, 196-222. https://doi.org/10.4438/1988-592X-RE-2011-361-140 ; Marimon-Martí et al., 2023Marimon-Martí, M., Romeu, T., Usart, M., y Ojando, E. S. (2023). Análisis de la autopercepción de la competencia digital docente en la formación inicial de maestros y maestras. Revista de Investigación Educativa, 41(1), 51-67. https://doi.org/10.6018/rie.501151) y en la correcta inclusión formativo-educativa de los recursos digitales (Gómez-Trigueros, 2023Gómez-Trigueros, I. M. (2023). Digital skills and ethical knowledge of teachers with TPACK in higher education. Contemporary Educational Technology, 15(2), ep406. https://doi.org/10.30935/cedtech/12874 ). En los años ochenta del siglo XX, las investigaciones pedagógicas confirmaron qué conocimientos debe poseer un docente para llevar a cabo su tarea educativa. Shulman (1986Shulman, L.S. (1986). Those who understand: knowledge growth in teaching. Educational Researcher, 15(2), 4-14. https://www.jstor.org/stable/1175860) acuña la denominación de “conocimiento base del docente” (CBD) para referirse a un cambio paradigmático sobre los pilares en los que se asienta la formación del profesorado. Habla así de la importancia en una adecuada formación disciplinar (conocimiento de la materia que el docente debe transmitir) combinada con una correcta preparación pedagógico-didáctica (conocimiento en la gestión del aula, en la aplicación de la transposición didáctica, en el conocimiento sobre el desarrollo del proceso cognitivo del alumnado, etc.). Esta propuesta de Shulman ha sido válida hasta el desarrollo masivo de la SIC cuando los recursos tecnológicos pasan a ser un “conocimiento” más que debe formar parte de la carrera del docente. En respuesta a estas nuevas necesidades en la formación del profesorado, Mishra y Koehler (2006Mishra, P. y Koehler, M. J. (2006). Technological Pedagogical Content Knowledge: A Framework for Teacher Knowledge. Teachers College Record, 108(6), 1017-1054. https://doi.org/10.1111/j.1467-9620.2006.00684.x ) desarrollan el modelo de enseñanza y aprendizaje Technological Pedagogical Content Knowledge (TPACK) (en español “conocimiento técnico pedagógico del contenido” o CTPC). Este modelo viene a ser una respuesta ante la ausencia de una teoría que sea capaz de guiar la correcta integración de la tecnología en la educación.

TPACK o CTPC se representa como una extensión de la caracterización del conocimiento base del docente (Shulman, 1986Shulman, L.S. (1986). Those who understand: knowledge growth in teaching. Educational Researcher, 15(2), 4-14. https://www.jstor.org/stable/1175860) para enseñar contenido específico con tecnología (Mishra y Koehler, 2006Mishra, P. y Koehler, M. J. (2006). Technological Pedagogical Content Knowledge: A Framework for Teacher Knowledge. Teachers College Record, 108(6), 1017-1054. https://doi.org/10.1111/j.1467-9620.2006.00684.x ). El modelo TPACK destaca tres conocimientos clave: el conocimiento de la tecnología (TK), sobre herramientas específicas, software y hardware; el conocimiento pedagógico (PK), sobre cómo administrar, instruir y guiar a los estudiantes; y el conocimiento disciplinar (CK), sobre la materia en la que se va a instruir al alumnado. Estos tres conocimientos se unen para la comprensión del conocimiento pedagógico tecnológico (TPK), relativo a la relación entre las tecnologías y las prácticas pedagógicas; el conocimiento del contenido pedagógico (PCK), sobre las prácticas pedagógicas y los objetivos de aprendizaje; y el conocimiento del contenido tecnológico, sobre los recursos digitales y los objetivos de aprendizaje (TCK). TPACK (CTPC) comprende la intersección de los contenidos TPK, PCK y TCK como parte de la compleja relación de todas las áreas constitutivas del conocimiento, que conforman el contexto en el que actúan los y las docentes (Schmidt et al., 2009Schmidt, D. A., Baran, E., Thompson, A. D., Mishra, P., Koehler, M. J. y Shin, T. S. (2009). Technological pedagogical content knowledge (TPACK): the development and validation of an assessment instrument for preservice teachers. Journal of Research on Technology in Education, 42(2), 123-149. https://doi.org/10.1080/15391523.2009.10782544 ; Gómez-Trigueros y Yáñez, 2021Gómez-Trigueros, I. M. y Yáñez, C. (2021). The digital gender gap in teacher education: The TPACK framework for the 21.st century. European Journal of Investigation in Health. Psychology and Education, 11(4), 1333-1349. https://doi.org/10.3390/ejihpe11040097 ).

La brecha digital de género en el profesorado novel

Al mismo tiempo, y como resultado de la incorporación de las tecnologías a todos los ámbitos de la vida (UNESCO, 2019UNESCO (2019). Rationales and recommendations for gender-equal digital skills education. https://unesdoc.unesco.org/ark:/48223/pf0000367416/PDF/367416eng.pdf.multi ), las brechas digitales comienzan a profundizarse entre determinados colectivos. De esto modo, surge el concepto de segunda brecha digital o brecha digital de género (Martínez-Cantos y Castaño, 2017Martínez-Cantos, J. L. y Castaño, C. (2017). La brecha digital de género y la escasez de mujeres en las profesiones TIC. Panorama Social, 25, 49-65. https://www.funcas.es/wp-content/uploads/Migracion/Articulos/FUNCAS_PS/025art05.pdf ), que centraliza los usos y habilidades diferenciadores de las tecnologías por género (Robles et al., 2016Robles, J. M., Antino, M., De Marco, S. y Lobera, J. A. (2016). La nueva frontera de la desigualdad digital: la brecha participativa. Revista Española de Investigaciones Sociológicas, 156, 97-116. http:s//www.reis.cis.es/REIS/PDF/REIS_156_061475836475882.pdf ) y que afirma que las mujeres reconocen tener menos habilidades que los hombres infravalorándose por ello, mientras que estos últimos sobrevaloran sus habilidades (Fernández y Ibáñez, 2018Fernández, A. B. y Ibáñez, M. (2018). Más mujeres en los estudios de Informática una propuesta desde el departamento de formación y orientación laboral. Revista de Sociología de la Educación (RASE), 11(1), 116-134. https://dx.doi.org/10.7203/RASE.11.1.10624 ). Inicialmente, las investigaciones relativas a este concepto comenzaron estudiando las posibilidades de acceso de mujeres y de hombres a las tecnologías de información y comunicación (TIC), cuestión que hoy día casi podría considerarse superada y totalmente equilibrada, gracias, en parte, al abundante y fructífero desarrollo legislativo producido en materia de igualdad (Fernández y Ibáñez, 2018Fernández, A. B. y Ibáñez, M. (2018). Más mujeres en los estudios de Informática una propuesta desde el departamento de formación y orientación laboral. Revista de Sociología de la Educación (RASE), 11(1), 116-134. https://dx.doi.org/10.7203/RASE.11.1.10624 ).

Sin embargo, son cada vez más estudios los que invitan a considerar la brecha digital de género como un problema de enorme importancia junto con el “acceso a” y “uso” de las TIC (Yelland y Rubin, 2002Yelland, N. y Rubin, A. (eds.) (2002). Ghosts in the Machine: Women’s Voices in Research with Technology. Peter Lang Publishing.) o de desarrollo de habilidades informáticas básicas. Las investigaciones más recientes señalan que dichas desigualdades no se refieren tanto a la presencia (acceso a las TIC) como a la intervención (manejo, uso, actitud, existencia de contenidos en las TIC) de las mujeres en este campo y, de manera concreta, a la capacitación docente para transferir su formación a la ciudadanía del siglo XXI. En esta línea, a pesar de la existencia del modelo TPACK (CTPC), los estudios científicos señalan como necesidad la mejora de la formación tecnológica del profesorado novel en el ámbito didáctico. Esto pasa por el desarrollo de la competencia digital entre los estudiantes de las facultades de educación, futuros docentes (Marimon-Martí et al., 2023Marimon-Martí, M., Romeu, T., Usart, M., y Ojando, E. S. (2023). Análisis de la autopercepción de la competencia digital docente en la formación inicial de maestros y maestras. Revista de Investigación Educativa, 41(1), 51-67. https://doi.org/10.6018/rie.501151). Para ello, y a partir del modelo de Mishra y Koehler, surge la necesidad de confeccionar un cuestionario para el contexto español, que permita medir, de manera adecuada, la autopercepción de los docentes, mujeres y hombres, en formación en relación con su competencia digital docente y conocer la persistencia o no de la brecha digital de género en este colectivo.

En este contexto, ante las preguntas que surgen, se plantea la importancia de contar con un instrumento fiable y validado, que dé respuesta a los siguientes interrogantes:

- ¿Qué autopercepción tiene el profesorado en formación sobre su competencia digital docente?

- ¿Persiste la brecha digital de género entre el profesorado en formación de las facultades de educación españolas?

De este modo, se marcan dos objetivos centrales en esta investigación:

- Ob1: Validar el instrumento TPACK-DGG como una escala correcta para medir la autopercepción en competencias digitales docentes y la brecha digital de género.

- Ob2: Analizar las percepciones en la autoeficacia del modelo TPACK-DGG en los futuros docentes en formación, estudiantes del Grado de Maestra/o de Primaria y del Máster de Formación del Profesorado de facultades españolas.

La intención es proporcionar un instrumento y validarlo, para extraer información real relativa a la autopercepción de la competencia digital del profesorado en formación en el contexto de las facultades de educación españolas y que pueda medir la brecha digital de género en ese mismo contexto.

Método

Descripción del contexto y de los participantes

La muestra participante está compuesta por 1.059 estudiantes universitarios de Grado en Educación Primaria y Máster del Profesorado de la Facultad de Educación de una universidad de la Comunidad Valenciana a lo largo de dos cursos académicos (2020-2021 y 2021-2022). La selección se realizó mediante un muestreo intencional o de conveniencia, de acuerdo con las posibilidades de acceso del equipo investigador al campo de estudio y en función de su grado de adecuación a los objetivos del proyecto de investigación. Con relación al género, los y las participantes se distribuyen en 836 (79%) mujeres y 223 hombres (21%) con edades comprendidas entre los 18 años y más de 40 años. Con un margen de error del 5% y un nivel de confianza del 95%, la muestra se considera significativa con respecto a la población total de la que procede (N=1700) (Otzen y Manterola, 2017Otzen, T. y Manterola, C. (2017). Técnicas de muestreo sobre una población a estudio. International Journal of Morphology, 35(1), 227-232. https://doi.org/10.4067/s0717-95022017000100037 ) (tabla 1).

| Tabla 1. Características sociodemográficas de la muestra |

|

Estudios

|

Género

|

Grupos de edad

|

|

Grado Educación Primaria

|

Máster del Profesorado

|

|

18-20 años

|

21-23 años

|

24 años o más

|

Total

|

|

724

|

112

|

M

|

386

|

319

|

131

|

836

|

|

112

|

111

|

H

|

98

|

13

|

112

|

223

|

|

Total

|

836

|

223

|

Total

|

484

|

332

|

243

|

1.059

|

| M=mujeres; H=hombres. Fuente: elaboración propia. |

|

Instrumento

Para la recolección de datos, se utilizó como referencia el modelo TPACK, seleccionando el cuestionario autoinformado, confeccionado para la investigación (GV/2021/077). Este instrumento está formado por de 32 ítems medidos en escala Likert de cinco puntos (1. Muy en desacuerdo; 2. En desacuerdo; 3. Ni de acuerdo, ni en desacuerdo; 4. De acuerdo; 5. Totalmente de acuerdo) distribuidos en 7 bloques dimensionales o dominios TPACK-DGG (http://hdl.handle.net/10045/132518 y anexo):

- TK-Conocimiento Tecnológico (4 ítems).

- CK-Conocimiento de Contenido (4 ítems).

- PK-Conocimiento Pedagógico (7 ítems).

- PCK-Conocimiento de Contenido Pedagógico (3 ítems).

- TCK- Conocimiento de Contenido Tecnológico (3 ítems).

- TPK-Conocimiento Pedagógico Tecnológico (9 ítems).

- TPACK-Conocimiento Pedagógico Tecnológico de Contenido (2 ítems).

Con la intención de determinar la bondad, estructura y estabilidad del instrumento, se realizaron pruebas de validez y fiabilidad mediante la aplicación de alfa de Cronbach a partir del modelo TPACK e intervalos de confianza con el programa estadístico SPSS en su versión 26 (v26).

Procedimiento

El procedimiento que se ha seguido para poder alcanzar un instrumento fiable consta de diferentes fases. Cabe señalar que estas fases parten de una concreción metodológica que, a partir del estudio exploratorio, ha permitido confeccionar los criterios generales de análisis que posibilitan llevar a cabo una evaluación completa y coordinada de cada uno de los grupos que conforman la muestra del estudio. El instrumento, por tanto, pretende medir la autopercepción de la muestra participante de las diferentes dimensiones del modelo TPACK y la afectación de dicha autopercepción en función del género.

En primer lugar, se configuró el cuestionario ad hoc para el Proyecto del Grupo Emergente (GV/2021/077), a partir de las aportaciones de Mishra y Koelher (2006Mishra, P. y Koehler, M. J. (2006). Technological Pedagogical Content Knowledge: A Framework for Teacher Knowledge. Teachers College Record, 108(6), 1017-1054. https://doi.org/10.1111/j.1467-9620.2006.00684.x ); Schmidt et al. (2009Schmidt, D. A., Baran, E., Thompson, A. D., Mishra, P., Koehler, M. J. y Shin, T. S. (2009). Technological pedagogical content knowledge (TPACK): the development and validation of an assessment instrument for preservice teachers. Journal of Research on Technology in Education, 42(2), 123-149. https://doi.org/10.1080/15391523.2009.10782544 ) y Gómez-Trigueros (2015Gómez, I. M. (2015). Proyecto a partir del modelo TPACK para desarrollar el aprendizaje de la Geografía en los estudios de Grado de Educación Primaria (Tesis doctoral, Universidad de Alicante).), adaptándolo a la investigación y a sus objetivos. Una vez configurado el instrumento se llevó a cabo una evaluación a través del procedimiento panel de expertos, con la intención de mejorar su eficacia y relevancia. El panel de validación estuvo compuesto por diferentes categorías profesionales, áreas de conocimiento y lugares de trabajo (tabla 2).

| Tabla 2. Características profesionales del Grupo de Expertos |

|

Categoría profesional

|

Área de conocimiento

|

Universidad

|

|

Catedrática de universidad

|

Didáctica y Organización Escolar

|

Universidad Oporto (Portugal)

|

|

Profesora titular de universidad

|

Deputy Head Higher Education and Engagement

|

School of Education, RMIT University (Australia)

|

|

Profesora titular de universidad

|

Deputy Head Higher Education and Engagement

|

School of Education, RMIT University (Australia)

|

|

Profesor titular de universidad

|

Didáctica y Organización Escolar

|

Universidad CUJAE (Cuba)

|

|

Profesora titular de universidad

|

Pedagogía Educativa

|

Universidad CUJAE (Cuba)

|

|

Profesora titular de universidad

|

Pedagogía Educativa

|

Universidad Bolivariana del Ecuador (UBE) (Ecuador)

|

|

Profesora titular de universidad

|

Didáctica de las Ciencias Sociales

|

Universidad de Alicante

|

|

Profesor titular de universidad

|

Didáctica y Organización Escolar

|

Universidad Oporto (Portugal)

|

|

Profesor titular de universidad

|

Didáctica de las Ciencias Sociales

|

Universidad de les Illes Balears

|

|

Profesora titular de universidad

|

Didáctica de la Ciencias Sociales

|

Universidad de Andorra (Andorra)

|

|

Profesora contratada doctora

|

Didáctica de la Lengua y la Literatura

|

Universidad de Almería

|

|

Profesor contratada doctor

|

Didáctica de la Ciencias Sociales

|

Universidad de Salamanca

|

|

Profesora contratada doctora

|

Investigación e Innovación Educativa

|

Universidad de Alicante

|

|

Profesor contratado doctor

|

Didáctica de las Ciencias Sociales

|

Universidad de Madrid

|

|

Profesor contratado doctor

|

Didáctica de la Ciencias Sociales

|

Universidad CUJAE (Cuba)

|

|

Profesora Ayudante doctora

|

Investigación e Innovación Educativa

|

Universidad de Alicante

|

|

Profesor contratado doctor

|

Didáctica de las Ciencias Sociales

|

Universidad de Burgos

|

|

Profesor contratado doctor

|

Pedagogía Educativa

|

Universidad Bolivariana del Ecuador UBE (Ecuador)

|

| Fuente: elaboración propia. |

|

A través de correo electrónico, se hizo llegar la siguiente información a cada miembro del panel de expertos: a) los objetivos de la investigación; b) qué miembros investigadores conforman el equipo investigador; c) el contexto de implementación del instrumento y la investigación; d) la duración del proyecto de investigación; e) el cuestionario inicial, confeccionado por el equipo de trabajo. Asimismo, a través de un Google formulario, se les propusieron diversas fechas para la realización de dos reuniones virtuales, de coordinación, a través de Google Meet. En este sentido, se llevaron a cabo dos reuniones virtuales en los meses de enero y febrero de 2019. Se modificaron y adaptaron algunos ítems y se alcanzó un consenso final. Para ello se utilizó el método Delphi (Landeta, 1999). El panel de expertos (tabla 2) emitió sus juicios, en una escala de intervalo de 5 puntos, sobre la pertinencia y adecuación, la coherencia interna y la importancia de las cuestiones que pretendían formularse, y su valoración general del constructo en una escala de 1 a 10 puntos. Tras administrar el instrumento de evaluación en dos rondas, se obtuvieron las respuestas del grupo de expertas y expertos. Los resultados finales obtenidos arrojan una media superior a 9 en la valoración general del cuestionario y una baja dispersión de las respuestas sobre la pertinencia y adecuación (M = 9.5; SD = 0.14) y la coherencia interna del instrumento (M = 9.8; SD = 0.20). De igual forma, se obtuvo un valor de general en la fiabilidad y consistencia interna del total de la escala (α = 0.956). Cabe señalar que las cuestiones relativas a la adecuación del cuestionario a los objetivos de la investigación obtuvieron un valor superior a 0.9 (α = 0.909).

Posteriormente, se procedido a un proceso de revalidación del instrumento consistente en una prueba piloto o pretest cognitivo, a partir de la distribución de un borrador elaborado por el equipo investigador, teniendo en cuenta las indicaciones del panel de expertos. La muestra utilizada para dicha revalidación fue de 214 sujetos, estudiantes de Grado en Primaria y de Máster del Profesorado a lo largo del curso académico 2020-2021 (meses de septiembre y noviembre). Se informó a cada participante sobre los objetivos del estudio; el uso de datos con fines exclusivamente investigativos; la persona encargada del estudio, así como el correo electrónico de dicha persona responsable para, en caso de duda, poder ponerse en contacto con ella. Una vez leída esta información, el alumnado participante emitió su consentimiento a través de una carta informada. Los participantes valoraron el cuestionario a través de la plataforma gratuita Google Formularios (https://forms.gle/WrhSy9TRAvTJU8bJ7), remitido a través de correo electrónico. Al igual que con el panel de expertos, los sujetos estudiantes participantes valoraron los ítems del instrumento teniendo en cuenta tres bloques de análisis: a) comprensión del enunciado y de los términos utilizados; b) su rechazo o aceptación ante las cuestiones planteadas; c) y la adecuación en su extensión. Para ello, utilizaron una escala de intervalo de 3 puntos. En los tres bloques analizados, los resultados de media fueron superiores a 2.5 en la calificación general del cuestionario. De manera concreta, se valoró con una media de 2.7 la comprensión de las preguntas y los términos utilizados (M=2.7; SD=0.16); con una media de 2.6 la aceptación respecto a las cuestiones planteadas (M=2.6; SD=0.20); y con una media de 2.3 la adecuación respecto a la extensión del instrumento (M=2.3; SD=0.25).

Con posterioridad a esta fase del proceso, se realizaron análisis para la validación del cuestionario. Estos análisis están reflejados en el apartado 2.4. de este documento.

Previo a la implementación del cuestionario, se solicitó su aprobación por el Comité de Ética Universidad de Alicante que emitió su informe positivo (Alicante-Expediente UA-2021-08-27).

Finalmente, se distribuyó el cuestionario entre los estudiantes, muestra participante (tabla 1) a lo largo de los cursos académicos 2020-2021 y 2021-2022; el cuestionario se aplicó del mismo modo que la prueba piloto experimental, a través de un correo electrónico a sus e-mails institucionales, donde se desarrolló la investigación. En dicho correo, y siguiendo las indicaciones del Comité de Ética de la universidad, se informó de los objetivos y del anonimato de sus respuestas, así como del uso de los datos obtenidos con su participación.

Análisis estadísticos y validación del instrumento

A partir de los resultados, se implementó el análisis factorial exploratorio (AFE) para los ítems de la escala, calculando el ajuste de los datos previamente a través de la medida de Kaiser-Meyer-Olkin (KMO) de adecuación muestral y el test de esfericidad de Bartlett (Cerny y Kaiser, 2010Cerny, B. y Kaiser, H. (2010). A Study of a Measure of Sampling Adequacy for Factor-Analytic Correlation Matrices. Multivariate Behavioral Research, 12(1), 43-47. https://doi.org/10.1207/s15327906mbr1201_3). Se implementó una reducción de ítems hasta la perfecta factorización (Seçer, 2013Seçer, İ. (2013). SPSS ve LISREL ile pratik veri analizi ve raporlaştırma. Turquía. Anı Yayıncılık. https://aniyayincilik.com.tr/public/assets/catalogs/0527333001533121850.pdf ), adoptando, para la eliminación de las cuestiones, el poco efecto de la carga del ítem sobre el factor o su ubicación en dos factores; se elaboró un análisis factorial confirmatorio (AFC), para la contrastación definitiva del modelo y la aplicación de diferentes índices de adaptación para la contratación de la adecuación del modelo (Kline, 2005Kline, R. (2005). Principles and practice of structural equation modelling. The Guilford Press.) y comprobar si los resultados se ajustaban a la respuesta dada por el AFE. Para ello, se ha utilizado la estimación por máxima verosimilitud (sus siglas en inglés ML) (Ryu, 2011Ryu, E. (2011). Effects of skewness and kurtosis on normal-theory based maximum likelihood test statistic in multilevel structural equation modelling. Behavior Research Methods, 43(4), 1066-1074. https://doi.org//10.3758/s13428-011-0115-7 ) teniendo en cuenta el tamaño de muestra (Bentler, 1989). El valor significativo obtenido permite aceptar la hipótesis nula (p >0.05) confirmando que el instrumento propuesto es adecuado (Cea, 2004Cea, M. A. (2004). Análisis multivariable. Teoría y práctica en la investigación social. Síntesis.). Estos valores se complementan con otros índices de bondad de ajuste tales como el índice RMSEA (Root Mean Square Error of Approximation) o error cuadrático medio de aproximación por grado de libertad. Los valores recomendados, indicativos de un buen ajuste en RMSEA, deben ser <0.05 y entre 0.05 y 0.08 como razonables (Cea, 2004Cea, M. A. (2004). Análisis multivariable. Teoría y práctica en la investigación social. Síntesis.). El valor de RMSEA en esta investigación fue de 0.062, que está dentro de lo aceptable en cualquiera de los casos. Además, y con la intención de eliminar dudas sobre el ajuste del instrumento a los datos, se ha hallado el índice de ajuste comparativo (siglas en inglés CFI de Comparative Fit Index). Se considera que el CFI se ajusta adecuadamente cuanto se aproxima al valor 0.95 (Bentler, 1992). El valor inicial de CFI en el estudio fue 0.961, que alcanza el valor mínimo aconsejado. Los resultados obtenidos en el ajuste absoluto (RMSEA) y en los comparativos generales (CFI y TLI) se consideran satisfactorios (Loehlin y Beaujean, 2017Loehlin, J. C. y Beaujean, A. A. (2017). Latent Variable Models: An Introduction to Factor, Path and Structural Equation Analysis. Routledge Taylor y Francis Group.). Otro de los índices de ajuste en el AFC fue el chi-cuadrado (χ2) y el chi-cuadrado normalizado (χ2/df). Para el primer estadístico se obtuvo un valor significativo (χ2= 214.059, p <0.001) y, para el segundo estadístico el valor se encontraba por debajo del nivel o corte recomendado que es 3.0 (χ2/df = 2.18) (tabla 3).

| Tabla 3. Índices de ajuste absoluto y ajuste comparativo de la escala TPACK-DGG |

|

Índice de ajuste

|

Valor

|

|

RMSEA

|

0.062

|

|

CFI

|

0.961

|

|

TLI

|

0.959

|

|

χ2/df

|

2.18

|

|

χ2

|

214.059

|

| Fuente: elaboración propia. |

|

Para confirmar la fiabilidad y la consistencia interna de los factores, se aplicó la prueba de alpha de Cronbach (α). El proceso seguido fue calcular el indicador de fiabilidad compuesta (FC). Los resultados obtenidos se consideran muy aceptables para el tipo de estudio (Hernández et al., 2010Hernández, R., Fernández, C. y Baptista, M. P. (2010). Metodología de la investigación. McGraw-Hill Educación. ; Cho, 2016Cho, E. (2016). Making Reliability Reliable: A Systematic Approach to Reliability Coefficients. Organizational Research Methods, 19(4), 651-682. https://doi.org/10.1177/1094428116656239) con valores que superan el registro 0.70 para todas las dimensiones del instrumento (tabla 4). Posteriormente, para analizar la validez convergente de los factores que componen el instrumento se ha hallado la varianza media extraía (AVE). El valor de AVE mostró evidencias de validez convergente con valores por encima de 0.50 (tabla 4).

| Tabla 4. Fiabilidad de la escala TPACK-DGG |

|

Dimensiones

|

α

|

FC

|

AVE

|

|

TK

|

0.893

|

0.896

|

0.684

|

|

CK

|

0.891

|

0.894

|

0.647

|

|

PK

|

0.883

|

0.887

|

0.646

|

|

PCK

|

0.8.76

|

0.880

|

0.638

|

|

TCK

|

0.870

|

0.878

|

0.647

|

|

TPK

|

0.869

|

0.871

|

0.654

|

|

TPACK

|

0.874

|

0.877

|

0.661

|

| Fuente: elaboración propia. |

|

El instrumento de esta investigación quedó conformado por 32 ítems, organizados en las siete dimensiones que analiza el modelo de enseñanza y aprendizaje (E-A) TPACK-DGG. La distribución de cada una de las dimensiones queda constatada en el anexo de este trabajo donde se presenta el instrumento definitivo, validado (http://hdl.handle.net/10045/132518 y anexo).

Resultados análisis de datos

En primer lugar, se implementó un análisis descriptivo para hallar la media (M) y desviación estándar (SD) de cada una de las variables del cuestionario y de sus siete dimensiones. Este análisis se realizó diferenciando las respuestas emitidas según género de las y los participantes (tabla 5).

En segundo lugar, se realizó la prueba de Kolmogorov-Smirnov. Los resultados del estadístico probaron la normalidad esperada en las variables que conforman el constructo (p ≥0.05). Para poder implementar estadísticos paramétricos, también se identificó la normalidad en las diferentes variables de estudio, dimensiones y agrupaciones por género.

| Tabla 5. Descriptivos, prueba t de muestras independientes basada en el género |

|

D.

|

V.

|

Género

|

Prueba t

|

Δ Cohen

|

|

Hombres

|

Mujeres

|

t

|

p

|

|

M

|

SD

|

M

|

SD

|

|

D.1 (TK)

|

TK1

|

4.21

|

0.61

|

3.88

|

0.80

|

8.052

|

.000

|

0.501

|

|

TK2

|

4.26

|

0.60

|

3.93

|

0.78

|

5.957

|

.000

|

0.402

|

|

TK3

|

4.32

|

0.57

|

3.99

|

0.77

|

5.403

|

.000

|

0.421

|

|

TK4

|

4.22

|

0.55

|

3.90

|

0.80

|

5.626

|

.000

|

0.542

|

|

D. 2 (CK)

|

CK1

|

4.35

|

0.64

|

3.88

|

0.79

|

4.062

|

.000

|

0.538

|

|

CK2

|

4.26

|

0.67

|

3.90

|

0.78

|

6.363

|

.000

|

0.417

|

|

CK3

|

4.28

|

0.69

|

3.95

|

0.69

|

5.884

|

.000

|

0.428

|

|

CK4

|

4.25

|

0.58

|

3.90

|

0.70

|

7.933

|

.000

|

0.443

|

|

D. 3 (PK)

|

PK1

|

4.25

|

0.62

|

3.93

|

0.79

|

5.644

|

.000

|

0.529

|

|

PK2

|

4.32

|

0.64

|

3.90

|

0.77

|

3.682

|

.000

|

0.410

|

|

PK3

|

4.29

|

0.66

|

3.91

|

0.69

|

6.606

|

.000

|

0.498

|

|

PK4

|

4.29

|

0.67

|

3.88

|

0.68

|

7.308

|

.000

|

0.407

|

|

PK5

|

4.39

|

0.66

|

3.87

|

0.64

|

2.875

|

.004

|

0.542

|

|

PK6

|

4.27

|

0.65

|

3.94

|

0.78

|

6.017

|

.000

|

0.503

|

|

PK7

|

4.28

|

0.59

|

3.89

|

0.77

|

7.618

|

.000

|

0.422

|

|

D. 4 (PCK)

|

PCK1

|

4.28

|

0.50

|

3.83

|

0.80

|

6.853

|

.000

|

0.631

|

|

PCK2

|

4.23

|

0.48

|

3.86

|

0.77

|

7.494

|

.000

|

0.590

|

|

PCK3

|

4.23

|

0.50

|

3.88

|

0.78

|

7.292

|

.000

|

0.601

|

|

D. 5 (TCK)

|

TCK1

|

4.27

|

0.54

|

3.88

|

0.79

|

7.749

|

.000

|

0.623

|

|

TCK2

|

4.28

|

0.51

|

3.89

|

0.76

|

4.342

|

.000

|

0.441

|

|

TCK3

|

4.31

|

0.52

|

3.79

|

0.78

|

3.586

|

.000

|

0.459

|

|

D. 6 (TPK)

|

TPK1

|

4.18

|

0.60

|

3.91

|

0.75

|

5.192

|

.000

|

0.562

|

|

TPK2

|

4.28

|

0.58

|

3.94

|

0.73

|

3.089

|

.002

|

0.501

|

|

TPK3

|

4.20

|

0.57

|

3.93

|

0.71

|

5.094

|

.000

|

0.552

|

|

TPK4

|

4.21

|

0.60

|

3.99

|

0.76

|

4.251

|

.000

|

0.498

|

|

TPK5

|

4.27

|

0.54

|

4.01

|

0.72

|

4.841

|

.000

|

0.464

|

|

TPK6

|

4.20

|

0.60

|

3.97

|

0.69

|

4.411

|

.000

|

0.507

|

|

D. 6 (TPK)

|

TPK7

|

4.26

|

0.59

|

3.96

|

0.70

|

2.716

|

.007

|

0.518

|

|

TPK8

|

4.21

|

0.53

|

3.97

|

0.74

|

4.616

|

.000

|

0.546

|

|

TPK9

|

4.29

|

0.54

|

4.04

|

0.73

|

4.853

|

.001

|

0.560

|

|

D. 7 (TPACK)

|

TPACK1

|

4.01

|

0.50

|

3.77

|

0.78

|

2.494

|

.001

|

0.701

|

|

TPACK2

|

4.12

|

0.48

|

3.76

|

0.70

|

4.592

|

.000

|

0.700

|

| D.=dimensión; V.=variable; M=media; SD=desviación estándar; Δ Cohen=D de Cohen. Fuente: elaboración propia. |

|

Se comprobó la homogeneidad de las varianzas en 30 de los 32 ítems del instrumento. Al cumplirse todas las condiciones para la implementación de estadísticas paramétricas (distribución normal, homogeneidad de las varianzas en la mayoría de los ítems y muestra mayor de 30 por grupo, representativa de la población de estudio), se realizó la prueba t para muestras independientes. Esta prueba se utiliza cuando se desea comparar las puntuaciones de dos grupos distintos, como es el caso, en función del género (dos grupos: el primero “hombre” y el segundo “mujer”). De igual forma, para valorar el efecto de las variables categóricas de género sobre el modelo dimensional TPACK-DGG se realizó la prueba t, basada en esta misma variable categórica género (tabla 5).

Los resultados indican que sí existen diferencias significativas entre las respuestas emitidas por las mujeres y por los hombres participantes en la investigación en los valores analizados (tabla 5). Con un nivel de significación de p >0.05, la prueba t para muestras independientes constata la existencia de diferencias estadísticamente significativas en cada una de las siete dimensiones del constructo analizadas, con una significación en todas inferior a 0.05 (ítem 1-32 p ≥0.05). Estudiando los valores descriptivos (M y SD) se comprueba que la opción de respuesta de los hombres es, en todos los casos 4. De acuerdo o próxima a 5. Totalmente de acuerdo en los ítems del constructo. En contraposición, las respuestas emitidas por las mujeres participantes es valor 3. Ni de acuerdo ni en desacuerdo. Solo en el caso de dos variables relativa a la dimensión TPK, la opción de respuesta de las participantes mujeres es “De acuerdo” (opción 4 de la escala Likert) (TPK5 M=4.01; TPK9 M=4.04).

Estas diferencias generales por género se sitúan a favor (son más altos) en las respuestas emitidas por los hombres como se observa en los valores descriptivos de media (M). Se trata, por tanto, de diferencias estadísticamente significativas entre mujeres y hombres, de los valores obtenidos en la autopercepción en los dominios TPACK de la muestra.

Finalmente, los análisis se completan con los tamaños del efecto de las variables analizadas a través del estadístico D de Cohen (Δ Cohen). En todas las variables se confirma un tamaño del efecto del género mediano o grande ya que los valores obtenidos oscilan entre 0.4 y 0.7 (Cohen, 1988Cohen, J. (1988). Statistical power analysis for the behavioral sciences. Lawrence Erlbaum Associates.) (tabla 5).

Discusión y conclusiones

Como ya se ha significado al inicio de esta investigación, la sociedad de la información y el conocimiento (SIC) presente solicita modificaciones en la formación del profesorado, relativos a la competencia digital docente. De la mano de estos requerimientos formativos, la brecha digital de género se percibe como un obstáculo para la consecución, por ejemplo, de los Objetivos de Desarrollo Sostenible (ODS) y una debilitación del desarrollo humano (ONU, 2019ONU (2019). Puesta en práctica de la educación para el desarrollo sostenible en el marco de la Agenda 2030 para el Desarrollo Sostenible. A/74/258. https://unesdoc.unesco.org/ark:/48223/pf0000374896). La necesidad de formar en competencias digitales a la ciudadanía precisa de esa preparación del profesorado, motor de la educación. En este sentido, el instrumento confeccionado para la investigación del Grupo Emergente, al amparo de la Conselleria d’Educació de la Generalitat Valenciana (GV/2021/077) ofrece resultados validados psicométricamente y fiables, que permiten confirmar su valor como recurso para dar respuesta a las cuestiones y a los objetivos planteados.

De manera concreta, en respuesta al primer interrogante de la investigación, el instrumento TPACK-DGG permite observar diferencias entre mujeres y hombre, en relación con la autopercepción en competencias digitales del profesorado en formación. Los resultados confirman que la autopercepción en las siete dimensiones analizas (CK, TK, PK, TCK, TPK, PCK, TPACK) es más positiva entre los participantes hombres que entre las participantes mujeres. Estos datos coinciden con los resultados obtenidos en otras investigaciones (Ibrohim et al., 2022Ibrohim, I., Purwaningsih, E., Munzil, M., Hidayanto, E., Sudrajat, A., Saefi, M. y Hassan, Z. (2022). Possible links between Indonesian science teacher’s TPACK perception and demographic factors: Self-reported survey. Eurasia Journal of Mathematics, Science and Technology Education, 18(9), 2146. https://doi.org/10.29333/ejmste/12282 ) en donde los estudiantes hombres se autoperciben más capacitados para el uso de los recursos tecnológicos. En las dimensiones relativas al uso didáctico de los recursos digitales, se confirma dicha autovaloración y reconocimiento positivo o capacitación digital docente. Tales diferencias se antojan más evidentes y fuertes en la séptima dimensión (TPACK) como se observa en los resultados de la aplicación del constructo en el tamaño del efecto a favor de los hombres (≤0.7). También, en la dimensión relativa al conocimiento de contenido tecnológico (TCK), se observan mayores diferencias, a favor de los participantes masculinos, con mayor tamaño del efecto en las variables estudiadas. Estos resultados son coincidentes con los de otras investigaciones (Gebhardt et al., 2019Gebhardt, E., Thomson, S., Ainley, J. y Hillman, K. (2019). Gender differences in computer and information literacy. An In-depth analysis of data from ICILS. Springer. https://doi.org/10.1007/978-3-030-26203-7_1 ) en donde los puntajes de los hombres superan al de las mujeres, mostrando una autopercepción positiva o muy positiva en relación con sus competencias para manejar tecnologías como recursos educativos. Esto se traduce en una mayor implementación de las herramientas tecnológicas en las propuestas didácticas de los estudiantes hombres, que se consideran más diestros en su manejo y utilización como recurso educativo.

Estos mismos resultados vienen a confirmar el segundo de los interrogantes de este trabajo, evidenciando la presencia de brecha digital de género entre el profesorado en formación. Así, se observa que las futuras docentes mujeres muestran una autopercepción deficiente de su competencia digital (TK) y también de su competencia digital docente (TCK). Estos resultados son coherentes con los emitidos por otras investigaciones (Fernández y Ibáñez, 2018Fernández, A. B. y Ibáñez, M. (2018). Más mujeres en los estudios de Informática una propuesta desde el departamento de formación y orientación laboral. Revista de Sociología de la Educación (RASE), 11(1), 116-134. https://dx.doi.org/10.7203/RASE.11.1.10624 ; Pérez-Escoda et al., 2021Pérez-Escoda, A., Lena-Acebo, F. J. y García-Ruiz, R. (2021). Brecha digital de género y competencia digital entre estudiantes universitarios. Aula Abierta, 50(1), 505-5014. https://doi.org/10.17811/rifie.50.1.2021.505-5014) donde se señala la persistencia de la brecha digital por géneros, con una menor predisposición de las estudiantes mujeres hacia el uso de los recursos tecnológicos. También se constata que existe una escasa presencia en la autopercepción de las docentes en formación, de las dimensiones reconocidas como consustanciales a la competencia digital docente del profesorado (dimensiones TCK, TPACK y en la mayoría de los ítems de la dimensión TPK). Al respecto, informes como los del Observatorio Nacional de la Telecomunicaciones y de la Sociedad de la Información-ONTSI (2020Observatorio Nacional de la Telecomunicaciones y de la Sociedad de la Información-ONTSI. (2020). Dossier de Indicadores de la Sociedad Digital por género. https://www.ontsi.red.es/es/dossier-de-indicadores-pdf/Dossier-de-Indicadores-de-la-Sociedad-Digital-por-genero-%28marzo-2020%29), que analizan la participación de las mujeres con relación al perfeccionamiento en el uso de los recursos digitales, confirman la baja participación y el poco interés femenino conforme a su formación y a su perfeccionamiento en el uso de ciertos artefactos tecnológicos (Pérez-Escoda et al., 2020Pérez-Escoda, A., Iglesias-Rodríguez, A., Meléndez-Rodríguez, L. y Berrocal-Carvajal, V. (2020). Competencia digital docente para la reducción de la brecha digital: estudio comparativo de España y Costa Rica. Trípodos, 46, 77-96. http://www.tripodos.com/index.php/Facultat_Comunicacio_Blanquerna/article/download/790/809 ). De manera concreta, se detectan valoraciones negativas en la autopercepción de las futuras profesoras sobre su capacidad para seleccionar, evaluar y utilizar aquellas tecnologías digitales más adecuadas para el desarrollo de su futura tarea docente. Las causas de esta diferente percepción pueden deberse a razones de tipo sociocultural (tradicionalmente, se otorga una mayor destreza digital a los hombres) o, simplemente, actitudinal y diferencial entre hombres y mujeres. En cualquier caso, son resultados que confirmar la persistencia de la brecha digital de género en las futuras docentes, aspecto puesto de relieve en el proyecto del grupo de investigación del que forma parte este instrumento, por tratarse de una cuestión importante si se quiere atender la adecuada preparación de la ciudadanía del siglo XXI sin sesgos capacitantes por género.

En esta línea, otros estudios indican que la deficiente autopercepción frente a las herramientas digitales de las futuras docentes tiene su reflejo en las aulas de los niveles educativos de primaria y de secundaria, plasmándose como desinterés o infrautilización de las tecnologías; repercutiendo negativamente en el alumnado femenino, que pueden llegar a repetir esta forma de aproximación a los recursos digitales, y que pueden llegar a replicar una autopercepción negativa (Gómez-Trigueros y Yáñez, 2021Gómez-Trigueros, I. M. y Yáñez, C. (2021). The digital gender gap in teacher education: The TPACK framework for the 21.st century. European Journal of Investigation in Health. Psychology and Education, 11(4), 1333-1349. https://doi.org/10.3390/ejihpe11040097 ).

Todos estos datos vienen a constatar la enorme tarea pendiente, todavía, en la formación inicial del profesorado, evidenciando diferencias sustanciales en la percepción sobre la capacitación digital docente de mujeres y de hombres. Además, ponen de relieve la necesidad de incidir en la implementación de modelos de enseñanza y aprendizaje con tecnología, que permitan la adecuada preparación de los futuros docentes en el uso de tales herramientas y que mitigue la todavía existente brecha digital de género (ONTSI, 2020Observatorio Nacional de la Telecomunicaciones y de la Sociedad de la Información-ONTSI. (2020). Dossier de Indicadores de la Sociedad Digital por género. https://www.ontsi.red.es/es/dossier-de-indicadores-pdf/Dossier-de-Indicadores-de-la-Sociedad-Digital-por-genero-%28marzo-2020%29; Pérez-Escoda et al., 2021Pérez-Escoda, A., Lena-Acebo, F. J. y García-Ruiz, R. (2021). Brecha digital de género y competencia digital entre estudiantes universitarios. Aula Abierta, 50(1), 505-5014. https://doi.org/10.17811/rifie.50.1.2021.505-5014; Marimon-Martí et al., 2023Marimon-Martí, M., Romeu, T., Usart, M., y Ojando, E. S. (2023). Análisis de la autopercepción de la competencia digital docente en la formación inicial de maestros y maestras. Revista de Investigación Educativa, 41(1), 51-67. https://doi.org/10.6018/rie.501151). Los resultados de la investigación nos animan a recomendar la creación de contextos más propicios para las mujeres mediante la transmisión de modelos femeninos en el campo de la tecnología, así como la promoción de acciones formativas, dirigidas a mejorar los procesos de enseñanza-aprendizaje apoyados por las nuevas tecnologías entre el profesorado de las facultades de educación (Chinn y Vandegrift, 2008Chinn, D. y Vandegrift, T. (2008). Gender and diversity in hiring software professionals: What do students say? In Proceedings of the Fourth International Workshop on Computing Education Research, ICER’08 (pp. 39-50). Association for Computing Machinery. https://doi.org/10.1145/1404520.1404525 ; Gómez-Trigueros, 2023Gómez-Trigueros, I. M. (2023). Digital skills and ethical knowledge of teachers with TPACK in higher education. Contemporary Educational Technology, 15(2), ep406. https://doi.org/10.30935/cedtech/12874 ), teniendo en cuenta la importancia de qué modelos metodológicos son los predominantes y cómo se implementan en las aulas.

En relación con las limitaciones de la propuesta, hay que señalar que, aunque el tamaño de la muestra es potente (sobrepasa el 60% del universo total), es oportuno llevar a cabo la administración del cuestionario en otros contextos en los que ya se está trabajando esta problemática. De manera concreta, está previsto que, al amparo de la Cátedra de Brecha Digital de Género de la Universidad de Valencia, el instrumento presentado se distribuya en las universidades públicas de toda la Comunitat Valenciana. De igual forma, se ha propuesto su utilización en el contexto de otros proyectos de innovación educativa TECSOCO (UV-SFPIE_PID-2076286), que abarca investigadores de la Universidad de Valencia, Alicante y Valladolid. También, en el contexto del proyecto de investigación SIMONE (PID2021-122206NB-I00) dentro del Programa Estatal para Impulsar la Investigación Científico-Técnica y su Transferencia. Todas estas intervenciones reducirán la limitación de un estudio longitudinal pues permitirá obtener, en un futuro próximo, diferentes medidas temporales al constructo. De igual forma, la difusión a través de todos estos proyectos y grupos de investigación superará la limitación actual del contexto pues se implementará en diversas facultades de educación de toda España.

Agradecimientos

Esta investigación ha sido financiada por el proyecto de investigación “La brecha digital de género y el modelo TPACK en la formación del profesorado: análisis de la capacitación digital docente” (GV/2021/077) [Conselleria de Innovación, Universidades, Ciencia y Sociedad Digital de la Generalitat Valencia, y se enmarca en la convocatoria de subvenciones del Programa para la Promoción de la Investigación Científica, el Desarrollo Tecnológico y la Innovación en la Comunitat Valenciana para apoyar y fomentar la actividad de grupos de I+D+i emergentes (DOGV n.º 8959, 2021)].

Referencias bibliográficas

|

| ○ | Albalat, J. Q. (2000). Competencias en tecnologías de la información del profesorado de educación infantil y primaria. Revista Interuniversitaria de Tecnología Educativa, 166-174. |

| ○ | Cea, M. A. (2004). Análisis multivariable. Teoría y práctica en la investigación social. Síntesis. |

| ○ | Cerny, B. y Kaiser, H. (2010). A Study of a Measure of Sampling Adequacy for Factor-Analytic Correlation Matrices. Multivariate Behavioral Research, 12(1), 43-47. https://doi.org/10.1207/s15327906mbr1201_3 |

| ○ | Chinn, D. y Vandegrift, T. (2008). Gender and diversity in hiring software professionals: What do students say? In Proceedings of the Fourth International Workshop on Computing Education Research, ICER’08 (pp. 39-50). Association for Computing Machinery. https://doi.org/10.1145/1404520.1404525 |

| ○ | Cho, E. (2016). Making Reliability Reliable: A Systematic Approach to Reliability Coefficients. Organizational Research Methods, 19(4), 651-682. https://doi.org/10.1177/1094428116656239 |

| ○ | Cohen, J. (1988). Statistical power analysis for the behavioral sciences. Lawrence Erlbaum Associates. |

| ○ | Duart, J. M. y Sangrà, A. (2000). Aprender en la Virtualidad. Gedisa Editorial. |

| ○ | Fernández, A. B. y Ibáñez, M. (2018). Más mujeres en los estudios de Informática una propuesta desde el departamento de formación y orientación laboral. Revista de Sociología de la Educación (RASE), 11(1), 116-134. https://dx.doi.org/10.7203/RASE.11.1.10624 |

| ○ | Gebhardt, E., Thomson, S., Ainley, J. y Hillman, K. (2019). Gender differences in computer and information literacy. An In-depth analysis of data from ICILS. Springer. https://doi.org/10.1007/978-3-030-26203-7_1 |

| ○ | Gómez, I. M. (2015). Proyecto a partir del modelo TPACK para desarrollar el aprendizaje de la Geografía en los estudios de Grado de Educación Primaria (Tesis doctoral, Universidad de Alicante). |

| ○ | Gómez-Trigueros, I. M. (2023). Digital skills and ethical knowledge of teachers with TPACK in higher education. Contemporary Educational Technology, 15(2), ep406. https://doi.org/10.30935/cedtech/12874 |

| ○ | Gómez-Trigueros, I. M. y Yáñez, C. (2021). The digital gender gap in teacher education: The TPACK framework for the 21.st century. European Journal of Investigation in Health. Psychology and Education, 11(4), 1333-1349. https://doi.org/10.3390/ejihpe11040097 |

| ○ | Hernández, R., Fernández, C. y Baptista, M. P. (2010). Metodología de la investigación. McGraw-Hill Educación. |

| ○ | Ibrohim, I., Purwaningsih, E., Munzil, M., Hidayanto, E., Sudrajat, A., Saefi, M. y Hassan, Z. (2022). Possible links between Indonesian science teacher’s TPACK perception and demographic factors: Self-reported survey. Eurasia Journal of Mathematics, Science and Technology Education, 18(9), 2146. https://doi.org/10.29333/ejmste/12282 |

| ○ | Kline, R. (2005). Principles and practice of structural equation modelling. The Guilford Press. |

| ○ | Loehlin, J. C. y Beaujean, A. A. (2017). Latent Variable Models: An Introduction to Factor, Path and Structural Equation Analysis. Routledge Taylor y Francis Group. |

| ○ | Marimon-Martí, M., Romeu, T., Usart, M., y Ojando, E. S. (2023). Análisis de la autopercepción de la competencia digital docente en la formación inicial de maestros y maestras. Revista de Investigación Educativa, 41(1), 51-67. https://doi.org/10.6018/rie.501151 |

| ○ | Martínez-Cantos, J. L. y Castaño, C. (2017). La brecha digital de género y la escasez de mujeres en las profesiones TIC. Panorama Social, 25, 49-65. https://www.funcas.es/wp-content/uploads/Migracion/Articulos/FUNCAS_PS/025art05.pdf |

| ○ | Mishra, P. y Koehler, M. J. (2006). Technological Pedagogical Content Knowledge: A Framework for Teacher Knowledge. Teachers College Record, 108(6), 1017-1054. https://doi.org/10.1111/j.1467-9620.2006.00684.x |

| ○ | Observatorio Nacional de la Telecomunicaciones y de la Sociedad de la Información-ONTSI. (2020). Dossier de Indicadores de la Sociedad Digital por género. https://www.ontsi.red.es/es/dossier-de-indicadores-pdf/Dossier-de-Indicadores-de-la-Sociedad-Digital-por-genero-%28marzo-2020%29 |

| ○ | ONU (2019). Puesta en práctica de la educación para el desarrollo sostenible en el marco de la Agenda 2030 para el Desarrollo Sostenible. A/74/258. https://unesdoc.unesco.org/ark:/48223/pf0000374896 |

| ○ | Otzen, T. y Manterola, C. (2017). Técnicas de muestreo sobre una población a estudio. International Journal of Morphology, 35(1), 227-232. https://doi.org/10.4067/s0717-95022017000100037 |

| ○ | Pérez-Escoda, A., Iglesias-Rodríguez, A., Meléndez-Rodríguez, L. y Berrocal-Carvajal, V. (2020). Competencia digital docente para la reducción de la brecha digital: estudio comparativo de España y Costa Rica. Trípodos, 46, 77-96. http://www.tripodos.com/index.php/Facultat_Comunicacio_Blanquerna/article/download/790/809 |

| ○ | Pérez-Escoda, A., Lena-Acebo, F. J. y García-Ruiz, R. (2021). Brecha digital de género y competencia digital entre estudiantes universitarios. Aula Abierta, 50(1), 505-5014. https://doi.org/10.17811/rifie.50.1.2021.505-5014 |

| ○ | Prendes, M. P. y Gutiérrez, I. (2013). Competencias tecnológicas del profesorado en las universidades españolas. Revista de Educación, 361, 196-222. https://doi.org/10.4438/1988-592X-RE-2011-361-140 |

| ○ | Redecker, C. (2020). Marco Europeo para la Competencia Digital de los Educadores: DigCompEdu (trad. Fundación Universia y Ministerio de Educación y Formación Profesional de España). Secretaría General Técnica del Ministerio de Educación y Formación Profesional de España (original publicado en 2017). |

| ○ | Redecker, C. y Punie, Y. (2017). Digital Competence of Educators DigCompEdu. Publica-tions Office of the European Union. |

| ○ | Robles, J. M., Antino, M., De Marco, S. y Lobera, J. A. (2016). La nueva frontera de la desigualdad digital: la brecha participativa. Revista Española de Investigaciones Sociológicas, 156, 97-116. http:s//www.reis.cis.es/REIS/PDF/REIS_156_061475836475882.pdf |

| ○ | Ryu, E. (2011). Effects of skewness and kurtosis on normal-theory based maximum likelihood test statistic in multilevel structural equation modelling. Behavior Research Methods, 43(4), 1066-1074. https://doi.org//10.3758/s13428-011-0115-7 |

| ○ | Schmidt, D. A., Baran, E., Thompson, A. D., Mishra, P., Koehler, M. J. y Shin, T. S. (2009). Technological pedagogical content knowledge (TPACK): the development and validation of an assessment instrument for preservice teachers. Journal of Research on Technology in Education, 42(2), 123-149. https://doi.org/10.1080/15391523.2009.10782544 |

| ○ | Seçer, İ. (2013). SPSS ve LISREL ile pratik veri analizi ve raporlaştırma. Turquía. Anı Yayıncılık. https://aniyayincilik.com.tr/public/assets/catalogs/0527333001533121850.pdf |

| ○ | Shulman, L.S. (1986). Those who understand: knowledge growth in teaching. Educational Researcher, 15(2), 4-14. https://www.jstor.org/stable/1175860 |

| ○ | UNESCO (2019). Marco de competencias de los docentes en materia de TIC UNESCO. https://unesdoc.unesco.org/ark:/48223/pf0000371024 |

| ○ | UNESCO (2019). Rationales and recommendations for gender-equal digital skills education. https://unesdoc.unesco.org/ark:/48223/pf0000367416/PDF/367416eng.pdf.multi |

| ○ | Yelland, N. y Rubin, A. (eds.) (2002). Ghosts in the Machine: Women’s Voices in Research with Technology. Peter Lang Publishing. |

Anexo

Cuestionario-constructo de la investigación escala Likert 5 puntos

(5. Totalmente de acuerdo; 4. De acuerdo; 3. Ni de acuerdo, ni en desacuerdo; 2. En desacuerdo; 1. Muy en desacuerdo)

Dimensión 1. Conocimiento tecnológico (TK)

- (TK1) Sé cómo resolver mis propios problemas técnicos.

5) Totalmente de acuerdo

4) De acuerdo

3) Ni de acuerdo, ni en desacuerdo

2) En desacuerdo

1) Muy en desacuerdo

- (TK2) Puedo aprender el uso de tecnología fácilmente.

5) Totalmente de acuerdo

4) De acuerdo

3) Ni de acuerdo, ni en desacuerdo

2) En desacuerdo

1) Muy en desacuerdo

- (TK3) Me mantengo al día con las nuevas tecnologías importantes.

5) Totalmente de acuerdo

4) De acuerdo

3) Ni de acuerdo, ni en desacuerdo

2) En desacuerdo

1) Muy en desacuerdo

- (TK4) Tengo las habilidades técnico-manipulativas que necesito para usar la tecnología.

5) Totalmente de acuerdo

4) De acuerdo

3) Ni de acuerdo, ni en desacuerdo

2) En desacuerdo

1) Muy en desacuerdo

Dimensión 2. Conocimiento del contenido (CK)

- (CK1) Tengo suficiente conocimiento sobre el contenido que enseñará en mi futura labor como docente.

5) Totalmente de acuerdo

4) De acuerdo

3) Ni de acuerdo, ni en desacuerdo

2) En desacuerdo

1) Muy en desacuerdo

- (CK2) Tengo varias formas y estrategias para desarrollar mi comprensión del contenido que enseñaré en mi futura labor como docente.

5) Totalmente de acuerdo

4) De acuerdo

3) Ni de acuerdo, ni en desacuerdo

2) En desacuerdo

1) Muy en desacuerdo

- (CK3) Tengo una variedad de métodos y estrategias para mejorar mi comprensión del contenido que enseñaré en mi futura labor como docente.

5) Totalmente de acuerdo

4) De acuerdo

3) Ni de acuerdo, ni en desacuerdo

2) En desacuerdo

1) Muy en desacuerdo

- (CK4) Puedo reflexionar sobre el contenido del currículo del nivel educativo que imparto de la manera en que lo hace una/un experta/o en dicho nivel educativo.

5) Totalmente de acuerdo

4) De acuerdo

3) Ni de acuerdo, ni en desacuerdo

2) En desacuerdo

1) Muy en desacuerdo

Dimensión 3. Conocimiento pedagógico (PK)

- (PK1) Sé cómo evaluar el aprendizaje del alumnado en el aula.

5) Totalmente de acuerdo

4) De acuerdo

3) Ni de acuerdo, ni en desacuerdo

2) En desacuerdo

1) Muy en desacuerdo

- (PK2) Puedo adaptar mi enseñanza según lo que los estudiantes entienden o no entienden a lo largo del proceso de aprendizaje.

5) Totalmente de acuerdo

4) De acuerdo

3) Ni de acuerdo, ni en desacuerdo

2) En desacuerdo

1) Muy en desacuerdo

- (PK3) Puedo adaptar mi estilo de enseñanza a diferentes estudiantes.

5) Totalmente de acuerdo

4) De acuerdo

3) Ni de acuerdo, ni en desacuerdo

2) En desacuerdo

1) Muy en desacuerdo

- (PK4) Puedo evaluar el aprendizaje de los estudiantes de múltiples maneras.

5) Totalmente de acuerdo

4) De acuerdo

3) Ni de acuerdo, ni en desacuerdo

2) En desacuerdo

1) Muy en desacuerdo

- (PK5) Puedo usar una amplia gama de enfoques de enseñanza en un salón de clases.

5) Totalmente de acuerdo

4) De acuerdo

3) Ni de acuerdo, ni en desacuerdo

2) En desacuerdo

1) Muy en desacuerdo

- (PK6) Estoy familiarizada/o con los entendimientos y conceptos erróneos comunes de los estudiantes.

5) Totalmente de acuerdo

4) De acuerdo

3) Ni de acuerdo, ni en desacuerdo

2) En desacuerdo

1) Muy en desacuerdo

- (PK7) Sé cómo organizar y mantener la gestión del aula.

5) Totalmente de acuerdo

4) De acuerdo

3) Ni de acuerdo, ni en desacuerdo

2) En desacuerdo

1) Muy en desacuerdo

Dimensión 4. Conocimiento pedagógico del contenido (PCK)

- (PCK1) Puedo seleccionar enfoques de enseñanza efectivos para guiar el pensamiento y el aprendizaje de los estudiantes en las áreas de contenido que impartiré en mi futura labor como docente.

5) Totalmente de acuerdo

4) De acuerdo

3) Ni de acuerdo, ni en desacuerdo

2) En desacuerdo

1) Muy en desacuerdo

- (PCK2) La formación recibida me ha enseñado a ayudar al alumnado en la resolución de los problemas del mundo real relacionados con los contenidos disciplinares que enseñaré en mi labor como docente.

5) Totalmente de acuerdo

4) De acuerdo

3) Ni de acuerdo, ni en desacuerdo

2) En desacuerdo

1) Muy en desacuerdo

- (PCK3) La formación recibida me ha habilitado para poder seleccionar las herramientas de evaluación adecuadas para calificar el trabajo de los estudiantes en su aprendizaje.

5) Totalmente de acuerdo

4) De acuerdo

3) Ni de acuerdo, ni en desacuerdo

2) En desacuerdo

1) Muy en desacuerdo

Dimensión 5. Conocimiento tecnológico del contenido (TCK)

- (TCK1) Sé cómo evaluar el desempeño del alumnado en un aula.

5) Totalmente de acuerdo

4) De acuerdo

3) Ni de acuerdo, ni en desacuerdo

2) En desacuerdo

1) Muy en desacuerdo

- (TCK2) La formación recibida me ha capacitado para el uso de herramientas de software y hardware específicas para la enseñanza.

5) Totalmente de acuerdo

4) De acuerdo

3) Ni de acuerdo, ni en desacuerdo

2) En desacuerdo

1) Muy en desacuerdo

- (TCK3) Los cursos en los que he participado me han enseñado qué TIC puedo aplicar para enseñar.

5) Totalmente de acuerdo

4) De acuerdo

3) Ni de acuerdo, ni en desacuerdo

2) En desacuerdo

1) Muy en desacuerdo

Dimensión 6. Conocimiento pedagógico tecnológico (TPK)

- (TPK1) Puedo elegir tecnologías que mejoren los enfoques de enseñanza para una lección.

5) Totalmente de acuerdo

4) De acuerdo

3) Ni de acuerdo, ni en desacuerdo

2) En desacuerdo

1) Muy en desacuerdo

- (TPK2) Puedo elegir tecnologías que mejoren el aprendizaje de los estudiantes para una lección.

5) Totalmente de acuerdo

4) De acuerdo

3) Ni de acuerdo, ni en desacuerdo

2) En desacuerdo

1) Muy en desacuerdo

- (TPK3) Mi programa de formación docente me ha llevado a pensar más profundamente acerca de cómo la tecnología podría influir en los enfoques de enseñanza para mi futura labor docente.

5) Totalmente de acuerdo

4) De acuerdo

3) Ni de acuerdo, ni en desacuerdo

2) En desacuerdo

1) Muy en desacuerdo

- (TPK4) Pienso de manera crítica sobre cómo usar la tecnología en el aula.

5) Totalmente de acuerdo

4) De acuerdo

3) Ni de acuerdo, ni en desacuerdo

2) En desacuerdo

1) Muy en desacuerdo

- (TPK5) Puedo adaptar el uso de las tecnologías que estoy aprendiendo a diferentes actividades de enseñanza.

5) Totalmente de acuerdo

4) De acuerdo

3) Ni de acuerdo, ni en desacuerdo

2) En desacuerdo

1) Muy en desacuerdo

- (TPK6) Puedo seleccionar tecnologías para usar en mi futura labor como docente, que mejoren lo que enseño, cómo enseño y aquello que aprenden los estudiantes.

5) Totalmente de acuerdo

4) De acuerdo

3) Ni de acuerdo, ni en desacuerdo

2) En desacuerdo

1) Muy en desacuerdo

- (TPK7) Puedo usar estrategias que combinan contenido, tecnologías y enfoques de enseñanza que he aprendido a lo largo de mi formación como docente.

5) Totalmente de acuerdo

4) De acuerdo

3) Ni de acuerdo, ni en desacuerdo

2) En desacuerdo

1) Muy en desacuerdo

- (TPK8) Puedo proporcionar liderazgo para ayudar a otras/os a coordinar el uso de contenidos, tecnologías y estrategias de enseñanza.

5) Totalmente de acuerdo

4) De acuerdo

3) Ni de acuerdo, ni en desacuerdo

2) En desacuerdo

1) Muy en desacuerdo

- (TPK9) Puedo elegir tecnologías que mejoren el contenido de una lección.

5) Totalmente de acuerdo

4) De acuerdo

3) Ni de acuerdo, ni en desacuerdo

2) En desacuerdo

1) Muy en desacuerdo

Dimensión 7. Conocimiento tecnológico pedagógico del contenido (TPACK)

- (TPACK1) Puedo enseñar lecciones que combinan adecuadamente el conocimiento del contenido, las tecnologías y los enfoques de enseñanza.

5) Totalmente de acuerdo

4) De acuerdo

3) Ni de acuerdo, ni en desacuerdo

2) En desacuerdo

1) Muy en desacuerdo

- (TPACK2) La formación recibida me ha capacitado para poder compaginar, de manera correcta, los contenidos, las TAC y las metodologías para la consecución de los conocimientos de la materia que impartiré.

5) Totalmente de acuerdo

4) De acuerdo

3) Ni de acuerdo, ni en desacuerdo

2) En desacuerdo

1) Muy en desacuerdo

Nota: ©Gómez-Trigueros, Universidad de Alicante, 4/03/2023

Abstract

Validation of the TPACK-DGG scale and its implementation to measure self-perception of teacher digital competencies and the digital gender gap in teacher training

INTRODUCTION. Among the skills that a teacher must possess is digital competence. This is a key skill to be able to participate in the current hyperconnected society of the 21st century. One of the main tasks of teachers is to train citizens for their full social integration. Thus, it becomes essential that teachers have digital skills for quality education, avoiding digital gaps also based on gender. METHOD. The objectives set are two: the first, to validate the TPACK-DGG scale to measure self-perception in teaching digital competencies and the digital gender gap; the second, to analyze the perceptions of self-efficacy of the TPACK-DGG model in future teachers in training. To achieve the first objective, the Panel of Experts and a pilot pilot test were used; For the second objective, the with a sample of 1,059 undergraduate and Master’s degree students. The SPSS v.26 statistical program was used to measure the psychometric properties of the instrument. RESULTS. The results obtained confirm that the TPACK-DGG model, created ad hoc and adapted to the Spanish context, has internal consistency, rigor and structural stability to serve as an instrument for measuring digital teaching competencies. Likewise, the persistence of the digital gender gap among teachers in training is confirmed, identified in significant differences between women and men, in two dimensions of the TPACK-DGG model. DISCUSSION. The instrument meets structural stability and internal consistency. The suitability of the TPACK-DGG instrument to measure the dimensions of self-perception in digital teaching competencies and the digital gender gap of future teachers is confirmed. These results emphasize the importance of continuing researching on the persistence of digital gaps in initial teacher training in Spanish faculties.

Keywords: TPACK-DGG, Instrument, Validation, Digital divide, Teacher training.

Résumé

Validation de l’échelle TPACK-DGG et sa mise en œuvre pour mesurer l’auto-perception des compétences numériques et l’écart numérique entre les sexes dans la formation des enseignants

INTRODUCTION. Parmi les compétences qu’un enseignant doit posséder figure la compétence numérique. Il s’agit d’une compétence clé pour pouvoir participer à la société hyperconnectée du 21ème siècle. L’une des missions principales des enseignants est de former les citoyens pour leur intégration à la société. Il devient donc essentiel que les enseignants possèdent des compétences numériques pour un enseignement de qualité en évitant les fractures numériques de genre. MÉTHODE. Les objectifs fixés sont au nombre de deux : le premier, valider l’échelle TPACK-DGG pour mesurer la perception de soi dans l’enseignement des compétences numériques ainsi que l’écart numérique existant entre les sexes ; la seconde, analyser les perceptions d’auto-efficacité du modèle TPACK-DGG chez les futurs enseignants en formation. Pour atteindre le premier objectif, le groupe d’experts et une approbation pilote ont été utilisés. Pour le deuxième objectif, l’instrument a été appliqué à un échantillon de 1 059 étudiants de Grade universitaire et de Master. Le programme statistique SPSS v.26 a été utilisé pour mesurer les propriétés psychométriques de l’instrument. RÉSULTATS. Les résultats obtenus confirment que le modèle TPACK-DGG, créé ad hoc et adapté au contexte espagnol, possède une cohérence interne, une rigueur et une stabilité structurelle pour servir d’instrument de mesure des compétences pédagogiques numériques. De même, la persistance de la fracture numérique entre les sexes parmi les enseignants en formation se confirme, identifiée par des différences significatives entre les femmes et les hommes dans deux dimensions du modèle TPACK-DGG. DISCUSSION. L’instrument répond à la stabilité structurelle et à la cohérence interne. L’adéquation de l’instrument TPACK-DGG pour mesurer les dimensions de la perception de soi dans les compétences pédagogiques numériques et l’écart numérique entre les sexes des futurs enseignants est confirmée. Ces résultats soulignent l’importance de poursuivre la recherche sur la persistance des fractures numériques dans la formation initiale des enseignants dans les facultés espagnoles.

Mots-clés: TPACK-DGG, Instrument, Validation, Fracture numérique, Formation des enseignants.

Perfil profesional de la autora

Isabel María Gómez-Trigueros